- Loi binomiale

-

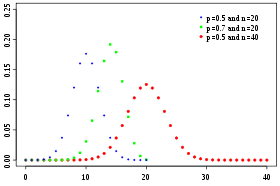

Binomiale Densité de probabilité / Fonction de masse

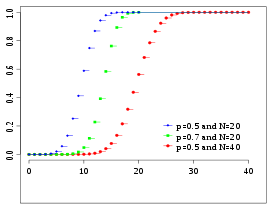

Fonction de répartition

Paramètres  nombre d'épreuves (entier)

nombre d'épreuves (entier)

probabilité de succès (réel)

probabilité de succès (réel)

q = 1 − pSupport

Densité de probabilité (fonction de masse)

Fonction de répartition

Espérance

Médiane (centre) un des  [1]

[1]Mode

Variance

Asymétrie

Kurtosis normalisé

Entropie

Fonction génératrice des moments

Fonction caractéristique

modifier

En mathématiques, une loi binomiale de paramètres n et p est une loi de probabilité qui correspond à l'expérience suivante :

On renouvelle n fois de manière indépendante une épreuve de Bernoulli de paramètre p (expérience aléatoire à deux issues possibles, généralement dénommées respectivement « succès » et « échec », la probabilité d'un succès étant p, celle d'un échec étant q = (1 − p)). On compte alors le nombre de succès obtenus à l'issue des n épreuves et on appelle X la variable aléatoire correspondant à ce nombre de succès.

L'univers

désigne l'ensemble des entiers naturels de 0 à n.

désigne l'ensemble des entiers naturels de 0 à n.La variable aléatoire suit une loi de probabilité définie par :

Cette formule fait intervenir le nombre des combinaisons de k éléments parmi n, généralement notée

ou

ou  , la première notation était préconisée en France pour l'enseignement des mathématiques en terminale scientifique[2] jusque 2004. Notons que ce nombre de combinaisons se distingue du nombre des arrangements de k éléments parmi n,

, la première notation était préconisée en France pour l'enseignement des mathématiques en terminale scientifique[2] jusque 2004. Notons que ce nombre de combinaisons se distingue du nombre des arrangements de k éléments parmi n,  , du fait que dans une combinaison l'ordre des éléments n'importe pas. Et comme il y a k! (prononcer factorielle k) façons d'ordonner k éléments, le nombre des combinaisons se déduit du nombre des arrangements par la simple division

, du fait que dans une combinaison l'ordre des éléments n'importe pas. Et comme il y a k! (prononcer factorielle k) façons d'ordonner k éléments, le nombre des combinaisons se déduit du nombre des arrangements par la simple division  et on obtient :

et on obtient :Cette loi de probabilité s'appelle la loi binomiale de paramètre (n ; p) et se note B(n ; p).

Sommaire

Calcul de p(k)

Une épreuve de Bernoulli conduit à la création d'un univers Ω = {S ; E}, (S pour Succès et E pour Echec).

n épreuves de Bernoulli indépendantes conduisent à la création d'un univers Ωn constitué de n-uplets d'éléments de Ω, sur lequel peut se définir une probabilité produit. La probabilité de l'éventualité (S, S, ..., S, E, E, ..., E) avec k succès et n - k échecs a donc pour valeur pkqn − k.

Plus généralement, tout n-uplet formé de k succès et de n-k échecs aura pour probabilité pkqn − k quel que soit l'ordre d'apparition des S et des E.

L'évènement « X = k » est formé de tous les n-uplets comportant k succès et n - k échecs. La combinatoire permet de déterminer le nombre de n-uplets de ce type : il y en a autant que de parties à k éléments d'un ensemble à n éléments ; or chaque partie correspond à une façon de placer les k succès parmi les n places du n-uplet. Il y a donc

n-uplets, chacun ayant une probabilité égale à pkqn − k.

n-uplets, chacun ayant une probabilité égale à pkqn − k.Donc

.

.Lien avec la loi de Bernoulli

Du fait de son interprétation comme loi du nombre de succès lors d'une série de n épreuves de Bernoulli indépendantes et identiques, la loi binomiale est en particulier la loi de la somme de n variables aléatoires indépendantes suivant toutes la (même) loi de Bernoulli de paramètre p, prenant la valeur 1 en cas de succès (probabilité p) et 0 en cas d'échec (probabilité (1-p)). Des exemples importants où la loi binomiale apparaît comme loi de la somme de variables de Bernoulli sont les suivants :

- l'étude des sondages,

- la fonction de répartition empirique,

- la fonction de répartition d'une statistique d'ordre, comme par exemple la médiane d'un échantillon, ou un quartile,

- l'étude, par Émile Borel, de la fréquence des différents chiffres dans le développement décimal d'un nombre réel, et sa démonstration du Théorème des nombres normaux[3].

Par ailleurs, cette interprétation en termes de sommes de variables de Bernoulli permet un calcul rapide de l'espérance et de la variance.

Espérance, variance, écart type

Ainsi X a la même loi que la somme S de n variables aléatoires indépendantes suivant toutes la (même) loi de Bernoulli de paramètre p. Comme l'espérance et la variance d'une variable aléatoire ne dépendent que de sa loi de probabilité, on en déduit que

- E[X] est donc la somme des espérances de ces variables de Bernoulli, or elles ont pour espérance p et pour variance p(1-p), soit E[X]=np

- de même, V(X) est la somme des variances de n variables de Bernoulli, soit V(X)=np(1-p)

Convergence

Pour de grandes valeurs de n, le calcul de

devient vite pratiquement impossible, sauf si l'on cherche à calculer le logarithme de cette expression au lieu de l'expression elle-même (et à condition d'utiliser l'approximation des factorielles par la formule de Stirling). On distingue deux cas :

devient vite pratiquement impossible, sauf si l'on cherche à calculer le logarithme de cette expression au lieu de l'expression elle-même (et à condition d'utiliser l'approximation des factorielles par la formule de Stirling). On distingue deux cas :- Lorsque n tend vers l'infini et que p tend vers 0 avec np = a, la loi binomiale converge vers une loi de Poisson de paramètre a. En pratique, on remplace la loi binomiale par une loi de Poisson dès que n > 30 et np < 5 ou dès que n > 50 et p < 0.1.

Démonstration de la convergence vers la loi PoissonDécomposons

On se place dans la situation où np reste constant et où n tend vers l'infini (par conséquent p tend vers 0).

- Lorsque n tend vers l'infini, les termes

tendent vers 1. Le produit des termes tend également vers 1 puisqu'ils sont en nombre fini.

tendent vers 1. Le produit des termes tend également vers 1 puisqu'ils sont en nombre fini. - On a (1 − p)n − k = (1 − p)n(1 − p) − k

- Or

- De plus,

et ce terme tend vers e-np quand n tend vers l'infini.

et ce terme tend vers e-np quand n tend vers l'infini.

- Or

On trouve donc

Il s'agit de la loi de probabilité d'une loi de Poisson de paramètre λ = np. .

.- Pour n assez grand, la loi binomiale se comporte comme une loi normale gaussienne d'espérance np et de variance npq. Plus précisément, le théorème de Moivre-Laplace précise que si Φ est la fonction de répartition de la loi normale centrée réduite

et si

et si  suit une loi binomiale de paramètres n et p, on a alors, pour tout réel

suit une loi binomiale de paramètres n et p, on a alors, pour tout réel  :

:

.

- Le théorème de Berry–Esseen (en) fournit une majoration de l'erreur commise quand on remplace

par

par  où Yn suit une loi normale d'espérance np et de variance npq : l'erreur commise est inférieure à

où Yn suit une loi normale d'espérance np et de variance npq : l'erreur commise est inférieure à  où C <0,4784.

où C <0,4784. - En pratique, on remplace une loi binomiale par une loi normale pour n grand et p pas trop proche de 0 ni de 1 (par exemple pour n > 30, np > 5 et nq > 5 ou pour npq>9)

Loi des grands nombres

La loi binomiale, son espérance et sa variance, ainsi que l'inégalité de Bienaymé-Tchebychev permettent de démontrer une version simple de la loi des grands nombres.

Références

- Hamza, K. (1995). The smallest uniform upper bound on the distance between the mean and the median of the binomial and Poisson distributions. Statist. Probab. Lett. 23 21–25.

- Bulletin Officiel n°4 du 30 aout 2001.

- Émile Borel, « Les probabilités dénombrables et leurs applications arithmétiques », dans Rendiconti del Circolo Matematico di Palermo, vol. 27, no 1, décembre 1909, p. 247-271 (ISSN 0009-725X et 1973-4409) [texte intégral, lien DOI].

Voir aussi

- Loi de Bernoulli

- Loi de Poisson

- Loi normale

- Loi multinomiale

- Probabilité

- Probabilité (mathématiques élémentaires)

- Variables aléatoires élémentaires

- Marche aléatoire

Lien externe

- Portail des probabilités et des statistiques

Wikimedia Foundation. 2010.