- Variance (statistiques et probabilites)

-

Variance (statistiques et probabilités)

Pour les articles homonymes, voir Variance.

Pour les articles homonymes, voir Variance.En statistique et probabilité, la variance est une mesure arbitraire servant à caractériser la dispersion d'une distribution ou d'un échantillon.

Sommaire

Définition

Soit X une variable aléatoire réelle dont le moment d'ordre 2, à savoir

, existe.

, existe.Définition —

étant l'espérance mathématique ; l'existence du moment d'ordre 2 implique celle de

étant l'espérance mathématique ; l'existence du moment d'ordre 2 implique celle de

On peut interpréter la variance comme la moyenne des carrés des écarts à la moyenne (rigoureusement: l'espérance des carrés des écarts à l'espérance, vulgairement: Moyenne des carrés moins le carré des moyennes). Elle permet de caractériser la dispersion des valeurs par rapport à la moyenne. Ainsi, une distribution avec une même espérance et une variance plus grande apparaîtra comme plus étalée. Le fait que l'on prenne le carré de ces écarts à la moyenne évite que des écarts positifs et négatifs ne s'annulent.

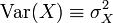

Notation — On note souvent:

Propriétés

- La variance est toujours positive ou nulle.

- Lorsque la variance est nulle, cela signifie que la variable aléatoire correspond à une constante (toutes les réalisations sont identiques).

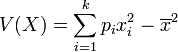

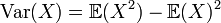

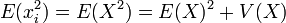

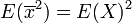

- Formule alternative de calcul de la variance:

Propriété —

-

- Cette formule s'énonce ainsi : la variance est égale à l'espérance du carré de X moins le carré de l'espérance de X. La formule permet souvent un calcul plus simple de la variance que la définition.

-

- Sa démonstration est faite dans le théorème de König-Huyghens.

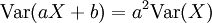

- Variance d'une transformation linéaire:

Propriété —

Démonstration

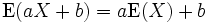

DémonstrationPour cette démonstration, il est utile de rappeler une des propriétés de l'espérance:

Propriété —

On a alors:

![\begin{align}\operatorname{Var}(aX+b)&

= E[(aX+b -E[aX+b])^2] \qquad \text{Selon definition de la variance}\\ &

= E[(aX+b -aE[X]-b)^2] \\&

= E[(aX -aE[X])^2]\\&

= E[a^2(X -E[X])^2]\\&

= a^2E[(X -E[X])^2]

\\&= a^2\operatorname{Var}(X) \end{align}](/pictures/frwiki/48/0f93cd34ed8f70e42182f6f512120f00.png)

-

- On remarque à travers cette propriété que le fait de déplacer simplement une distribution (ajouter +b) ne modifie pas sa variance. Par contre, changer l'échelle (multiplier par a) modifie la variance quadratiquement. Cette propriété permet également de confirmer la remarque établie précédemment que la variance d'une constante est nulle, en effet,

.

.

- On remarque à travers cette propriété que le fait de déplacer simplement une distribution (ajouter +b) ne modifie pas sa variance. Par contre, changer l'échelle (multiplier par a) modifie la variance quadratiquement. Cette propriété permet également de confirmer la remarque établie précédemment que la variance d'une constante est nulle, en effet,

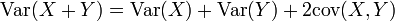

- Variance de la somme de deux variables

Si

désigne la covariance des variables aléatoires X et Y, alors:

désigne la covariance des variables aléatoires X et Y, alors:Propriété —

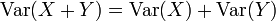

- Variance de la somme de deux variables indépendantes (et plus généralement non corrélées)

Propriété —

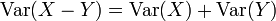

-

- Il faut faire attention au fait que

! Même si les variables sont soustraites, leur variances s'additionnent.

! Même si les variables sont soustraites, leur variances s'additionnent.

- Il faut faire attention au fait que

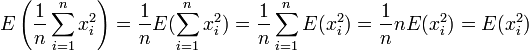

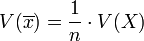

- Variance de la moyenne de variables indépendantes (ou 2 à 2 non corrélées) et de même variance σ2

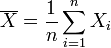

En définissant

Propriété —

Démonstration

Démonstration

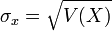

Ecart type

Article détaillé : écart type.L'écart type est la racine carrée de la variance:

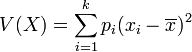

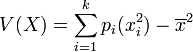

Cas discret

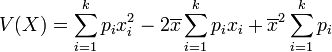

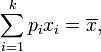

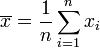

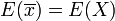

La variance V(X) représente la moyenne des carrés des écarts à la moyenne : elle permet de caractériser, tout comme l'écart type, la dispersion des valeurs xi par rapport à la moyenne, notée

ou encore E(X).

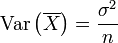

ou encore E(X).Soit une série statistique

de moyenne

de moyenne  et d'effectif total n (c’est-à-dire

et d'effectif total n (c’est-à-dire  et

et  ).

).La variance de cette série est alors :

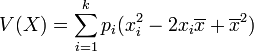

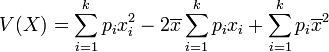

Simplification

La moyenne peut être considérée comme le barycentre de la série.

D'après le théorème de König , on a :

Démonstration

DémonstrationOr,

et

et  donc on a:

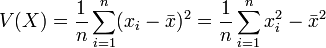

donc on a:Équiprobabilité

Dans le cas d'équiprobabilité,

Remarque: égalité toujours vraie, même s'il n'y a pas équiprobabilité! (cf développer le calcul et sortir la moyenne de la somme dans le terme croisé)

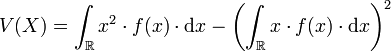

Cas continu

Dans le cas continu, la variance se calcule de la façon suivante :

Variance d'un vecteur aléatoire

Si l'on définit

comme un vecteur aléatoire qui comporte k variables et Μ comme le vecteur des k espérances de X, on définit alors la variance comme:

comme un vecteur aléatoire qui comporte k variables et Μ comme le vecteur des k espérances de X, on définit alors la variance comme:Définition —

![\Sigma_{k\times k} \equiv \operatorname{Var}[X_{k\times 1}]\equiv \mathbb{E}\left[(X_{k\times 1}-\Mu)(X_{k\times 1}-\Mu)'\right]](/pictures/frwiki/100/d56be731282b839a2a5026cacc14b977.png)

Il s'agit alors d'une matrice carrée de taille k, appelée matrice de variance-covariance, qui comporte sur sa diagonale les variances de chaque composante du vecteur aléatoire et en dehors de la diagonale les covariances. Cette matrice est symétrique et semi-définie positive ; elle est définie positive si et seulement si la seule combinaison linéaire certaine (c'est-à-dire presque sûrement constante) des composantes du vecteur aléatoire est celle dont tous les coefficients sont nuls.

On a les propriétés suivantes:

Propriété — Si V est une matrice carrée de taille

![k, \operatorname{Var}[V_{k\times k}X_{k\times 1}]=V\operatorname{Var}[X]V'](/pictures/frwiki/53/50fd6d95aa619f26c50c7c51ba86305d.png)

Estimation

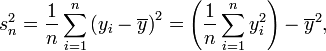

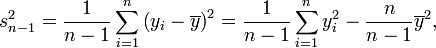

Deux estimateurs sont généralement utilisés pour la variance:

et

Propriétés

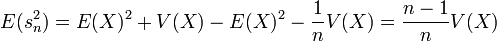

Biais

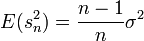

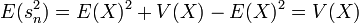

- L'estimateur

est biaisé:

est biaisé:

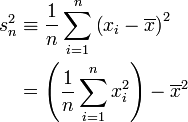

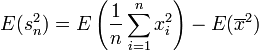

DémonstrationL'estimateur

est:

est: .

.

La deuxième égalité s'obtient d'après le théorème de König-Huyghens.

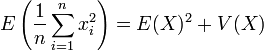

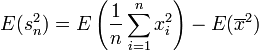

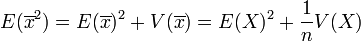

Nous allons calculer l'espérance de l'estimateur d'après la deuxième formule:

.

.

Il faut donc étudier l'espérance des deux termes, on verra que:

Démonstration .

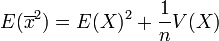

.On a supposé que tous les réalisations ont la même espérance: E(xi) = E(X) En appliquant de nouveau la formule de König-Huyghens:

.Démonstration

.DémonstrationEtudions au préalable l'espérance et la variance de la moyenne:

- La moyenne

de l'échantillon est une variable aléatoire (si on change les individus alors

de l'échantillon est une variable aléatoire (si on change les individus alors  varie):

varie):

- -d'espérance

- -de variance:

(la moyenne de n variables aléatoires fluctue moins qu'une seule variable aléatoire)

(la moyenne de n variables aléatoires fluctue moins qu'une seule variable aléatoire)

- -d'espérance

En appliquant de nouveau la formule de König-Huyghens:

.

.On a donc

.

.- La variance s de l'échantillon fluctue donc autour de

et non autour de V(X) comme on aurait pu s'y attendre.

et non autour de V(X) comme on aurait pu s'y attendre.

- L'estimateur

est sans biais.

est sans biais.

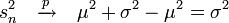

Démonstration — En effet, il suffit de corriger l'estimateur

en le multipliant par

en le multipliant par  pour avoir un estimateur sans biais:

pour avoir un estimateur sans biais: ![E\left[\frac{n}{n-1} s^2_{n}\right]= \frac{n}{n-1} E[s^2_{n}]=\frac{n}{n-1} \frac{n-1}{n}\sigma^2=\sigma^2](/pictures/frwiki/56/8e50ebdefd648d0d1d0b4e10c15b9788.png)

Pourquoi n-1?

Le fait que l'estimateur de la variance doive être divisé par n-1 (et donc dans un certain sens moins précis) pour être sans biais provient du fait que l'estimation de la variance implique l'estimation d'un paramètre en plus, l'espérance. Cette correction tient compte donc du fait que l'estimation de l'espérance induit une incertitude de plus. En effet:

Théorème — si l'on suppose que l'espérance est connue, l'estimateur

est sans biaisDémonstration

est sans biaisDémonstrationen reprenant la démonstration du biais de

lorsque l'espérance est inconnue, on avait montré que:

lorsque l'espérance est inconnue, on avait montré que:  . Puis calculé que:

. Puis calculé que:Cependant, le deuxième calcul est désormais différent: E[X] étant connu, on pose que E[X] = μ et on a: E[μ2] = E[μ]2

Donc on a directement:

.

.La formule devient alors:

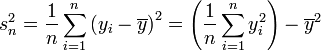

Convergence

Les estimateurs

et

et  sont convergents en probabilité.

sont convergents en probabilité.Théorème —

et

et  si les observations sont iid (μ,σ2).Démonstration

si les observations sont iid (μ,σ2).DémonstrationRéecrivons l'estimateur:

Et étudions la convergence des termes séparément:

par le théorème de Slutsky (en).

par le théorème de Slutsky (en).![\frac 1n \sum_{i=1}^n \left(y_i - \overline{y} \right)^ 2 \xrightarrow{p} \quad \operatorname{E}[x^2]= \mu^2+\sigma^2](/pictures/frwiki/51/3839c2631c6fc359cd668ee9dd0ddabb.png) par la loi des grands nombres.

par la loi des grands nombres.

Alors

Comme ce résultat est asymptotique, il s'applique également à

, qui est asymptotiquement équivalent à

, qui est asymptotiquement équivalent à

Distribution des estimateurs

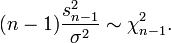

En tant que fonction de variables aléatoires, l'estimateur de la variance est également une variable aléatoire. Sous l'hypothèse que les yi sont des observations indépendantes d'une loi normale, le théorème de Cochran (en) montre que

suit une loi du χ²:

suit une loi du χ²:En conséquence, il suit que

. Cette propriété d'absence de biais peut cependant être démontrée même sans l'hypothèse de normalité des observations.

. Cette propriété d'absence de biais peut cependant être démontrée même sans l'hypothèse de normalité des observations.Méthodes de calcul

Le calcul par ordinateur de la variance empirique peut poser certains problèmes, notamment à cause de la somme des carrés. La page anglaise: Algorithms for calculating variance décrit le problème ainsi que des algorithmes proposés.

Voir aussi

- Portail des probabilités et des statistiques

Catégories : Statistique descriptive | Probabilités

Wikimedia Foundation. 2010.