- I.A.

-

Intelligence artificielle

L'intelligence artificielle est la « recherche de moyens susceptibles de doter les systèmes informatiques de capacités intellectuelles comparables à celles des êtres humains »[1].

Définition

Le terme intelligence artificielle, créé par John McCarthy, est souvent abrégé par le sigle IA. Il est défini par l’un de ses créateurs, Marvin Lee Minsky, comme « la construction de programmes informatiques qui s’adonnent à des tâches qui sont, pour l’instant, accomplies de façon plus satisfaisante par des êtres humains car elles demandent des processus mentaux de haut niveau tels que : l’apprentissage perceptuel, l’organisation de la mémoire et le raisonnement critique ».[réf. nécessaire] On y trouve donc le côté « artificiel » atteint par l'usage des ordinateurs ou de processus électroniques élaborés et le côté « intelligence » associé à son but d'imiter le comportement. Cette imitation peut se faire dans le raisonnement, par exemple dans les jeux ou la pratique de mathématiques, dans la compréhension des langues naturelles, dans la perception : visuelle (interprétation des images et des scènes), auditive (compréhension du langage parlé) ou par d'autres capteurs, dans la commande d'un robot dans un milieu inconnu ou hostile.

Même si elles respectent globalement la définition de Minsky, il existe un certain nombre de définitions différentes de l'IA qui varient sur deux points fondamentaux[2] :

- Les définitions qui lient la définition de l'IA à un aspect humain de l'intelligence, et celles qui la lient à un modèle idéal d'intelligence, non forcément humaine, nommée rationalité.

- Les définitions qui insistent sur le fait que l'IA a pour but d'avoir toutes les apparences de l'intelligence (humaine ou rationnelle), et celles qui insistent sur le fait que le fonctionnement interne du système IA doit ressembler également à celui de l'être humain ou être rationnel.

Deep Blue, le premier ordinateur à battre un champion du monde d'échec en titre.

Deep Blue, le premier ordinateur à battre un champion du monde d'échec en titre.

Histoire

L'origine de l'intelligence artificielle se trouve probablement dans l'article d'Alan Turing « Computing Machinery and Intelligence » (Mind, octobre 1950)[3], où Turing explore le problème et propose une expérience maintenant connue sous le nom de test de Turing dans une tentative de définition d'un standard permettant de qualifier une machine de « consciente ». Il développe cette idée dans plusieurs forums, dans la conférence « L'intelligence de la machine, une idée hérétique »[4], dans la conférence qu'il donne à la BBC 3e programme le 15 mai 1951 « Est-ce que les calculateurs numériques peuvent penser ? »[5] ou la discussion avec M.H.A. Newman, AMT, Sir Geoffrey Jefferson et R.B. Braithwaite le 14 et 23 Jan. 1952 sur le thème « Est-ce que les ordinateurs peuvent penser? »[6].

On considère que l'intelligence artificielle, en tant que domaine de recherche, a été créée à la conférence qui s'est tenue sur le campus de Dartmouth College pendant l'été 1956[7] à laquelle assistaient ceux qui vont marquer la discipline. Ensuite l'intelligence se développe surtout aux États-Unis à l'université Stanford sous l'impulsion de John McCarthy, au MIT sous celle de Marvin Minsky, à l'université Carnegie Mellon sous celle de Allen Newell et Herbert Simon et à l'université d'Édimbourg sous celle de Donald Michie. En France, l'un des pionniers est Jacques Pitrat.

Intelligence artificielle forte

Définition

Le concept d’intelligence artificielle forte fait référence à une machine capable non seulement de produire un comportement intelligent, mais d’éprouver une impression d'une réelle conscience de soi, de « vrais sentiments » (quoi qu’on puisse mettre derrière ces mots), et « une compréhension de ses propres raisonnements » [réf. nécessaire].

L’intelligence artificielle forte a servi de moteur à la discipline, mais a également suscité de nombreux débats. En se fondant sur le constat que la conscience a un support biologique et donc matériel, la plupart des scientifiques ne voient pas d’obstacle de principe à créer un jour une intelligence consciente sur un support matériel autre que biologique. Selon les tenants de l'IA forte, si à l'heure actuelle il n'y a pas d'ordinateurs ou de robots aussi intelligents que l'être humain, ce n'est pas un problème d'outil mais de conception. Il n'y aurait aucune limite fonctionnelle (un ordinateur est une machine de Turing universelle avec pour seules limites les limites de la calculabilité), il n'y aurait que des limites liées à l'aptitude humaine à concevoir le programme approprié. Elle permet notamment de modéliser des idées abstraites.

Estimation de faisabilité

On peut être tenté de comparer la capacité de traitement de l'information d'un cerveau humain à celle d'un ordinateur pour estimer la faisabilité d'une IA forte. Il s'agit cependant d'un exercice purement spéculatif, et la pertinence de cette comparaison n'est pas établie. Cette estimation très grossière est surtout destinée à préciser les ordres de grandeur en présence.

Un ordinateur typique de 1970 effectuait 107 opérations logiques par seconde, et occupait donc - géométriquement - une sorte de milieu entre une balance de Roberval (1 opération logique par seconde) et le cerveau humain (grossièrement 2 x 1014 opérations logiques par seconde, car formé de 2 x 1012 neurones ne pouvant chacun commuter plus de 100 fois par seconde)[réf. nécessaire].

En 2005, un microprocesseur typique traite 64 bits en parallèle (128 dans le cas de machines à double cœur) à une vitesse typique de 2 GHz, ce qui place en puissance brute dans les 1011 opérations logiques par seconde. En ce qui concerne ces machines destinées au particulier, l'écart s'est donc nettement réduit. En ce qui concerne les machines comme Blue Gene, il a même changé de sens.

Le matériel serait donc maintenant présent. Du logiciel à la mesure de ce matériel resterait à développer. En effet, l'important n'est pas de raisonner plus vite, en traitant plus de données, ou en mémorisant plus de choses que le cerveau humain, l'important est de traiter les informations de manière appropriée.

L'IA souligne la difficulté à expliciter toutes les connaissances utiles à la résolution d'un problème complexe. Certaines connaissances dites implicites sont acquises par l'expérience et mal formalisables. Par exemple, qu'est-ce qui distingue un visage familier de deux cents autres ? Nous ne savons clairement l'exprimer.

L'apprentissage de ces connaissances implicites par l'expérience semble une voie prometteuse (voir Réseau de neurones). Néanmoins, un autre type de complexité apparaît, la complexité structurelle. Comment mettre en relation des modules spécialisés pour traiter un certain type d'informations, par exemple un système de reconnaissance des formes visuelles, un système de reconnaissance de la parole, un système lié à la motivation, à la coordination motrice, au langage, etc. En revanche, une fois un tel système conçu et un apprentissage par l'expérience réalisé, l'intelligence du robot pourrait probablement être dupliquée en grand nombre d'exemplaires.

Diversité des opinions

Les principales opinions soutenues pour répondre à la question d’une intelligence artificielle consciente sont les suivantes :

- Impossible : la conscience serait le propre des organismes vivants, et elle serait liée à la nature des systèmes biologiques. Cette position est défendue principalement par des philosophes et des religieux.

- Problème : Elle rappelle toutefois toutes les controverses passées entre vitalistes et matérialistes, l'histoire ayant à plusieurs reprises infirmé les positions des premiers.

- Impossible avec des machines manipulant des symboles comme les ordinateurs actuels, mais possible avec des systèmes dont l’organisation matérielle serait fondée sur des processus quantiques. Cette position est défendue notamment par Roger Penrose. Des algorithmes quantiques sont théoriquement capables de mener à bien des calculs hors de l'atteinte pratique des calculateurs conventionnels (complexité en

au lieu de

au lieu de  , par exemple, sous réserve d'existence du calculateur approprié). Au-delà de la rapidité, le fait que l'on puisse envisager des systèmes quantiques en mesure de calculer des fonctions non-turing-calculables (voir Hypercalcul) ouvre des possibilités qui - selon cet auteur - sont fondamentalement interdites aux machines de Turing.

, par exemple, sous réserve d'existence du calculateur approprié). Au-delà de la rapidité, le fait que l'on puisse envisager des systèmes quantiques en mesure de calculer des fonctions non-turing-calculables (voir Hypercalcul) ouvre des possibilités qui - selon cet auteur - sont fondamentalement interdites aux machines de Turing.

- Problème : On ne dispose pas encore pour le moment d'algorithmes d'IA à mettre en œuvre dessus. Tout cela reste donc spéculatif.

- Impossible avec des machines manipulant des symboles comme les ordinateurs actuels, mais possible avec des systèmes dont l’organisation matérielle mimerait le fonctionnement du cerveau humain, par exemple avec des circuits électroniques spécialisés reproduisant le fonctionnement des neurones.

- Problème : Le système en question répondant exactement de la même façon que sa simulation sur ordinateur - toujours possible - au nom de quel principe leur assigner une différence ?[8]

- Impossible avec les algorithmes classiques manipulant des symboles (logique formelle), car de nombreuses connaissances sont difficiles à expliciter mais possible avec un apprentissage par l'expérience de ces connaissances à l'aide d'outils tels que des réseaux de neurones formels, dont l'organisation logique et non matérielle s'inspire des neurones biologiques, et utilisés avec du matériel informatique conventionnel.

- Problème : si du matériel informatique conventionnel est utilisé pour réaliser un réseau de neurones, alors il est possible de réaliser l'IA avec les ordinateurs classiques manipulant des symboles (puisque ce sont les mêmes machines, voir Thèse de Church-Turing). Cette position parait donc incohérente. Toutefois, ses défenseurs (thèse de l'IA forte) arguent que l'impossibilité en question est liée à notre inaptitude à tout programmer de manière explicite, elle n'a rien à voir avec une impossibilité théorique. Par ailleurs, ce que fait un ordinateur, un système à base d'échanges de bouts de papier dans une salle immense peut le simuler quelques milliards de fois plus lentement. Or il peut rester difficile à admettre que cet échange de bouts de papiers « ait une conscience ». Voir Chambre chinoise. Selon les tenants de l'IA forte, cela ne pose toutefois pas de problème.

- Impossible car la pensée n'est pas un phénomène calculable par des processus discrets et finis. Pour passer d'un état de pensée au suivant, il y a une infinité non dénombrable, une continuité d'états transitoires. Cette idée est réfutée par Alain Cardon (Modéliser et concevoir une Machine pensante).

- Possible avec des ordinateurs manipulant des symboles. La notion de symbole est toutefois à prendre au sens large. Cette option inclut les travaux sur le raisonnement ou l'apprentissage symbolique basé sur la logique des prédicats, mais aussi les techniques connexionnistes telles que les réseaux de neurones, qui, à la base, sont définies par des symboles. Cette dernière opinion constitue la position la plus engagée en faveur de l'intelligence artificielle forte.

Des auteurs comme Hofstadter (mais déjà avant lui Arthur C. Clarke ou Alan Turing) (voir le test de Turing) expriment par ailleurs un doute sur la possibilité de faire la différence entre une intelligence artificielle qui éprouverait réellement une conscience, et une autre qui simulerait exactement ce comportement. Après tout, nous ne pouvons même pas être certains que d’autres consciences que la nôtre (chez des humains s’entend) éprouvent réellement quoi que ce soit. On retrouve là le problème connu du solipsisme en philosophie.

Travaux complémentaires

- Le mathématicien de la physique Roger Penrose[9] pense que la conscience viendrait de l'exploitation de phénomènes quantiques dans le cerveau (voir microtubules), empêchant la simulation réaliste de plus de quelques dizaines de neurones sur un ordinateur normal, d’où les résultats encore très partiels de l’IA. Il restait jusqu’à présent isolé sur cette question. Un autre chercheur a présenté depuis une thèse de même esprit quoique moins radicale : Andrei Kirilyuk[10]

- Cette spéculation reste néanmoins marginale par rapport aux travaux des neurosciences. L'action de phénomènes quantiques est évidente dans le cas de la rétine (quelques quanta de lumière seulement suffisent à une perception) ou de l'odorat, mais elle ne constitue pas une condition préalable à un traitement efficace de l'information. En effet, le traitement de l'information effectué par le cerveau est relativement robuste et ne dépend pas de l'état quantique de chaque molécule, ni même de la présence ou de la connexion de neurones isolés.

Cela dit, l’intelligence artificielle est loin de se limiter aux seuls réseaux de neurones, qui ne sont généralement utilisés que comme classifieurs. Les techniques de résolution générale de problèmes et la logique des prédicats[11], entre autres, ont fourni des résultats spectaculaires et sont exploités par les ingénieurs dans de nombreux domaines.

Intelligence artificielle faible

La notion d’intelligence artificielle faible constitue une approche pragmatique d’ingénieur : chercher à construire des systèmes de plus en plus autonomes (pour réduire le coût de leur supervision), des algorithmes capables de résoudre des problèmes d’une certaine classe, etc. Mais, cette fois, la machine simule l'intelligence, elle semble agir comme si elle était intelligente. On en voit des exemples concrets avec les programmes qui tentent de passer le test de Turing, comme ELIZA. Ces programmes parviennent à imiter de façon grossière le comportement d'humains face à d'autres humains lors d'un dialogue. Ces programmes « semblent » intelligents, mais ne le sont pas. Les tenants de l'IA forte admettent qu'il y a bien dans ce cas une simulation de comportements intelligents, mais qu'il est aisé de le découvrir et qu'on ne peut donc généraliser. En effet, si on ne peut différencier expérimentalement deux comportements intelligents, celui d'une machine et celui d'un humain, comment peut-on prétendre que les deux choses ont des propriétés différentes ? Le terme même de « simulation de l'intelligence » est contesté et devrait, toujours selon eux, être remplacé par « reproduction de l'intelligence ».

Les tenants de l'IA faible arguent que la plupart des techniques actuelles d’intelligence artificielle sont inspirées de leur paradigme. Ce serait par exemple la démarche utilisée par IBM dans son projet nommé Autonomic computing. La controverse persiste néanmoins avec les tenants de l'IA forte qui contestent cette interprétation.

Simple évolution, donc, et non révolution : l’intelligence artificielle s’inscrit à ce compte dans la droite succession de ce qu’ont été la recherche opérationnelle dans les années 1960, le process control dans les années 1970, l’aide à la décision dans les années 1980 et le data mining dans les années 1990. Et, qui plus est, avec une certaine continuité.

Il s'agit surtout d'intelligence humaine reconstituée, et de programmation d'un apprentissage.

Estimation de faisabilité

Critères possibles d'un système de dialogue évolué

Le sémanticien François Rastier, après avoir rappelé les positions de Turing et de Grice à ce sujet, propose[12] six « préceptes » conditionnant un système de dialogue évalué, en précisant qu'elles déjà sont mises en œuvre par des systèmes existants :

- objectivité (utilisation d'une base de connaissances par le système)

- textualité (prise en compte d'interventions de plus d'une phrase, qu'elles émanent du système ou de l'utilisateur)

- apprentissage (intégration au moins temporaire d'informations issues des propos de l'utilisateur)

- questionnement (demande de précisions de la part du système)

- rectification (suggestion de rectifications à la question posée, lorsque nécessaire)

- explicitation (explicitation par le système d'une réponse qu'il a apportée précédemment).

Il suggère aussi que le système devrait être en mesure de se faire par lui-même une représentation de l'utilisateur auquel il a affaire, pour s'adapter à lui. De son côté, l'utilisateur a tendance à s'adapter au système à partir du moment où il a bien compris qu'il s'adresse à une machine : il ne conversera pas de la même manière avec un système automatisé qu'avec un interlocuteur humain, ce qui présente pour le concepteur l'avantage pragmatique de simplifier certains aspects du dialogue.

Courants de pensée

La cybernétique naissante des années quarante revendiquait très clairement son caractère pluridisciplinaire et se nourrissait des contributions les plus diverses : neurophysiologie, psychologie, logique, sciences sociales… Et c’est tout naturellement qu’elle envisagea deux approches des systèmes, deux approches reprises par les sciences cognitives et de ce fait l’intelligence artificielle :

- une approche par la décomposition (du haut vers le bas),

- une approche contraire par construction progressive du bas vers le haut.

Ces deux approches se révèlent plutôt complémentaires que contradictoires : on est à l'aise pour décomposer rapidement ce que l'on connaît bien, et une approche pragmatique à partir des seuls élements que l'on connaît afin de se familiariser avec les concepts émergents est plus utile pour le domaines inconnus. Elles sont respectivement à la base des hypothèses de travail que constituent le cognitivisme et le connexionnisme, qui tentent aujourd'hui (2005) d'opérer progressivement leur fusion.

Cognitivisme

Le cognitivisme considère que le vivant, tel un ordinateur (bien que par des procédés évidemment très différents), manipule essentiellement des symboles élémentaires. Dans son livre La société de l’esprit, Marvin Minsky, s’appuyant sur des observations du psychologue Jean Piaget envisage le processus cognitif comme une compétition d’agents fournissant des réponses partielles et dont les avis sont arbitrés par d’autres agents. Il cite les exemples suivants de Piaget :

- L’enfant croit d’abord que plus le niveau d’eau est élevé dans un verre, plus il y a d’eau dans ce verre. Après avoir joué avec des transvasements successifs, il intègre le fait que la notion de hauteur du liquide dans le verre entre en compétition avec celle du diamètre du verre, et arbitre de son mieux entre les deux.

- Il vit ensuite une expérience analogue en manipulant de la pâte à modeler : la réduction de plusieurs objets temporairement représentés à une même boule de pâte l’incite à dégager un concept de conservation de la quantité de matière.

Au bout du compte, ces jeux d’enfants se révèlent essentiels à la formation de l’esprit, qui dégagent quelques règles pour arbitrer les différents éléments d’appréciation qu’il rencontre, par essais et erreurs.

Connexionnisme

Le connexionnisme, se référant aux processus auto-organisationnels, envisage la cognition comme le résultat d’une interaction globale des parties élémentaires d’un système. On ne peut nier que le chien dispose d'une sorte de connaissance des équations différentielles du mouvement, puisqu’il arrive à attraper un bâton au vol. Et pas davantage qu’un chat ait aussi une sorte de connaissance de la loi de chute des corps, puisqu’il se comporte comme s’il savait à partir de quelle hauteur il ne doit plus essayer de sauter directement pour se diriger vers le sol. Cette faculté qui évoque un peu l’intuition des philosophes se caractériserait par la prise en compte et la consolidation d’éléments perceptifs dont aucun pris isolément n’atteint le seuil de la conscience, ou en tout cas n’y déclenche d’interprétation particulière.

Synthèse

Trois concepts reviennent de façon récurrente dans la plupart des travaux :

- la redondance (le système est peu sensible à des pannes ponctuelles)

- la réentrance (les composants s'informent en permanence entre eux; cette notion diffère de la réentrance en programmation)

- la sélection (au fil du temps, les comportements efficaces sont dégagés et renforcés)

Les différentes facettes de l'intelligence artificielle

On peut considérer différents dispositifs intervenant, ensemble ou séparément, dans un système d’intelligence artificielle tels que :

- Le dialogue automatique : se faire comprendre en lui parlant,

- Traduction automatique, si possible en temps réel ou très légèrement différé, comme dans le film « Dune »,

- Le traitement automatique des langues,

- Le raisonnement automatique (cf.systèmes experts),

- L’apprentissage automatique,

- La reconnaissance de formes, des visages et la vision en général, etc.

- Intégration automatique d’informations provenant de sources hétérogènes, (fusion de données)

- L'émotion artificielle. (cf. les travaux de Rosalind Picard sur l'émotion)

- Etc.

Les réalisations actuelles de l’intelligence artificielle peut intervenir dans des fonctions:

- Aide aux diagnostics.

- L'aide à la décision.

- Résolution de problèmes complexes, tels que les problèmes d'allocation de resources.

- Assistance par des machines dans les tâches dangereuses, ou demandant une grande précision,

- Automatisation de taches

- etc.

La conception de systèmes d'IA

Au fil du temps, certains langages de programmation se sont avérés plus commodes que d’autres pour écrire des applications d’intelligence artificielle. Parmi ceux-ci, Lisp et Prolog furent sans doute les plus médiatisés. Lisp constituait une solution ingénieuse pour faire de l’intelligence artificielle en FORTRAN. ELIZA (le premier chatterbot, donc pas de la « véritable » intelligence artificielle) tenait en trois pages de SNOBOL.

On utilise aussi, plus pour des raisons de disponibilité et de performance que de commodité, des langages classiques tels que C ou C++. Lisp a eu pour sa part une série de successeurs plus ou moins inspirés de lui, dont le langage Scheme.

Des programmes de démonstration de théorèmes géométriques simples ont existé dès les années 1960; et des logiciels aussi triviaux que Maple et Mathematica effectuent aujourd’hui des travaux d’intégration symbolique qui il y a trente ans encore étaient du ressort d’un étudiant de mathématiques supérieures. Mais ces programmes ne savent pas plus qu’ils effectuent des démonstrations géométriques ou algébriques que Deep Blue ne savait qu’il jouait aux échecs (ou un programme de facturation qu’il calcule une facture). Ces cas représentent donc plus des opérations intellectuelles assistées par ordinateur faisant appel à la puissance de calcul que de l'intelligence artificielle à proprement parler[13].

Domaines d’application

L'intelligence artificielle a été et est utilisé (ou interviennent) dans une variété de domaines tels que:

- La banque. Avec des systèmes experts d'évaluation de risque lié à l'octroit d'un crédit.

- Le militaire. Dans les systèmes autonômes tels que les drônes, les systèmes de commandement et l'aide à la décision.

- Les jeux.

- La médecine. Avec les systèmes experts diagnostique.

- La logistique. Approche de type résolution de problème de satisfaction de contraintes

- L'éducation

Jeux vidéo

L'intelligence artificielle a par exemple été utilisé depuis longtemps dans la conception de joueur artificiel pour le jeu d'échecs.

Toutefois, c'est dans les jeux vidéo que l'intelligence artificielle s'est révélée le plus et aussi là où elle présente un très grand potentiel. Celle-ci bénéficie en effet des progrès de l'informatique, avec par exemple les cartes graphiques dédiées qui déchargent le processeur principal des tâches graphiques, mais aussi grande puissance de calcul disponible. Le processeur principal peut désormais être utilisé pour développer des systèmes d’IA plus perfectionnés.

Par exemple l'intelligence artificielle peut être utilisée pour 'piloter' des bots (càd les caractères artificiels) évoluant dans les MMOGs ou les mondes virtuels, mais on peut aussi citer son utilisation dans des jeux de simulation, ou pour animer des caractères artificiels.

Dans le domaine du jeu vidéo, l’IA caractérise toute prise de décision d’un personnage (ou d’un groupe) géré par le jeu, et contraint par l’intérêt ludique : une « meilleure » IA ne donne pas forcément un jeu plus jouable[14], l’objectif est de donner l’illusion d’un comportement intelligent[14]. L'éventail de sujets (recherche de chemin, animation procédurale, planifications stratégiques…) sont réalisables par différentes techniques classiques issues de deux paradigmes distincts : IA symbolique (automates, script, systèmes multi-agents…), et IA située (réseau de neurones, algorithmes évolutionnistes…) ; où l’une est fortement dépendante de l’expertise humaine, et l’autre de l’expérience en situation[15]. La première approche est globalement préférée, car mieux contrôlée, mais la deuxième est préférée pour certains comportements (déplacement d’une formation, désirs/satisfactions)[16]. Elles partagent toutes les mêmes contraintes de ressources restreintes, que se soit en mémoire, en temps de développement, ou en temps de calcul, même si globalement ces ressources augmentent plus les projets sont récents[16].

Jusqu'à la fin des années 1990, l’IA dans les jeux vidéo (plus particulièrement dans les jeux en temps réel) a été délaissée par rapport au rendu visuel et sonore. L’« évolution vers des univers toujours plus réalistes, leur peuplement par des personnages […] aux comportements crédibles devient une problématique importante »[15]. Pour éviter ce contraste, et couplé dans le même temps au délestage d’une grosse partie de l’aspect graphique des processeurs vers les cartes graphiques[17], on constate a cette période une augmentation des ressources investies dans l’IA (temps de développement, ressource processeur)[17]. Certains jeux sont précurseurs (Creatures, Black & White) car l’IA y constitue l’élément central ludique[réf. nécessaire]. Partant d’une approche à base de règles rigides, les jeux utilisent alors des IA plus flexibles, diversifiant les techniques mise en œuvre[14]. Aujourd'hui la plupart des jeux vidéo utilisent des solutions ad hoc, il existe néanmoins des solutions middleware et également des solutions matérielles[18] toutefois très minoritaires[réf. nécessaire].

Avec les jeux en réseau, le besoin d’IA a tout d’abord été négligé[17], mais, particulièrement avec l’apparition des jeux massivement multijoueur, et la présence d’un nombre très important de joueurs humain se confrontant à des personnages non joueur, ces derniers ont un besoin très important de pouvoir s'adapter à des situations qui ne peuvent être prévues. Actuellement ces types de jeux intéressent particulièrement des chercheurs en IA, y trouvant un environnement adéquat pour y éprouver différentes architectures adaptatives[15].

L'« IA scriptée » n'est qu'une reconstitution de l'intelligence, du type : « si le joueur a telle position, alors, que 2 PNJ prennent tel chemin », sans que le logiciel sache que cela encercle le joueur.

Précurseurs

Si les progrès de l’intelligence artificielle sont récents, ce thème de réflexion est tout à fait ancien, et il apparaît régulièrement au cours de l’histoire. Les premiers signes d’intérêt pour une intelligence artificielle et les principaux précurseurs de cette discipline sont les suivants.

Automates

- voir aussi : Automate

- Une des plus anciennes traces du thème de « l’homme dans la machine » date de 800 avant notre ère, en Égypte. La statue du dieu Amon levait le bras pour désigner le nouveau pharaon parmi les prétendants qui défilaient devant lui, puis elle « prononçait » un discours de consécration. Les Égyptiens étaient probablement conscients de la présence d’un prêtre actionnant un mécanisme et déclarant les paroles sacrées derrière la statue, mais cela ne semblait pas être pour eux contradictoire avec l’incarnation de la divinité.

- Vers la même époque, Homère, dans L'Iliade (XVIII, 370–421), décrit les automates réalisés par le dieu forgeron Héphaïstos : des trépieds munis de roues en or, capables de porter des objets jusqu’à l’Olympe et de revenir seuls dans la demeure du dieu ; ou encore, deux servantes forgées en or qui l’assistent dans sa tâche. De même, le Géant de bronze Talos, gardien des rivages de la Crète, était parfois considéré comme une œuvre du dieu.

- Vitruve, architecte romain, décrit l’existence entre le IIIe et le Ier siècle avant notre ère, d’une école d’ingénieurs fondée par Ctesibius à Alexandrie, et concevant des mécanismes destinés à l’amusement tels des corbeaux qui chantaient.

- Héron l'ancien décrit dans son traité « Automates », un carrousel animé grâce à la vapeur et considéré comme anticipant les machines à vapeur.

- On a prêté à Roger Bacon la conception d'automates doués de la parole; en fait, probablement de mécanismes simulant la prononciation de certains mots simples.

- Léonard de Vinci a construit un automate en forme de lion en l’honneur de Louis XII.

- Gio Battista Aleotti et Salomon de Caus ont construit des oiseaux artificiels et chantants, des flûtistes mécaniques, des nymphes, des dragons et des satyres animés pour égayer des fêtes aristocratiques, des jardins et des grottes.

- René Descartes aurait conçu en 1649 un automate qu’il appelait « ma fille Francine ». Il conduit par ailleurs une réflexion d’un modernisme étonnant sur les différences entre la nature des automates, et celles d’une part des animaux (pas de différence) et d’autre part celle des hommes (pas d’assimilation). Ces analyses en font le précurseur méconnu d’un des principaux thèmes de la science-fiction : l'indistinction entre le vivant et l’artificiel, entre les hommes et les robots, les androïdes ou les intelligences artificielles.

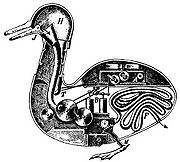

Le canard artificiel de Vaucanson (1738)

Le canard artificiel de Vaucanson (1738)

- Jacques de Vaucanson a construit en 1738 un « canard artificiel de cuivre doré, qui boit, mange, cancane, barbote et digère comme un vrai canard ». Il était possible de programmer les mouvements de cet automate, grâce à des pignons placés sur un cylindre gravé, qui contrôlaient des baguettes traversant les pattes du canard. L’automate a été exposé pendant plusieurs années en France, en Italie et en Angleterre, et la transparence de l’abdomen permettait d’observer le mécanisme interne. Le dispositif permettant de simuler la digestion et d’expulser une sorte de bouillie verte fait l’objet d’une controverse. Certains commentateurs estiment que cette bouillie verte n’était pas fabriquée à partir des aliments ingérés, mais préparée à l’avance. D’autres estiment que cet avis n’est fondé que sur des imitations du canard de Vaucanson. Malheureusement, l’incendie du Musée de Nijni Novgorod en Russie vers 1879 détruisit cet automate.

- Les artisans Pierre et Louis Jaquet-Droz fabriquèrent parmi les meilleurs automates fondés sur un système purement mécanique, avant le développement des dispositifs électromécaniques. Certains de ces automates, par un système de cames multiples, étaient capables d'écrire un petit billet (toujours le même).

- Le conte d'Hoffmann (et ballet) L'Homme au sable décrit une poupée mécanique dont s'éprend le héros.

Pensée automatique

Les processus cognitifs peuvent-ils se réduire à un simple calcul ? Et si tel est le cas, quels sont les symboles et les règles à employer ?

Les premiers essais de formalisation de la pensée sont les suivants :

- Raymond Lulle, missionnaire, philosophe, et théologien espagnol du XIIIe siècle, a fait la première tentative pour engendrer des idées par un système mécanique. Il combinait aléatoirement des concepts grâce à une sorte de règle à calcul, un zairja, sur laquelle pivotaient des disques concentriques gravés de lettres et de symboles philosophiques. Il baptisa sa méthode Grand Art (Ars Magna), fondée sur l’identification de concepts de base, puis leur combinaison mécanique soit entre eux, soit avec des idées connexes. Raymond Lulle appliqua sa méthode à la métaphysique, puis à la morale, à la médecine et à l’astrologie. Mais il n’utilisait que la logique déductive, ce qui ne permettait pas à son système d’acquérir un apprentissage, ni davantage de remettre en cause ses principes de départ : seule la logique inductive le permet.

- Gottfried Wilhelm Leibniz, au XVIIe siècle, a imaginé un calcul pensant (calculus rationator), en assignant un nombre à chaque concept. La manipulation de ces nombres aurait permis de résoudre les questions les plus difficiles, et même d’aboutir à un langage universel. Leibniz a toutefois démontré que l’une des principales difficultés de cette méthode, également rencontrée dans les travaux modernes sur l’intelligence artificielle, est l’interconnexion de tous les concepts, ce qui ne permet pas d’isoler une idée de toutes les autres pour simplifier les problèmes liés à la pensée.

- George Boole a inventé la formulation mathématique des processus fondamentaux du raisonnement, connue sous le nom d’algèbre de Boole. Il était conscient des liens de ses travaux avec les mécanismes de l’intelligence, comme le montre le titre de son principal ouvrage paru en 1854 : « Les lois de la pensée » (The laws of thought), sur l’algèbre booléenne.

- Gottlob Frege perfectionna le système de Boole en inventant le concept de prédicat, qui est une entité logique soit vraie, soit fausse (toute maison a un propriétaire), mais contenant des variables non logiques, n’ayant en soit aucun degré de vérité (maison, propriétaire). Cette invention eut une grande importance puisqu’elle permit de démontrer des théorèmes généraux, simplement en appliquant des règles typographiques à des ensembles de symboles. La réflexion en langage courant ne portait plus que sur le choix des règles à appliquer. Par ailleurs, seul l’utilisateur connaît le sens des symboles qu’il a inventés, ce qui ramène au problème de la signification en intelligence artificielle, et de la subjectivité des utilisateurs.

- Bertrand Russell et Alfred North Whitehead publièrent au début du XXe siècle un ouvrage intitulé « Principia mathematica », dans lequel ils résolvent des contradictions internes à la théorie de Gottlob Frege. Ces travaux laissaient espérer d’aboutir à une formalisation complète des mathématiques.

- Kurt Gödel démontre au contraire que les mathématiques resteront une construction ouverte, en publiant en 1931 un article intitulé « Des propositions formellement indécidables contenues dans les Principia mathematica et autres systèmes similaires ». Sa démonstration est qu’à partir d’une certaine complexité d’un système, on peut y créer plus de propositions logiques qu’on ne peut en démontrer vraies ou fausses. L’arithmétique, par exemple, ne peut trancher par ses axiomes si on doit accepter des nombres dont le carré soit -1. Ce choix reste arbitraire et n’est en rien lié aux axiomes de base. Le travail de Gödel suggère qu’on pourra créer ainsi un nombre arbitraire de nouveaux axiomes, compatibles avec les précédents, au fur et à mesure qu’on en aura besoin. Si l'arithmétique est démontrée incomplète, le calcul des prédicats (logique formelle) est au contraire démontré par Gödel comme complet.

- Alan Turing parvient aux mêmes conclusions que Kurt Gödel, en inventant des machines abstraites et universelles (rebaptisées les machines de Turing), dont les ordinateurs modernes sont considérés comme des concrétisations. Il démontre l’existence de calculs qu’aucune machine ne peut faire (un humain pas davantage, dans les cas qu'il cite), sans pour autant que cela constitue pour Turing un motif pour douter de la faisabilité de machines pensantes répondant aux critères du test de Turing.

- Irving John Good[19], Myron Tribus et E.T. Jaynes ont décrit de façon très claire les principes assez simples d’un robot à logique inductive utilisant les principes de l’inférence bayésienne pour enrichir sa base de connaissances sur la base du Théorème de Cox-Jaynes. Ils n’ont malheureusement pas traité la question de la façon dont on pourrait stocker ces connaissances sans que le mode de stockage entraîne un biais cognitif. Le projet est voisin de celui de Raymond Lulle, mais fondé cette fois-ci sur une logique inductive, et donc propre à résoudre quelques problèmes ouverts.

- Robot à logique inductive[20]

- Des chercheurs comme Alonzo Church ont posé des limites pratiques aux ambitions de la raison, en orientant la recherche (Herbert Simon, Michael Rabin, Stephen Cook) vers l’obtention des solutions en temps fini, ou avec des ressources limitées, ainsi que vers la catégorisation des problèmes selon des classes de difficulté (en rapport avec les travaux de Cantor sur l’infini).

Les questions soulevées par l'Intelligence artificielle

L’intelligence artificielle a connu un essor important pendant les années 1960 et 70, mais à la suite de résultats décevants par rapport aux budgets investis, son succès s’estompa dès le milieu des années 1980.

Par ailleurs, un certain nombre de questions se posent telles que la possibilité un jour pour les robots d'accéder à la conscience [21], ou d'éprouver des émotions.

D’après certains auteurs, les perspectives de l’intelligence artificielle pourraient avoir des inconvénients, si par exemple les machines devenaient plus intelligentes que les humains, et finissaient par les dominer, voire (pour les plus pessimistes) les exterminer, de la même façon que nous cherchons à exterminer certaines séquences d’ARN (les virus) alors que nous sommes construits à partir d'ADN, un proche dérivé de l'ARN. On reconnaît le thème du film Terminator, mais des directeurs de société techniquement très compétents, comme Bill Joy de la société Sun, affirment considérer le risque comme réel à long terme.

Toutes ces possibilités futures ont fait l’objet de quantités de romans de science-fiction, tels ceux d’Isaac Asimov ou William Gibson en passant par Arthur C. Clarke.

Espoirs et méfiances

Une description spectaculaire d’un possible avenir de l’intelligence artificielle a été faite par le professeur I. J. Good :

- « Supposons qu’existe une machine surpassant en intelligence tout ce dont est capable un homme, aussi brillant soit-il. La conception de telles machines faisant partie des activités intellectuelles, cette machine pourrait à son tour créer des machines meilleures qu’elle-même; cela aurait sans nul doute pour effet une réaction en chaîne de développement de l’intelligence, pendant que l’intelligence humaine resterait presque sur place. Il en résulte que la machine ultra intelligente sera la dernière invention que l’homme aura besoin de faire, à condition que ladite machine soit assez docile pour constamment lui obéir. »

La situation en question, correspondant à un changement qualitatif du principe même de progrès, a été nommée par quelques auteurs « La Singularité »[22].

Good estimait à un peu plus d'une chance sur deux la mise au point d'une telle machine avant la fin du XXe siècle. La prédiction, en 2009, ne s’est pas réalisée, mais avait imprégné le public : le cours de l’action d'IBM quadrupla (bien que les dividendes trimestriels versés restèrent à peu de chose près les mêmes) dans les mois qui suivirent la victoire de Deep Blue sur Garry Kasparov. Une large partie du grand public était en effet persuadée qu’IBM venait de mettre au point le vecteur d’une telle explosion de l’intelligence et que cette compagnie en tirerait profit. L’espoir fut déçu : une fois sa victoire acquise, Deep Blue, simple calculateur évaluant 200 millions de positions à la seconde, sans conscience du jeu lui-même, fut reconverti en machine classique utilisée pour l'exploration de données. Nous sommes probablement encore très loin d’une machine possédant ce que nous nommons de l'intelligence générale, et tout autant d’une machine possédant la base de connaissances de n’importe quel chercheur, si humble soit-il.

En revanche, un programme « comprenant » un langage naturel et connecté à l'Internet serait théoriquement susceptible de construire, petit à petit, une sorte de base de connaissances. Nous ignorons cependant tout aujourd'hui (2009) tant de la structure optimale à choisir pour une telle base que du temps nécessaire à en rassembler et à en agencer le contenu.

L'IA dans la culture populaire

Le thème d’une machine capable d’éprouver une conscience et des sentiments — ou en tout cas de faire comme si — constitue un grand classique de la science-fiction, notamment dans la série de romans d’Isaac Asimov sur les robots. Ce sujet a toutefois été exploité très tôt, comme dans le récit des aventures de Pinocchio, publié en 1881, où une marionnette capable d’éprouver de l’amour pour son créateur, cherche à devenir un vrai petit garçon. Cette trame a fortement inspiré le film A.I. Intelligence artificielle, réalisé par Steven Spielberg, sur la base des idées de Stanley Kubrick. L'œuvre de Dan Simmons, notamment le cycle d'Hypérion, contient également des exposés et des développements sur le sujet. Autre œuvre majeure de la science fiction sur ce thème, Destination vide, de Frank Herbert, met en scène de manière fascinante l'émergence d'une intelligence artificielle forte.

Dans la fiction

- 1927: Metropolis de Fritz Lang (1927), où, dans un monde futuriste, les robots et les humains ne parviennent plus à coexister ;

- 1968: 2001 : l'odyssée de l'espace de Stanley Kubrick, inspiré de la nouvelle Sentinelle d'Arthur C. Clarke, également auteur du scénario du film, avec la lutte entre HAL et Dave ;

- 1969: Colossus : the Forbin project 1969, d’après le roman de Dennis Feltham Jones de 1967 (un système d’IA militaire américain contacte son homologue russe pour qu’ils coopèrent à leur mission commune, éviter la guerre nucléaire... en neutralisant les humains !) a probablement fourni l’idée de départ de Terminator.

- 1973 : Mondwest et son parc d'attractions peuplé de robots.

- 1977: La Guerre des étoiles avec en particulier R2-D2 et C-3PO.

- 1981: Blade Runner de Ridley Scott (1981), inspiré du roman éponyme de Philip K. Dick, où des hommes artificiels reviennent sur terre après une mission spatiale (mais n’acceptent pas la mort programmée suite au succès de leur mission) ;

- 1982: Tron de Steven Lisberger (1982), où le Maître contrôle principal (MCP) est un programme d'échec qui a évolué en IA et tente de prendre le contrôle total du système.

- 1983: WarGames de John Badham (1983) avec Matthew Broderick, où David est un pirate informatique qui par défi parvient à contourner les systèmes de sécurité les plus sophistiqués et à maîtriser la dernière génération des jeux informatiques. Mais quand l'inconscient pénètre sans être repéré au cœur de l'ordinateur militaire du Pentagone, ministère de la défense américaine (Department of Defense ou DoD), il initie par jeu une confrontation d'ampleur mondiale (le système était prévu à la base par son créateur pour réaliser des simulations de guerre mais il ne comprend pas qu’il est maintenant réellement connecté)

- 1999: La trilogie des Matrix où les machines asservissent les humains ;

- 2001: A.I. Intelligence artificielle de Steven Spielberg, inspiré de la nouvelle de Brian Aldiss Les Supertoys durent tout l'été. Le personnage central est certainement un aboutissement ultime - mais pour l’instant seulement imaginaire - de l’intelligence artificielle : un enfant-robot doué d’émotions et de sentiments ;

- 2004: I, Robot avec Will Smith, inspiré de l’œuvre de Isaac Asimov et thème semblable au film AI ;

- 2005: Furtif de Rob Cohen en 2005. Film mettant en scène un drone (avion sans pilote) de la Navy, doté d'une intelligence artificielle. Son originalité résidant en sa capacité d'apprendre en observant les comportements humains, de les reproduire, lui permettant ainsi de communiquer. Mais dans le film, cela va le mener à sa perte puisque EDDY, le drone va se laisser submerger par ses nouvelles capacités.

- 2005: D.A.R.Y.L., Daryl est un enfant amnésique recueilli sur une route. Mais finalement, le gouvernement cherche à détruire le data analyzing robot youth lifeform ;

- voir aussi

- Liste des robots au cinéma

- Data androïde de Star Trek (Next generation), est un être cybernetique doué d'intelligence, avec des capacités importantes d'apprentissage. Il est officier supérieur sur le vaisseau Enterprise et évolue aux côtés de ses coéquipiers humains qui l'inspirent dans sa quête d'humanité. Il est la représentation type de l'androïde tel qu'il était pensé dans les années 80.

- La trilogie des Terminator avec Arnold Schwarzenegger, où Skynet cherche à éliminer l’espèce humaine

- Ghost in the Shell, où une IA s’éveille à la conscience ;

Bibliographie

- Aspects techniques

- Alan Turing, Jean-Yves Girard, La machine de Turing, 1995 [détail des éditions], Les Ordinateurs et l'Intelligence, pp. 133-174

- Claire Rémy, L'Intelligence artificielle, 1994 (ISBN 210002258X)

- Jean-Marc Alliot et Thomas Schiex, Intelligence artificielle et informatique théorique, CEPADUES, 2002 (ISBN 2854285786)

- (en) Michael R. Genesereth et Nils J. Nilsson, Logical Foundations of Artificial Intelligence, 1987 [détail des éditions]

- Stuart Jonathan Russell et Peter Norvig, Intelligence Artificielle, Pearson education, 2006 (ISBN 978-2744071508)

- Jean-Louis Laurière, Intelligence Artificielle, Eyrolles, 1986

- Jean-Paul Delahaye, Outils logiques pour l'intelligence artificielle, Eyrolles, 1987

- Aspects philosophiques

- Jacques Bolo, Philosophie contre intelligence artificielle, Lingua Franca, 1996, 375 p. (ISBN 2912059003)

- Alan Ross Anderson, Pensée et machine, Editions Champ Vallon, 1983 (réimpr. 1993), 150 p. (ISBN 2903528284)

- Jean Sallantin et Jean-Jacques Szczeciniarz, Le Concept de preuve à la lumière de l'intelligence artificielle, Presses universitaires de France, 1999, 370 p. (ISBN 2130501044)

- Fondements cognitifs, psychologiques et biologiques

- Hervé Chaudet et Liliane Pellegrin, Intelligence artificielle et psychologie cognitive, Dunod, 1998, 179 p. (ISBN 2100029894)

- Aspects linguistiques

- Gérard Sabah, L'intelligence artificielle et le langage, Représentations des connaissances, Processus de compréhension, vol. 1, Hermès, 1989 (ISBN 2-86601-134-1)

- Gérard Sabah, L'intelligence artificielle et le langage, Représentations des connaissances, Processus de compréhension, vol. 2, Hermès, 1990, 768 p. (ISBN 2-86601-187-2)

- Gérard Sabah, Compréhension des langues et interaction (Traité IC2, Série Cognition et Traitement de l'Information), Hermès science: Lavoisier, 2006 (ISBN 2-7462-1256-0)

- Vulgarisation

- Gérard Tisseau et Jacques Pitrat, Intelligence artificielle : problèmes et méthodes, Presses universitaires de France, 1996, 255 p. (ISBN 2130474292)

- Daniel Crevier et Nathalie Bukcek, À la recherche de l'intelligence artificielle, Flammarion, 1997 (ISBN 2080814281), (traduction de (en) The Tumultuous history of the search for artiticial intelligence.)

- Jack Challoner, L'Intelligence artificielle : Un guide d'initiation au futur de l'informatique et de la robotique, Pearson Education, 2003 (ISBN 2744016004)

Notes et références

- ↑ La Recherche, janv. 1979, no 96, vol. 10, p. 61, cité par le dictionnaire du CNTRL.

- ↑ (en) Russell, S. et Norvig, P., Artificial Intelligence: A Modern Approach (2nd ed.), Prentice Hall, 2003, 932 p. (ISBN 0-13-790395-2) Section 1.1

- ↑ Republié dans Collected Works of A. M. Turing, volume Mechanical Intelligence, ed. Darrel Ince, ISBN 0-444-88058-5

- ↑ Conférence Intelligent machinery, a heretical theory donnée à la Société 51 à Manchester

- ↑ « Can digital computers think? »

- ↑ « Can automatic calculating machines be said to think? »

- ↑ Crevier, Daniel (1993), AI: The Tumultuous Search for Artificial Intelligence, New York, NY: BasicBooks, ISBN 0-465-02997-3, p. 17

- ↑ Voir la Thèse CPC de Bruno Marchal, Thèse de Church-Turing

- ↑ Page de Roger Penrose

- ↑ Page d'Andrei Kirilyuk

- ↑ voir (en)Logical Foundations of Artificial Intelligence, chap. 2.2 Predicate Calculus, pp. 13-20

- ↑ François Rastier, Sémantique et recherches cognitives, PUF, 2001 (2e éd.)

- ↑ (en)Interview et Commentaires sur « Game Over: Kasparov and the Machine » (PDF)

- ↑ a , b et c (en) Game AI: The State of the Industry, Part Two, David C. Pottinger, John E. Laird, Gamasutra, 8 novembre 2000

- ↑ a , b et c MHiCS, une architecture de sélection de l'action motivationnelle et hiérarchique à systèmes de classeurs pour personnages non joueurs adaptatifs, Gabriel Robert, LIP6, 2005

- ↑ a et b (en) Game AI: The State of the Industry, Steven Woodcock, Gamasutra, 1 novembre 2000

- ↑ a , b et c (en) Game AI: The State of the Industry, Steve Woodcock, Gamasutra, 1998

- ↑ Aiseek

- ↑ Irving John Good

- ↑ (en) Robot à logique inductive (en anglais, PDF)

- ↑ L'intelligence artificielle est-elle limitée ? chat avec Gilbert Chauvet et Christophe Jacquemin qui eu lieu le 22 novembre 2006.

- ↑ Scruter la Singularité, Eliezer S. Yudkowsky, mai 2004

Voir aussi

Articles connexes

- Sujets & domaines connexes

- Agent (informatique)

- Cognition (artificielle)

- Intelligence ambiante ;

- Robotique

- Système expert ;

- Théorie des jeux ;

- Vie artificielle (et Intelligence collective artificielle)

- Principales techniques liées à l’intelligence artificielle

- Métaheuristiques (dont les Algorithmes génétiques) ;

- Programmation génétique ;

- Apprentissage automatique (Réseaux de neurones, Concepts Formels, etc.) ;

- Data mining ;

- Inférence bayésienne ;

- Planification

- Exploration

- Diagnostic

- Architecture cognitive ;

- Logique floue (fuzzy logic) ;

- Intelligence artificielle distribuée

- Programmation par contraintes ;

- Raisonnement par cas ;

- Système multi-agents ;

- Théorème de Cox-Jaynes;

- Cerveau artificiel.

- Grand noms de l’intelligence artificielle

- Irving John Good ;

- Douglas Hofstadter ;

- Douglas Lenat ;

- Marvin Lee Minsky ;

- Allen Newell;

- Nils Nilsson;

- Seymour Papert ;

- John McCarthy

- Roger Schank

- Herbert Simon

- Patrick Henry Winston

- Personnalités notables de l’intelligence artificielle dans l'espace francophone

- Alain Colmerauer (langage de programmation Prolog)

- Jean-Paul Delahaye

- Henri Farreny

- Jacques Ferber (Système multi-agents)

- Jean-Gabriel Ganascia

- Yves Kodratoff (Apprentissage automatique)

- Jean-Louis Laurière (Problème de satisfaction de contraintes)

- Jacques Pitrat (Métaconnaissance)

- Gérard Sabah

- Luc Steels

- Pour l’anecdote, citons Daniel Goossens, chercheur à l’Université Paris 8 mais aussi auteur de bandes-dessinées de premier plan.

Liens et documents externes

Français

- (fr) Références de sites : série de liens groupés par thème et commentés ;

- (fr) Association Française d'Intelligence Artificielle ;

- (fr) À quoi rêvent les robots, bande dessinée de vulgarisation de Jean-Pierre Petit (en PDF) ;

- (fr) Automates Intelligents (revue). Une lettre et un site électronique faisant une part importante à l'intelligence artificielle et en particulier les aspects prospectifs site web.

Anglais

- (en) « How to get there from here? » Un article sur la faisabilité de l'IA ;

- (en) I. J. Good. « I.J. Good : Speculations Concerning the First Ultraintelligent Machine », « Hypothèses concernant les premières machines ultra-intelligentes » (voir aussi Inférence bayésienne) ;

- (en) Artificial Intelligence Directory : répertoire de sites Web sur l'intelligence artificielle ;

- (en) Courtney Boyd Myers ed. (2009). The AI Report. Forbes, Juin 2009

- Portail de l’informatique

- Portail de la science-fiction

Catégories : Intelligence artificielle | Concept de la science-fiction | Transhumanisme | Lexique et notions du jeu vidéo | Systémique

Wikimedia Foundation. 2010.