- Hitachi Content Platform

-

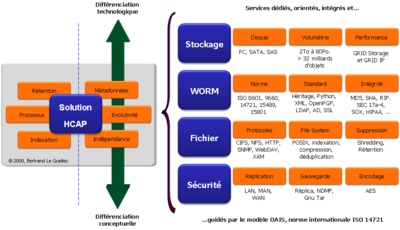

Hitachi Content Platform, aussi désigné par l'acronyme HCP (anciennement nommé HCAP pour Hitachi Content Archive Platform) est une solution logicielle et matérielle dédiée à l'archivage électronique à valeur probante de la société Hitachi Data Systems en réponse à la problématique de stockage WORM sur disque.

La solution est constituée d’un environnement logiciel (WORM) et matériel (RAID-6) répondant aux exigences de conservation sur le long terme des données numériques, mais aussi de sécurité et d’intégrité de ces mêmes données (standard POSIX - Norme ISO 9660). Les accès en lecture (consultation) et écriture (versement/dépôt) se réalisent à travers un réseau IP LAN pour les protocoles NFS, CIFS et un réseau LAN ou WAN pour le protocole HTTP(S).

Cette solution d’archivage, à haute performance, disponibilité et extensibilité, satisfait aux exigences de conformité réglementaire en assurant la préservation sécuritaire à long terme ainsi, que la recherche et la récupération de précieuses informations.

Système d'Archivage Électronique

Le modèle de référence OAIS (Open Archival Information Systems) fonde la base de la conception de la plate-forme HCP. Le moteur logiciel interne délivre des services d’archivage définis au niveau Serveur de Stockage dans le modèle de référence OAIS. Le service consultation est assurée par les protocoles NFS, CIFS et HTTP, mais aussi à travers le moteur d'indexation intégré qui indexe le contenu des documents et des métadonnées. Le moteur de recherche propose une interface HTTP. Il est accessible au travers de requêtes XML et propose la génération de liens RSS. Ce moteur intégré est celui de la société FAST Instream qui a été rachetée en 2008 par la société Microsoft.

La représentation schématique du modèle OAIS est structurée au travers de règles générales de gestion des objets correspondant à un plan de conservation, mais aussi des règles d’ingestion et de consultation, proposant de garantir une indépendance aux applications, une conservation dans une infrastructure de stockage et une optimisation des recherches et d’indexation.

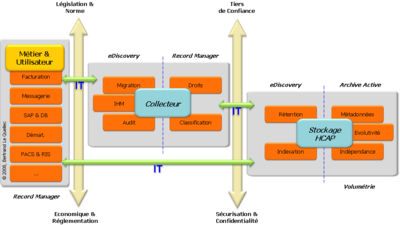

Intégration dans le Système d'information

Dans la chaine de traitement d'une archive, la solution HCP se positionne au niveau stockage. Du fait de sa conception, HCP ne peut être associé directement à la fonction d'un Collecteur. Le Collecteur est le programme de récupération ou de capture des données à partir de l'application métier ou des environnements informatiques. Sa fonction minimale peut être comparée à de la migration, c'est-à-dire un déplacement de données à partir de règles de poids, de valeurs ou tout simplement de dates. Mais cette capacité de collecte est plus ou moins riche en fonction du type d'application et du niveau fonctionnel du Collecteur. Ainsi, le Collecteur peut être classifié depuis la catégorie HSM (Hierarchical Storage Management) à la catégorie Record Management, ou plus largement, la catégorie GED (Gestion Électronique des Documents).

Dans une architecture informatique, le Collecteur est parfois inutile si l'application cible et l'utilisateur sont en charge de cette fonction. Un premier exemple : le module ILM (Information Lifecycle Managment) de SAP se charge, au travers du protocole WebDAV, de transférer ces objets actifs vers le stockage HCP ou compatible, sans nécessiter de passerelle spécifique autre que le protocole. Un second exemple : une solution de messagerie (MS Exchange, Notes, etc.) peut journaliser tous les messages entrant et sortant vers la solution HCP, au travers du protocole SMTP (Simple Mail Transfer Protocol). Ces deux exemples illustrent la non nécessité, au niveau informatique, d'un Collecteur spécifique.

Dans la majeure partie des infrastructures, le Collecteur est bien présent. En effet, son rôle ne doit pas être négligé. Il apporte de réelles réponses en termes de classification et de validation de l'information, mais aussi pour la gestion et la délégation des droits d'accès. La solution HCP propose un certain nombre de services orientés Archivage, mais son positionnement reste axé sur la prise en charge et la gestion du stockage WORM.

Ce positionnement se décline dans HCP par une forte valeur ajoutée sur la prise en charge des archives, de la gestion des rétentions et des métadonnées. Il s'agit d'une déclinaison de services orienté sur le dépôt et la consultation des archives au travers de standards indépendants du constructeur de la solution. Cette orientation de la solution HCP s'accompagne d'une différenciation conceptuelle, qui dès la première version a pour objectif de respecter certaines règles inhérentes à un projet d'archivage :

- l'indépendance octroyée à l'entreprise, l'utilisateur et l'application métier.

- la capacité d'évolution d'un point de vue technologie de stockage, mais aussi de volumétrie et de nombre d'archives

- la prise en compte des métadonnées métier mais aussi système, c'est-à-dire les politiques de conservation, de protection et de sécurité.

Architecture interne

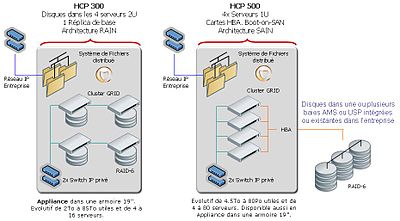

HCP se structure physiquement autour d’un réseau IP privé d’échanges, géré par un Switch IP dédié, et de cellules ou nœuds. De base, HCP est bâti par une unité de stockage disque et deux nœuds (2x2 serveurs en Cluster). Le stockage est soit intégré aux serveurs (architecture RAIN - Redundant Array of Independent Nodes), soit disponible via une ou plusieurs baies de stockage (architecture SAIN - SAN plus Array of Independent Nodes).

Dans le cas d'une architecture SAIN, la liaison entre les serveurs et le stockage est de type SAN FC. Des Switchs FC dédiés complètent l’ensemble en fonction du nombre de serveurs reliés et du niveau de disponibilité requis. Une option de haute disponibilité nommée DAP (Data Access Protection) permet d’augmenter l’accessibilité aux données, par l’installation de deux cartes HBA sur chaque serveur. Ainsi en cas de rupture d’un serveur ou d’une zone de stockage, l’accès matériel est toujours garanti.

En aperçu général, l’environnement logiciel HCP est composé des services et des fonctionnalités suivantes :

- Plus de 32 milliards d’objets :

- Objet HCP : fichier (archive source), métadonnées (système et métier) et politique (rétention, répliqua, date, droits, etc.).

- Fichier XML définissant des métadonnées aux niveaux :

- Système - Core : signature, répliqua, droit, rétention (nulle, infinie, date fixe), etc.

- Métier - Custom : description spécifique au fichier mis en dépôt et compléter par l’utilisateur ou l’application propriétaire (information complémentaire, horodatage, signature externe, etc.).

- Gestion de répliquas : capacité de gérer automatiquement jusqu’à 4 copies de l’original mis en dépôt.

- Accès multi protocoles natifs : CIFS, NFS, HTTPs, cURL, WebDAV, SMTP, SNMP, SSL, …

- Indexation de contenu – FAST :

- Plus de 370 formats reconnus sur 77 langues.

- Capacité de requêtes XML.

- Autres fonctionnalités embarquées :

Déclinaison produit

La solution HCP est proposée en deux déclinaisons principales :

- Une déclinaison dite Appliance, c’est-à-dire une solution complète embarquant le logiciel, les serveurs de traitement et le stockage interne aux serveurs ou sur une baie AMS haute disponibilité. Le tout pré configuré et câblé en usine. L’administrateur ne gère pas les volumes disques et ne réalise aucune administration et configuration du stockage, qui est intégré au fonctionnel de l’Appliance.

- Une seconde dite Disk Less (DL), identique à la version Appliance, mais livrée sans disque. L’entreprise utilise son stockage AMS, USP et/ou VSP Hitachi déjà existant. Il s’agit alors uniquement, d’une intégration de serveurs de traitement et de la solution logicielle. Une déclinaison DL permet un partage de la baie de stockage avec d'autres environnements connectés au réseau SAN FC.

HCP est une solution résolument ouverte par son concept d’architecture, mais aussi par son mode d’accès en lecture et écriture. Ainsi, un certain nombre de protocoles standards sont disponibles sans option et sans concurrence d’accès. C’est-à-dire que l’entreprise accède à HCP par le ou les protocoles HTTP(s), NFS et CIFS en fonction des besoins de l’architecture métier.FAQ - Questions et Réponses Fréquentes

Description du processus d'écriture et de contrôle des données

Tout d'abord l'écriture des données est réalisée via le réseau IP de l'entreprise par l’un des protocoles activés (CIFS, NFS, HTTPs, …). Dès réception complète de la donnée, sa prise en compte par HCP débute par le calcul d’une empreinte avec un des algorithmes du HCP MD5, SHA, etc. L'empreinte est enregistrée dans un premier fichier dédié nommé core-metadata.xml et dans un second fichier nommé hash.txt. Les deux fichiers, non modifiables, sont présents dans l'arborescence Metadata et accessibles, depuis le réseau IP, via l’un des protocoles activés (CIFS, NFS, HTTPs, …). Une fois déposé le nom du fichier et son contenu ne peuvent être changés, même si la date de rétention est nulle ou arrivée au terme de sa conservation. Tout au long de la conservation du fichier, un processus spécifique (nommé Scavenging) interne à la plate-forme HCP effectue des vérifications sur son intégrité. Une vérification est aussi réalisée lors d'un accès en lecture au fichier.

Par exemple, pour la partie accès CIFS, HCP utilise des codes retours associés à ce protocole, comme le NT_STATUS_ACCESS_DENIED. Ce code retour est renvoyé pour refuser les opérations suivantes : renommer un objet ; renommer ou détruire un répertoire qui contient au moins un objet ; écraser un objet ; modifier le contenu d'un objet ; détruire un objet sous rétention ; ajouter un fichier dans la partie métadonnées à l'exception du fichier custom-metadata.xml ; détruire un fichier ou un répertoire Métadonnée et créer un lien. Ces interdictions sont une liste des actions qui permettent de garantir qu’il n’y a aucune possibilité de substitution des données.

REPLICA/REPLIQUA - Duplication interne des données

Avec l’utilisation du mode Réplica (Data Protection Level), chaque fichier (archive) déposé est systématiquement dupliqué en interne vers une zone de stockage différente et gérée par un autre serveur. Ainsi le dépôt source et sa copie sont situés sur des Groupes RAID-6 physiques différents, dont l'accès est géré par des serveurs (contrôleurs) différents. En cas d'altération du fichier, HCP reconstruit automatiquement le fichier, et les métadonnées, à partir de sa copie et ajoute une information dans les Logs (début, arrêt avant la fin, violation, fin et succès du traitement).

La partie Métadonnée est aussi prise en charge par les politiques de duplication, mais par défaut est sans aucune politique de DPL, les métadonnées sont toujours doublées.

Détection et non substitution de données

Dès son enregistrement la donnée ne peut être modifiée et ne peut être substituée, même par le propriétaire. Toute opération d'ouverture du fichier en mode écriture est strictement interdite, même si le fichier est au delà de sa période de rétention. Le système de fichiers POSIX de stockage des fichiers est contrôlé directement par HCP. Aucun mécanisme ne permet d'interférer dans la modification ou le remplacement d'un fichier pendant la période de rétention. Après la période de rétention et en fonction des autorisations d'accès, la seule opération autorisée est la suppression définitive du fichier.

En cas de suppression après la rétention, puis copie d'un nouveau fichier dans un objectif de substitution, il sera possible de détecter l'opération, car HCP enregistre la date de dépôt, donc la date du fichier de substitution éventuelle. Cette date de dépôt est enregistrée dans un premier fichier nommée core-metadata.xml et dans un second fichier nommé created.txt. Les deux fichiers sont non modifiables, présents dans l'arborescence Metadata et accessibles, depuis le réseau IP, via l’un des protocoles activés (CIFS, NFS, HTTPs, …). En cas de fichier dit non réparable, c'est-à-dire que le fichier source est détecté comme altéré et que sa restauration par sa copie interne (Replica) échoue, une notification d'alerte est enregistrée (SNMP et Syslog). L'interface graphique d'administration propose aussi une vue spécifique sur ces fichiers corrompus.

Tenue d'un journal d'évènements

Le journal des évènements du système HCP (System Log Events) comprend des informations liées à l'activité de la plate-forme : arrêt, démarrage, suppression de compte, sauvegarde, mot de passe invalide, service spécifique stoppé, lien réseau, serveur de temps inaccessible, etc.

L'accès à ces Logs s'effectue principalement via 3 modes : l'interface d'administration avec les droits Monitor; le protocole SNMP et le protocole Syslog. Syslog est le protocole le plus couramment utilisé. Il s'agit d'un service de journaux d'événements d'un système informatique, mais donne aussi son nom au format d'échange. Ce protocole se compose d'une partie Client et d'une partie Serveur. HCP se comporte comme un client en émettant les informations sur le réseau via le port UDP 514. La partie serveur doit collecter les informations, pour centraliser les journaux d'événements.

Un événement HCP est composé d'un identifiant unique, le numéro de segment du message (un événement Syslog ne peut excéder 1024 caractères, celui-ci peut donc être découpé en plusieurs segments), l'identifiant de l'événement, la date, la sévérité, l'identification du serveur HCP, le volume (stockage) concerné, le nom de l'utilisateur éventuel lié à l'événement, une courte description de l'événement (uniquement pour SNMP ) et le message complet.

En plus des événements systèmes envoyés par les protocoles SNMP et Syslog, HCP maintiens des Logs internes. Il s'agit d'enregistrements sur l'activité des composants HCP. Ces Logs internes sont uniquement utiles à diagnostiquer un problème interne par le support Hitachi. Ces Logs internes sont conservés sur une période de 35 jours. Lors d'une récupération par un téléchargement depuis l'interface d'administration, le fichier récupéré est encrypté et ne peut être lu que par le support Hitachi.

Destruction effective des données

La destruction d'un fichier ne peut être réalisée qu'au terme de la rétention. L'ordre de suppression n'est pas réalisé par HCP, mais doit être donnée par l'application Métier (ou Collecteur). Elle se réalise via l’un des protocoles activés (CIFS, NFS, HTTPs, …), comme pour un fichier standard. L'ordre de suppression provoque dans la solution Hitachi Content Platform la suppression du fichier cible, de sa copie interne (Réplica : Data Protection Level) et des métadonnées associées. Cette suppression est accompagnée d'une opération dite de Shredding (suppression sécurisée). C'est-à-dire la mise en œuvre d'une opération de suppression effective des données sur le disque et non uniquement d'une suppression des descripteurs (inodes ou pointeurs). Ce mécanisme normé assure que le contenu du fichier ne pourra être lu même par une lecture physique du disque dur.

Le traitement d'une opération de Shredding peut faire l'objet d'un enregistrement d'évènement pour être collecté via le protocole Syslog.

Capacité de développement logiciel et d'intégration applicative

Le support natif du protocole HTTP embarque aussi l’intégration des accès par WebDAV, REST ou cURL. Ainsi, en plus des protocoles CIFS et NFS pour un accès direct en mode système de fichiers, il est très aisé d’utiliser les modes d’accès Web pour dialoguer avec la solution HCP, afin d’assurer l’écriture (Upload) et la lecture (Download) de tout type de document.

En exemple et pour illustrer la simplification et la facilité de développement sur HCP, la librairie cURL est disponible dans le domaine public en ligne de commande sur un très grand nombre de systèmes d’exploitation, mais aussi via client REST et le langage PHP.

Via HTTP, le mode Web est privilégié, car il autorise des accès non dépendant d’un réseau local et permet des niveaux de performance en accord avec l’architecture Cloud réparti du HCP, par le traitement parallèle des flux entrants et sortants, car tous les serveurs HCP sont disponibles et travaillent ensemble à la répartition des charges et du stockage des documents. Plus le nombre de serveurs HCP est important plus le nombre de traitement parallèle est possible, tout en accédant à un seul espace de stockage consolidé.

SNMP et Syslog contribuent aussi à une intégration avancée et au développement d’application au-dessus de la solution HCP. Le premier au niveau administration de la plate-forme. Le second à la collecte des journaux d’activité et la traçabilité.

Archivage de messagerie électronique

L’archivage des courriels peut-être réalisé à travers des outils de délestage de messagerie qui collectent les courriels et les pièces jointes et effectuent un enregistrement sur le stockage HCP.

Dans le cadre d’un archivage avec une orientation dite Compliant ou Valeur Probante, c’est-à-dire de conservation probante sur un support adapté (WORM logique), il est permis d’envoyer directement les courriels via le protocole SMTP qui est nativement supporté par HCP. Ainsi, un administrateur de messagerie peut définir des règles de transfert vers HCP directement à partir de son application de messagerie. Par exemple, Microsoft Exchange 2010 propose tout un service applicatif, au travers de la journalisation des courriels et leurs pièces jointes sont envoyés sur HCP, pour y être stockés dans une arborescence fichiers et être classifiés automatiquement par date. Le moteur d’indexation HCP peut être utilisé, afin de retrouver les courriels par propriétaire, destinataire ou contenu, même au sein des documents en attachement.

Conservation de Journaux d'Évènements

Le marché du traitement sécurisé des Journaux d’Évènements (Syslog, SNMP, etc.)est une cible pour la solution Hitachi Content Platform. Les journaux d’évènements sont une source de détection et d’analyse d’incidents, de traçabilité et surtout de sécurité, pour comprendre et interpréter une activité afin d’apporter les corrections préventives sur les causes identifiées. Il est nécessaire de conserver ces informations et d'en assurer l'intégrité. Au travers du protocole SMTP disponible de base dans la solution HCP, il est aisé d'envoyer des messages électroniques avec des documents attachés issus de traces (Logs) d'activités de divers systèmes applicatifs et équipements informatiques. L'utilisation du moteur d'indexation interne et des interfaces de recherche de la solution HCP facilite les exigences sur les audits, les métriques et la réalisation de tableaux de bord.

Chaque entreprise est confrontée à la gestion de ce type d’information et, pour une part, à leur conservation réglementée. En dehors du service informatique de base qui consiste à suivre et interpréter la corrélation d’incidents, une bonne gestion et conservation des Évènements permet aussi de répondre à des contraintes de sécurité et de responsabilité avec plus ou moins d’inhérence suivant les secteurs.

Ce marché sera d’autant plus important que la réglementation évolue avec la notion de traçabilité des activités, telle que la conformité à la norme ISO 27001 qui prend de l’ampleur et qui intéresse fortement les RSSI. L’objet de cette norme est de définir les mesures nécessaires à la sécurité des biens sensibles de l’entreprise liés à son système d’information. HCP n’est pas directement « certifié » ISO 27001, mais est un outil informatique s’intégrant et facilitant la mise en œuvre d’une stratégie liée à cette norme pour le Système de Management de la Sécurité de l'Information (SMSI).

Voir aussi

Références Clients

- (en)(fr) Swiss Picture Bank, application Web de conservation de photos - Site Web, 100Mo gratuit

- (en) Amsterdam City Archive, 35 kilometers of archive - Vidéo

- (en) ABN AMRO Hypotheken Group - PDF

Liens internes

- Archivage électronique

- Gestion des documents d'archive

- Hitachi

- Hitachi Global Storage Technologies

- Hitachi NAS

- Hitachi Data Protection Suite

- Hitachi Adaptable Modular Storage

- Open Archival Information System

- Hitachi Universal Storage Platform

- Hitachi Virtual Storage Platform

Liens externes

- (fr) Vidéo de l'interface de gestion interne

- (en) Site officiel de la maison mère Hitachi

- (fr) Site officiel de Hitachi Data Systems France

- (fr) Site Web TV officiel de Hitachi Data Systems France

- (en) Site officiel Hitachi Global Storage Technologies - disque dur

- Portail des entreprises

- Portail de l’électricité et de l’électronique

- Portail du Japon

Wikimedia Foundation. 2010.