- Hitachi Content Archive Platform

-

Hitachi Content Archive Platform

Hitachi Content Archive Platform est aussi désigné aussi par l'acronyme HCAP. Il s'agit d'une solution logicielle et matérielle dédiée à l'archivage électronique à valeur probante de la société Hitachi Data Systems en réponse à la problématique de stockage WORM sur disque.

La solution est constituée d’un environnement logiciel (WORM) et matériel (RAID-6) répondant aux exigences de conservation sur le long terme des données numériques, mais aussi de sécurité et d’intégrité de ces mêmes données (standard POSIX (Norme ISO 9660)). Les accès en lecture (consultation) et écriture (versement/dépôt) se réalisent à travers un réseau IP LAN pour les protocoles NFS, CIFS et un réseau LAN ou WAN pour le protocole HTTP(S).

Cette solution d’archivage, à haute performance, disponibilité et extensibilité, satisfait aux exigences de conformité réglementaire en assurant la préservation sécuritaire à long terme ainsi, que la recherche et la récupération de précieuses informations.

Le modèle de référence OAIS (Open Archival Information Systems) fonde la base de la conception de la plate-forme HCAP. Le moteur logiciel HCA (Hitachi Content Archiver) a été développé pour prendre en charge les services d’archivage définis au niveau Serveur de Stockage dans le modèle de référence OAIS. Le service consultation est assurée par les protocoles NFS, CIFS et HTTP, mais aussi à travers le moteur d'indexation intégré qui indexe le contenu des documents et des méta données. Le moteur de recherche propose une interface HTTP. Il est accessible au travers de requêtes XML et propose la génération de liens RSS. Ce moteur intégré est celui de la société FAST Instream qui a été rachetée en 2008 par la société Microsoft.

La représentation schématique du modèle OAIS est structurée au travers de règles générales de gestion des objets correspondant à un plan de conservation, mais aussi des règles d’ingestion et de consultation, proposant de garantir une non dépendance aux applications, une conservation dans une infrastructure de stockage et une optimisation des recherches et d’indexation.

La solution HCAP est proposée en trois déclinaisons :

- Une déclinaison dite HCAP Appliance, c’est-à-dire une solution complète embarquant le logiciel, les serveurs de traitement et le stockage interne au serveurs ou sur une baie haute disponibilité. Le tout pré configuré et câblé en usine. L’administrateur ne gère pas les volumes disques et ne réalise aucune administration et configuration du stockage, qui est intégré au fonctionnel de l’Appliance.

- Une seconde dite HCAP Disk Less (HCAP-DL), identique à la version Appliance, mais livrée sans disque. L’entreprise utilise son stockage Hitachi déjà existant. Il s’agit alors uniquement, d’une intégration de serveurs de traitement et de la solution logicielle.

- Une troisième nommée Hitachi Content Archiver (HCA), comporte uniquement le fonctionnel logiciel. L’entreprise fourni alors les serveurs de traitement (type x86) et le stockage.

HCAP est une solution résolument ouverte par son concept d’architecture, mais aussi par son mode d’accès en lecture et écriture. Ainsi, un certain nombre de protocoles standards sont disponibles sans option et sans concurrence d’accès. C’est-à-dire que l’entreprise accède à HCAP par le ou les protocoles HTTP(s), NFS et CIFS en fonction des besoins de l’architecture métier.

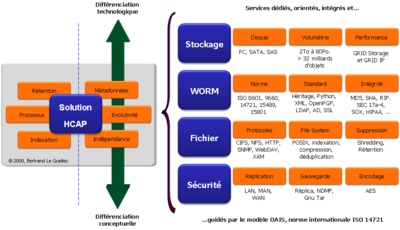

En aperçu général, l’environnement logiciel HCAP est composé des services et des fonctionnalités suivantes :

- Plus de 32 milliards d’objets :

- Objet HCAP : fichier (archive source), méta données (système et métier) et politique (rétention, réplica, date, droits, etc.).

- Fichier XML définissant des métadonnées aux niveaux :

- Système - Core : signature, réplica, droit, rétention (nulle, infinie, date fixe), etc.

- Métier - Custom : description spécifique au fichier mis en dépôt et compléter par l’utilisateur ou l’application propriétaire (information complémentaire, horodatage, signature externe, etc.).

- Gestion de Réplicas : capacité de gérer automatiquement jusqu’à 4 copies de l’original mis en dépôt.

- Accès multi protocoles natifs : CIFS, NFS, HTTPs, cURL, WebDAV, SMTP, SNMP, SSL, …

- Indexation de contenu – FAST InStream :

- Plus de 370 formats reconnus sur 77 langues.

- Capacité de requêtes XML.

- Autres fonctionnalités embarquées :

- Signature (MD-5, SHA-1, SHA-256, SHA-512 et RIPEMD-160) Encodage, Shredding, Réplication, Déduplication, Compression, sauvegarde NDMP, etc.

- Administration, supervision et métriques : GUI Web, MIB SNMP, mode CLI, Logs, etc.

HCAP se structure physiquement autour d’un réseau IP privé d’échanges, géré par un Switch IP dédié , et de cellules ou nœuds. De base, HCAP est bâti par une unité de stockage disque et 2 nœuds (2x2 serveurs en Cluster). Le stockage est soit intégré aux serveurs (architecture RAIN - Redundant Array of Independent Nodes), soit disponible via une ou plusieurs baies de stockage (architecture SAIN - SAN plus Array of Independent Nodes). dans le cas SAIN, la liaison entre les serveurs et le stockage est de type SAN FC . Un Switch FC dédié complète l’ensemble en fonction du nombre de serveurs reliés et du niveau de disponibilité requis. Une option de haute disponibilité nommée DAP (Data Access Protection) permet d’augmenter l’accessibilité aux données, par l’installation de deux cartes HBA sur chaque serveur. Ainsi en cas de rupture d’un serveur ou d’une zone de stockage, l’accès matériel est toujours garanti.

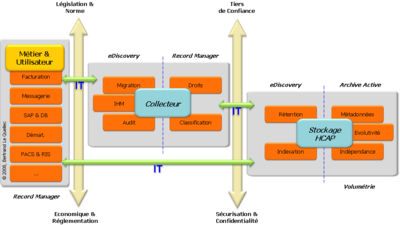

Dans la chaine de traitement d'une archive, la solution HCAP se positionne au niveau stockage. Du fait de sa conception, HCAP ne peut être associé directement à la fonction d'un Collecteur. Le Collecteur est le programme de récupération ou de capture des données à partir de l'application métier ou des environnements informatique. Sa fonction minimale peut être comparée à de la migration, c'est-à-dire un déplacement de données à partir de règles de poids, de valeurs ou tout simplement de dates. Mais cette capacité de collecte est plus ou moins riche en fonction du type d'application et du niveau fonctionnel du Collecteur. Ainsi, le Collecteur peut être classifié depuis la catégorie HSM (Hierarchical Storage Management) à la catégorie Record Management, ou plus largement, la catégorie GED (Gestion Électronique des Documents).

Dans une architecture informatique, le Collecteur est parfois inutile si l'application cible et l'utilisateur sont en charge de cette fonction. Un premier exemple : le module ILM (Information Lifecycle Managment) de SAP se charge, au travers du protocole WebDAV 2.0, de transférer ces objets actifs vers le stockage HCAP ou compatible, sans nécessiter de passerelle spécifique autre que le protocole. Un second exemple : une solution de messagerie (MS Exchange, Notes, etc.) peut journaliser tous les messages entrant et sortant vers la solution HCAP, au travers du protocole SMTP (Simple Mail Transfer Protocol). Ces deux exemples illustrent la non nécessité, au niveau informatique, d'un Collecteur spécifique.

Dans la majeure partie des infrastructures, le Collecteur est bien présent. En effet, son rôle ne doit pas être négligé. Il apporte de réelles réponses en termes de classification et de validation de l'information, mais aussi pour la gestion et la délégation des droits d'accès. La solution HCAP propose un certain nombre de services orientés Archivage, mais son positionnement reste axé sur la prise en charge et la gestion du stockage WORM.

Ce positionnement se décline dans HCAP par une forte valeur ajoutée sur la prise en charge des archives, de la gestion des rétentions et des méta données. Il s'agit d'une déclinaison de services orienté sur le dépôt et la consultation des archives au travers de standards indépendants du constructeur de la solution. Cette orientation de la solution HCAP s'accompagne d'une différenciation conceptuelle, qui dés la première version a pour objectif de respecter certaines règles inhérentes à un projet d'archivage :

- l'indépendance octroyée à l'entreprise, l'utilisateur et l'application métier.

- la capacité d'évolution d'un point de vue technologie de stockage, mais aussi de volumétrie et de nombre d'archives

- la prise en compte des méta données métier mais aussi système, c'est-à-dire les politiques de conservation, de protection et de sécurité.

- Portail de l’informatique

Catégorie : Métadonnées

Wikimedia Foundation. 2010.