- Figure de la Terre et histoire du mètre

-

Certains travaux préalables à la définition et la détermination du mètre et du système métrique sont exposés dans l'article Figure de la Terre et méridienne de Delambre et Méchain.

L'aplatissement de la Terre selon Delambre

Pour calculer le mètre, exprimé en lignes de la toise de l'Académie, en fonction de l'aplatissement géométrique f, Jean-Baptiste Delambre utilisa l'équation suivante :

1 mètre = 443,39271 – 27,70019 f + 378,694 f² lignes (la ligne étant une ancienne unité)

Les valeurs de degrés successifs de la méridienne fournissaient des aplatissements assez incohérents[1]. Ainsi, à titre d'exemple, Legendre trouva f = 1/148. Cette valeur confirmait le résultat de Maupertuis, mais était en désaccord complet avec le résultat obtenu par Clairaut. Finalement, à contre-cœur, Delambre dut se résigner à recourir à l'arc mesuré au Pérou dont il s'était toujours méfié et qui d'ailleurs, sur un plan plus général, ne correspondait pas au critère que le mètre ne devait pas faire intervenir des mesures attachées à un pays en particulier[2].

Delambre choisit l'arc de Bouguer, qu'il réduisit au niveau de la mer en recalculant lui-même toutes les observations astronomiques. Il trouva ainsi des aplatissements dispersés autour d'une valeur de l'ordre de 1/315. Il préconisa la valeur 1/308,64, qui fournit par la formule précédente 443,307 lignes. En 1810 Delambre la porta à 443,328 lignes. Il s'ensuit pour le quart de méridien une valeur de 10 000 724 mètres, au lieu des 10 000 000 de mètres requis par la définition primitive sur laquelle le mètre est basé. Par contre, la commission établie pour définir le mètre retint en 1799 un aplatissement de 1/334, bien trop faible mais qui donne effectivement un mètre égal à 10–7 Q valant 443.296 lignes de la toise de l'Académie[3].

D'autre part, entre 1792 et 1798, Borda et Cassini IV faisaient à l'Observatoire de Paris des expériences pendulaires. Leur pendule, bien que beaucoup plus perfectionné que ceux de Picard et de Dourtous de Mairan, reposait toujours sur le principe du pendule simple. Sur vingt séries de mesures effectuées avec un très grand soin, ils obtinrent pour le pendule simple battant la seconde à l'Observatoire de Paris une longueur de 440,5593 lignes, ce qui entraîne pour la pesanteur à cet endroit une valeur g = 9,80868 m/s². Cette valeur diffère assez sensiblement des valeurs qu'on trouve actuellement, mais il est difficile d'identifier avec précision l'emplacement des expériences.

Le « mètre théorique » de 1791 et sa valeur selon WGS84

Avec la loi du 26 mars 1791, on rejeta la proposition de la commission Talleyrand de 1790 d'une mesure de longueur décimale basée sur la pendule battant la seconde. Le mètre fut officiellement défini pour la première fois en 1791 par l'Académie des sciences comme étant la dix-millionième partie d'un quart de méridien terrestre. Pour connaître exactement cette distance, la loi du 26 mars 1791 envoie des arpenteurs pour mesurer le méridien entre Dunkerque et Barcelone. Aujourd'hui nous savons que le quart d'un grand-cercle longitudinal mesure – selon WGS84 – 10 001,966 km. Il s'en suit qu'un mètre devrait mesurer 1 000,1966 mm[4]. Autrement dit, il aurait dû être défini correctement en mesurant 443,296 × 1,0001966 égale 443,383 152 lignes du roi.

Le « mètre provisoire » du 1er août 1793

Le roi étant mort depuis le 21 janvier 1793, la bourgeoisie révolutionnaire, rentrée depuis juin 1793 dans le Règne de la Terreur, ne voulait guère attendre la fin des travaux de Delambre et Méchain et continuer ainsi d'utiliser le « Pied du Roy ». Pour cette raison la Convention nationale vota le 1er août 1793 l'introduction immédiate des nouvelles mesures décimales. Il fut institué un « mètre provisoire » sur base des mesures antérieures de Lacaille d'une valeur de 3 pieds 11,44 lignes (soit 443,44 lignes), par rapport à la toise du Pérou[5]. Ceci équivaut presque 1000,325 millimètres. En 1795 un étalon en laiton fut fabriqué en attendant la valeur du mètre définitif.

Le « mètre définitif » du 19. Frimaire An VIII

Au milieu de l'année 1799, les résultats nécessaires à la réalisation pratique et définitive du mètre étaient disponibles. Delambre proposa de s'en tenir à l'équivalence de 443,3 lignes pour 1 mètre, une toise faisant 6 fois 144 lignes, mais la commission chargée de la question décida d'utiliser pleinement toute la précision du comparateur de l'ingénieur Étienne Lenoir (1744–1832). Elle fixa, comme déjà signalé ci-dessus, la longueur du mètre définitif à 3 pieds 11,296 lignes (soit 443,296 lignes). La loi du 18 Germinal, an III (7 avril 1795) avait stipulé que le mètre devrait être tracé sur une règle en platine. Lenoir construisit donc le prototype du mètre-étalon selon ces critères.

La loi du 19 Frimaire, an VIII (10 décembre 1799) précisa : « le mètre et le kilogramme en platine déposés le 4 Messidor dernier au Corps législatif par l'Institut national des Sciences et des Arts sont les étalons définitifs des mesures de longueur et de poids dans toute la République… ». Ce mètre-étalon, connu aujourd'hui sous le nom de Mètre des Archives, est un étalon à bouts consistant en une règle plate d'une section d'environ 25x4 mm², dont la longueur est définie par la distance entre ses faces terminales. Elle est plus courte que le mètre provisoire de 0,144 ligne (soit environ 0,325 mm). À l'époque, cela ne tirait guère à conséquence mais, compte tenu de la précision atteinte actuellement dans les mesures géodésiques, un tel écart serait dramatique.

On peut se demander s'il s'agissait d'une définition nouvelle du mètre, sachant que l'intention du législateur n'était certainement pas d'abolir la définition de 1791. L'étalon du mètre de 1799 ne faisait que représenter le méridien, tout comme l'étalon du kilogramme ne faisait que représenter un décimètre cube d'eau. En principe, on pouvait toujours recourir à la définition première mais, vu l'énorme travail que cela aurait impliqué, cela ne pouvait être qu'un pis-aller en cas de destruction de l'étalon. En réalité, toutes les mesures métriques de longueur furent dérivées du Mètre des Archives. Une douzaine de copies en fer avaient été construites et distribuées aux États dont les représentants avaient participé au contrôle final des opérations de Delambre et Méchain. D'autres furent construites par la suite, mais jamais on n'eut recours à la mesure d'un arc de méridien pour vérifier un étalon de longueur. Par conséquent, c'est la définition de 1799 qui fut en vigueur jusqu'en 1889.

Le mètre-étalon de 1889

On sait que le Mètre des Archives est trop court d'environ un cinquième de millimètre par rapport à sa définition de 1791 – c'est-à-dire par rapport à la vrai distance pôle-équateur – mais ce n'est pas ce fait qui déclencha, vers 1860, le mouvement qui devait conduire à une nouvelle définition du mètre. C'est plutôt la qualité métrologique de l'étalon des Archives qui se révélait peu à peu insuffisante vis-à-vis des besoins croissants d'exactitude, tant pour les mesures géodésiques que pour les mesures physiques. Ainsi, il était difficile d'étalonner une règle métrique à 0,1 mm près à partir de cet étalon, dont les extrémités sont assez grossièrement ajustées. Cette qualité métrologique était largement suffisante en 1799, mais plus en 1860. Par exemple, des incohérences se manifestaient lorsqu'on essayait de raccorder entre eux les relevés géodésiques des différents pays pour constituer un réseau géodésique européen. La Convention du Mètre, signée le 20 mai 1875 par dix-huit États, créa le Bureau international des poids et mesures (BIPM). La mission de ce laboratoire scientifique permanent était de conserver des étalons internationaux du mètre et du kilogramme et de vérifier les étalons nationaux.

Une commission internationale, dans laquelle la section française était évidemment la plus active, travailla de 1870 à 1888 pour élaborer les nouveaux étalons internationaux et nationaux. Un cahier des charges très rigoureux fut élaboré. Il spécifiait notamment la pureté du métal à utiliser pour fabriquer les étalons, à savoir du platine allié à 10% d'iridium. Il s'agissait en gros du même métal que celui employé pour les étalons de 1799, mais plus pur et plus homogène. Il décrivait aussi le profil en X des règles métriques, qui devaient être des règles à traits gravés dans le plan de la fibre neutre, et les tolérances sur les écarts mesurés entre les différents prototypes[6]. Parmi les règles ainsi réalisées, on en choisit une commePrototype International. Sa longueur reproduisait avec toute l'exactitude qu'on pouvait atteindre celle du Mètre des Archives. C'est finalement le 26 septembre 1889 que la Première Conférence Générale des Poids et Mesures (CGPM) put procéder par tirage au sort à la distribution des nouveaux étalons et sanctionner le Prototype International en ces termes : « les dix-huit[7] États signataires de la Convention du Mètre… sanctionnent à l'unanimité… le prototype du mètre choisi par le Comité international ; ce prototype représentera désormais, à la température de la glace fondante, l'unité métrique de longueur. » Cette fois-ci, il s'agit d'une redéfinition du mètre qui supplante celle de 1799, puisque plus aucune référence n'est faite à la longueur du quart de méridien. Toutefois, le rattachement à la définition originale de 1795 reste implicite. En effet, ce n'est pas un prototype quelconque qu'on a choisi comme étalon international, mais bien celui qui reproduisait au mieux le Mètre des Archives, lequel reproduisait au mieux la dix-millionième partie du quart de méridien.

La définition de 1889 mentionne explicitement la température de l'étalon. Les besoins en précision des mesures allant croissants, d'autres facteurs physiques allaient devoir être spécifiés plus tard. Ainsi, lors de la 7e CGPM qui s'est tenue en 1927, on apportait les précisions suivantes, qui ne constituaient toutefois pas une nouvelle définition du mètre : « L'unité de longueur est le mètre défini par la distance, à 0°C, des axes des deux traits médians tracés sur la barre en platine iridié déposée au Bureau international des poids et mesures, cette règle étant soumise à la pression atmosphérique normale et supportée par deux rouleaux d'au moins un centimètre de diamètre situés symétriquement dans un même plan horizontal et à la distance de 571 mm l'un de l'autre ». Des précisions subsidiaires, on pourrait en mettre d'autres. Ainsi, on pourrait par exemple indiquer l'intensité de la pesanteur et les conditions d'éclairement et d'observation des traits gravés. On serait alors amené à rédiger des définitions de plus en plus compliquées, chaque fois que la qualité croissante des mesures exigerait de préciser l'une ou l'autre condition considérée jusque là comme mineure. En fait, la démarche actuelle est de donner une définition simple et claire, fondée si possible sur un phénomène naturel, et de donner séparément des règles de mise en pratique, où l'on précise les précautions à prendre pour mettre en œuvre la définition lorsqu'on veut obtenir une exactitude prescrite. Il est ainsi possible de réviser la mise en pratique sans toucher à la définition.

Quelques physiciens, parmi lesquels le Français Jacques Babinet (1794–1872) et l'Écossais James Clerk Maxwell (1831–1879), avaient suggéré bien avant 1889 d'employer une longueur d'onde associée à la lumière comme étalon naturel de longueur. Le problème était de passer de façon très précise d'une telle quantité microscopique à une longueur macroscopique. Cela devenait possible avec l'interféromètre inventé par le physicien américain d'origine polonaise Albert A. Michelson (1852–1931). En 1892--1893, Michelson mesurait avec son collègue français J.-René Benoît au BIPM la longueur d'onde d'une radiation rouge émise par une lampe à cadmium, dans l'espoir que cette radiation servirait de base à une nouvelle définition du mètre. Toutefois, la raie rouge du cadmium naturel n'avait pas toute la finesse requise pour supplanter la règle en platine iridié, mais elle devint l'étalon privilégié de longueur d'onde pour la spectroscopie et la physique atomique pendant un demi-siècle.

La définition du mètre de 1960

Ce n'est que vers la fin des années 1950 qu'on parvenait à séparer des isotopes purs. On se rendit alors compte qu'une raie du krypton-86 à 6057,80 Å avait toute la finesse voulue pour servir de nouvel étalon naturel à l'unité de longueur. La 11e CGPM décida donc le 14 octobre 1960 que « le mètre est la longueur égale à 1 650 763,73 longueurs d'onde dans le vide de la radiation correspondant à la transition entre les niveaux 2p10 et 5d5 de l'atome de krypton-86 ». S'agissant d'un étalon naturel, tout laboratoire convenablement équipé pouvait donc reproduire le mètre et mesurer interférométriquement des longueurs avec ce nouvel étalon. A condition de respecter les règles de mise en pratique publiées séparément, on pouvait reproduire le mètre à mieux que ± 4 x 10–9 près dans des laboratoires indépendants.

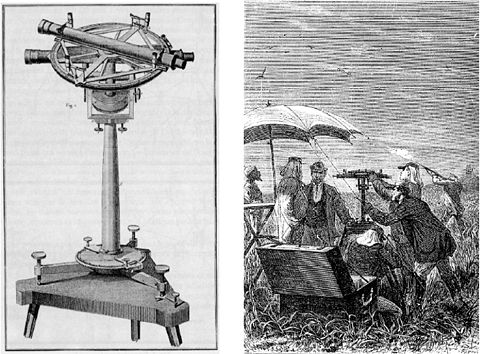

Le nombre 1 650 763,73 avait été choisi pour assurer le raccordement aux définitions antérieures du mètre et pour conserver la valeur de la longueur d'onde de la radiation rouge du cadmium, laquelle servait de référence aux valeurs publiées dans de nombreuses tables de longueurs d'onde utilisées par les spectroscopistes. Cependant, cette troisième définition du mètre avait un défaut, qui allait se montrer gênant pour le progrès de la géodésie spatiale et même pour le progrès de la géodésie bidimensionnelle : la lumière de la lampe à krypton-86, bien que parfaitement monochromatique, n'est pas cohérente et permet à peine d'atteindre une différence de marche optique d'un mètre. Or, avec l'arrivée sur le marché d'instruments géodésiques mesurant des distances (géodimètres, telluromètres) qui remplaçaient en partie les instruments classiques de mesure d'angles, à savoir les théodolites, les réseaux géodésiques dépendaient de plus en plus de trilatérations au détriment des traditionnelles triangulations. Ces mesures, qui mettent en œuvre des distances bien plus grandes que le mètre, sont basées sur la propagation d'ondes électromagnétiques. Soit ∆t la durée nécessaire à ces ondes pour effectuer un trajet aller-retour entre un émetteur/récepteur (un géodimètre, p.ex.) et une mire réfléchissante (un prisme à réflexion totale). En englobant dans ∆t des corrections tenant compte de l'état de l'atmosphère et à condition de pouvoir déterminer des différences de chemin optique très grandes pour pouvoir appliquer les techniques interférométriques, la distance émetteur–mire s'obtient avec grande précision grâce à la formule d = ½ c ∆t, c étant la vitesse de la lumière dans le vide.

Afin d'obtenir une précision optimale, deux conditions essentielles sont donc à remplir : d'une part, il faut disposer d'une source de lumière stable, intense, directive (autrement dit, cohérente) et extrêmement monochromatique ; d'autre part, il faut connaître la vitesse de la lumière avec un maximum de précision. En ce qui concerne la première condition, de telles sources sont justement apparues vers 1960, mais n'étaient pas très stables ni très intenses au début. Cependant, elles ont vite été améliorées jusqu'à devenir parfaitement adaptées à l'interférométrie jusqu'à des différences de marche pratiquement illimitées. Ces sources s'appellent des masers lorsqu'elles utilisent du rayonnement infrarouge et des lasers lorsqu'elles utilisent de la lumière visible. On pensa donc très vite après 1960 à remplacer le krypton-86 par un laser. Mais quel laser choisir ? La solution s'est très vite imposée avec les prodigieux progrès faits très vite dans la mesure du temps, elle aussi basée sur les lasers. En effet, la mesure des fréquences des radiations émises par les divers lasers s'appuie sur les méthodes classiques de la radioélectricité. Elle consiste en une multiplication de fréquence par génération d'harmoniques suivie d'une mesure de la fréquence des battements entre un harmonique d'ordre connu et la fréquence inconnue du laser. En peu de temps, de véritables chaînes de multiplication de fréquence ont ainsi permis de relier la fréquence de définition de la seconde, vers 10 GHz, d'abord aux fréquences de l'infrarouge (de l'ordre de 100 THz à une longueur d'onde de 3 µm) pour les masers, puis jusqu'aux fréquences visibles (de l'ordre de 500 THz à une longueur d'onde de 0,6 µm).

La définition du mètre depuis 1983

Ces mesures de temps/fréquence, jointes aux mesures des longueurs d'onde des mêmes radiations, ont fourni vers 1972 pour la vitesse de la lumière dans le vide une valeur environ cent fois plus précise que la meilleure valeur connue jusqu'alors. Cette valeur de c était 299 792 458,0 ± 1,2 m/s. Toutefois, pour évaluer c, il fallait se référer au mètre. Ainsi, l'incertitude ultime avec laquelle on pouvait mettre en pratique la définition du mètre de 1960 constituait la principale composante de l'incertitude de cette nouvelle détermination. Il devenait donc vite évident, du moins pour les géodésiens, qu'il fallait échanger les rôles : au lieu d'exprimer la vitesse de la lumière à partir du mètre, lui-même défini à partir de la longueur d'onde d'une radiation de l'isotope de masse atomique 86 du krypton, il fallait définir le mètre à partir de la vitesse de la lumière. Pour ce faire, il fallait utiliser celle-ci pour déterminer la longueur d'onde des radiations, utilisées elles-mêmes pour mesurer les distances macroscopiques par interférométrie. La 17e CIPM entérina le 20 octobre 1983 cette idée en établissant la définition du mètre actuellement en vigueur: Le mètre est la longueur du trajet parcouru dans le vide par la lumière pendant une durée de 1/299 792 458 de seconde. Depuis cette date, la vitesse de la lumière dans le vide est connue sans erreur, puisqu'elle sert de constante de définition :

c = 299 792 458 m/s.

La mise en pratique de cette définition fait l'objet d'une recommandation distincte. Dans l'état actuel, on estime l'incertitude relative des longueurs d'onde à 10–10 environ. Le choix de la constante de définition c permet de conserver la continuité avec la définition du mètre basée sur la longueur d'onde de la radiation de la lampe à krypton et, au bout du compte, avec la définition géodésique de 1791 et du Mètre des Archives.

Conclusion

Les précisions nouvelles introduites dans la définition du mètre datant des années 1889, 1960 et 1983 n'avaient nullement l'intention de changer la valeur du mètre définitif de 1799. Par contre, on peut dire que par rapport à sa définition de 1791, le mètre définitif fut conçu trop court d'environ 0,197 millième, tandis que le mètre provisoire, basé sur les valeurs « pré-révolutionnaire » de Lacaille fut, avec environ 0,128 millième de trop, nettement plus précis. Même la valeur corrigée par Delambre en 1810 de 443,328 lignes est toujours 0,1244 millième trop court. Il n'est pas mieux de manière significative que la valeur du mètre provisoire. De ce point de vue les travaux de Delambre et Méchain, ayant duré près de sept ans, furent incontestablement un échec.

Précurseurs dans la promotion de mesures décimales

Faire accepter le mètre comme unité de mesure de longueur était une chose, faire accepter le système métrique décimal dans son ensemble en était une autre. Ce fut sans doute l'abbé lyonnais Gabriel Mouton (1618–1694) qui, le premier, proposa clairement à la fois un système décimal d'unités et un étalon rattaché à une dimension « naturelle ». À vrai dire, les avantages du système décimal sur le traditionnel calcul duodécimal, ou sexagésimal, avaient été décrits près d'un siècle auparavant par le Brugeois Simon Stevin (1548–1620)[8]. Toutefois, adopter le mètre revenait à adopter par la même occasion le système métrique décimal.

Bibliographie

- S. Débarbat & A.E. Ten, éditeurs (1993). Mètre et Système Métrique. Observatoire de Paris et Instituto de Estudios Documentales sobre la Ciencia, Universidad de Valencia.

- L. Marquet & A. Le Bouch (1989). L'Épopée du Mètre. Histoire dy Système Métrique Décimal. Ministère de l'Industrie et de l'Aménagement du Territoire, Paris.

- A.-M. Motais de Narbonne & J. Alexandre (1988). Une mesure révolutionnaire : le mètre. Observatoire de Paris.

- Arkan Simaan, La Science au péril de sa vie - les aventuriers de la mesure du monde (Coédition Vuibert et Adapt, 2001).

Voir aussi

- Figure de la Terre dans l'Antiquité,

- Figure de la Terre au Moyen Âge,

- Figure de la Terre à la Renaissance,

- Figure de la Terre et gravitation universelle,

- Modèle ellipsoïdal de la Terre,

- Figure de la Terre et les expéditions de Laponie et du Pérou,

- Sphéroïde de Clairaut,

- Masse de la Terre,

- Figure de la Terre et méridienne de Delambre et Méchain,

- Figure de la Terre et histoire du mètre,

- Géoïde

Notes

- Plus tard, on attribuera ces incohérences à des anomalies du géoïde.

- Ce n'est qu'un peu plus tard que Delambre publia son ouvrage cité plus haut où, ensemble avec Legendre, il montra comment s'affranchir avec une approximation suffisante de la dépendance du mètre vis-à-vis de l'aplatissement.

- On admet aujourd'hui que Q = 10001965,7 m. En fait, peu importe actuellement la manière dont le mètre fut défini à l'origine, ce qui compte, c'est qu'il existe et qu'il puisse être employé en tant qu'unité de longueur universellement acceptée. L'exigence d'unités universelles est toujours allée de pair avec un pouvoir centralisateur fort. Ce n'est donc guère étonnant de constater que Charlemagne a décidé la création d'un étalon universel de longueur. La volonté impériale fut traduite en l'an 789 dans un capitulaire faisant référence au propos « poids et poids, mesure et mesure, — deux choses en horreur à Yahvé », tiré du verset (20,10) du livre biblique des « Proverbes ». L'étalon universel voulu par Charlemagne se devait donc d'être particulièrement sacré. On pensait donc au pied du Christ, ou plus précisément à l'empreinte de ce pied qui s'était gravée sur le Saint-Sépulcre à Jérusalem. Mais finalement on promulgua un pied-de-Roi de 0,3284 mètre, que l'on faisait dériver de la coudée longue égyptienne de 28 doigts remontant pratiquement à l'âge des pyramides. Avec l'émiettement du pouvoir politique féodal, des étalons de mesure régionaux et même locaux se multiplièrent, mais par tradition dérivaient souvent de systèmes métrologiques antiques. Les ordres monastiques bâtisseurs conservaient jalousement le pied-du-Roi, et c'est tout naturellement que ce dernier s'imposait de nouveau avec la réémergence d'un pouvoir royal fort. La toise du Châtelet, valant 6 pieds-de-Roi, était matérialisée par l'écartement entre deux repères fixés au mur du Châtelet à Paris. Malheureusement, en 1667, un des supports de cette toise-étalon s'affaissa légèrement. L'Académie Royale des Sciences nouvellement créée fut chargée de rétablir l'étalon de longueur à sa valeur traditionnelle. Cette toise du Châtelet devint donc aussi la toise de l'Académie, matérialisée sous forme de la règle-étalon ayant servi comme base de mesure lors de l'expédition au Pérou. La toise du Pérou, ou plutôt la toise de l'Académie, fut promulguée longueur-étalon par Louis XV, qui chargea le 16 mai 1766 le sieur Mathieu Tillet (1714–1791), membre de l'Académie des Sciences, de la fabrication de 80 copies à envoyer dans les principales villes de son royaume. Matériellement, le mètre se rattache donc initialement à la toise du Pérou, qui renvoie au pied-du-Roi de Charlemagne, et en fin de compte à la coudée des pharaons.

- La distance de l'équateur au pôle selon WGS84; calculé par Sigurd Humerfelt.

- www.industrie.gouv.fr: Un historique du mètre, au chapitre 2.2.

- Pour les étalons du mètre, la tolérance spécifiée sur les écarts est de 0,01 mm, ces écarts étant eux-mêmes déterminés à 0,2 mm près.

- Maintenant, il y en a une cinquantaine.

- Ces idées de Stevin concernant les avantages d'un système de calcul à base 10 se trouvent réunies en appendice d'une quinzaine de pages à sa volumineuse Pratique d'Arithmétique. L'opuscule en question s'intitule Disme, espèce d'arithmétique inventée par la Dixième progression. Stevin ne se préoccupait pas des unités métrologiques. Par contre, dans un appendice inséré en fin de son volumineux ouvrage Observationes diametrarum Solis et Lunae apparentium, Gabriel Mouton notait combien il était difficile de comparer des mesures de physique exécutées à l'aide d'unités bizarres. Il proposait par conséquent d'utiliser une hiérarchie décimale d'unités. Il se référait explicitement à la mesure du degré de méridien faite par le Père Riccioli. Sa proposition n'eut guère d'écho, sinon que sa plus grande unité, le milliare, reste fort employée de nos jours sous l'appellation mille nautique. Bien qu'il n'ait pas réellement d'existence légale, le mille nautique de 1852 mètres est universellement en usage pour la navigation des avions et des bateaux. Le milliare de Mouton représentait la soixantième partie d'un degré de méridien. Selon les mesures très imprécises du Père Giovanni Riccioli, cela conduisait à environ 2035 mètres. Le mille nautique représente précisément la longueur d'un soixantième de degré de méridien, dont la valeur est corrigée par rapport à la valeur erronée du mille (géométrique) (ou milliare) de l'abbé lyonnais. Le mille nautique est donc une unité naturelle, dans la mesure où l'on a conservé la division du cercle en 360º. Le mille nautique a été défini en 1929 par une convention internationale comme unité de distance valant 1852 mètres. La Grande-Bretagne et les pays du Commonwealth britannique ont préféré une valeur de 1853,18 mètres.

- Portail de la géodésie et de la géophysique

- Portail de la physique

Catégories :- Histoire des sciences

- Histoire de la géodésie

- Histoire de la physique

- Figure de la Terre

Wikimedia Foundation. 2010.