- Singularité technologique

-

La frise chronologique de Ray Kurzweil date le moment où un superordinateur sera plus puissant qu'un cerveau humain, et pourra alors le simuler : il s'agit d'une méthode envisagée pour créer une intelligence artificielle, utilisée notamment dans le projet Blue Brain.

La frise chronologique de Ray Kurzweil date le moment où un superordinateur sera plus puissant qu'un cerveau humain, et pourra alors le simuler : il s'agit d'une méthode envisagée pour créer une intelligence artificielle, utilisée notamment dans le projet Blue Brain.

La Singularité technologique (ou simplement la Singularité) est un concept, selon lequel, à partir d'un point hypothétique de son évolution technologique, la civilisation humaine connaîtra une croissance technologique d'un ordre supérieur. Pour beaucoup, il est question d'intelligence artificielle quelle que soit la méthode pour la créer. Au-delà de ce point, le progrès ne serait plus l’œuvre que d’Intelligences artificielles, elles-mêmes en constante progression. Il induit des changements tels sur la société humaine que l’individu humain d’avant la Singularité ne peut ni les appréhender ni les prédire de manière fiable. Le risque étant la perte de pouvoir humain, politique, sur son destin[1].

Cet évènement est ainsi nommé par analogie avec l’impuissance de la physique moderne à proximité de la singularité gravitationnelle d'un trou noir, les forces en œuvre étant énormes bien que non infinies.

De telles conséquences ont été débattues dans les années 1960 par I. J. Good (voir l’article Intelligence artificielle). Selon Ray Kurzweil[2], cette notion de Singularité technologique aurait été introduite par John von Neumann dans les années 1950[3]. La Singularité a acquis une certaine popularité dans les années 1980 grâce à Vernor Vinge. La venue éventuelle et la date de la Singularité sont sujettes à débat, mais les futurologues et les transhumanistes l’attendent en général pour la troisième décennie du XXIe siècle.

Étant donné la rapidité de progression actuelle, les superordinateurs sont prévus pour atteindre 1 exaflops en 2019[4]. Cray Inc. a annoncé en décembre 2009, un projet de construction d'un supercalculateur d'1 exaflops à la fin des années 2010[5].

Sommaire

Émergence du concept

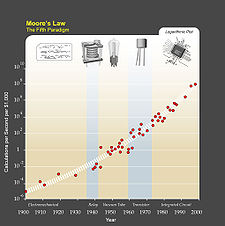

Kurzweil écrit que, en raison du changement de paradigme, une tendance de la croissance exponentielle va des circuits intégrés jusqu'aux récents transistors, les tubes à vide, les relais, et les ordinateurs électromécaniques.

Kurzweil écrit que, en raison du changement de paradigme, une tendance de la croissance exponentielle va des circuits intégrés jusqu'aux récents transistors, les tubes à vide, les relais, et les ordinateurs électromécaniques.

L'idée de présenter l'histoire logarithmiquement remonte au moins à 1932, avec John B. Sparks et son « Histomap de l'Evolution ». Vers la même époque, cette idée a également été explorée par le cybernéticien Heinz von Foerster (secrétaire des conférences Macy auxquelles a participé John von Neumann, entre autres) [6], qui s'en servait pour proposer que les souvenirs s'estompent naturellement d'une manière exponentielle.

Même s’il est communément admis que le concept de Singularité s’est développé au cours des deux dernières décennies du XXe siècle, l’origine du terme remonte en fait aux années 1950 :

- « L’une des conversations avait pour sujet l’accélération constante du progrès technologique et des changements du mode de vie humain, qui semble nous rapprocher d’une singularité fondamentale de l’histoire de l’évolution de l’espèce, au-delà de laquelle l’activité humaine, telle que nous la connaissons, ne pourrait se poursuivre. » — Stanislaw Ulam, mai 1958, au sujet d’une conversation avec John von Neumann.

Dans sa conférence du 22 juin 1955, « Psychanalyse et cybernétique ou de la nature du langage », Jacques Lacan relève, à son époque, un bougé des lignes du côté de la science, frémissement qu’il perçoit ainsi: « quelque chose est passé dans le réel, et nous sommes à nous demander – peut-être pas très longtemps, mais des esprits non négligeables le font - si nous avons une machine qui pense »

Cette citation fut à plusieurs reprises extraite de son contexte et attribuée à John von Neumann lui-même, probablement du fait de sa réputation et de son influence.

En 1965, Irving John Good décrit un concept de singularité plus proche de son acception actuelle, dans le sens où il inclut l’arrivée d’intelligences artificielles qui prennent le relais (bootstrap) :

« Mettons qu’une machine supra-intelligente soit une machine capable dans tous les domaines d’activités intellectuelles de grandement surpasser un humain, aussi brillant soit-il. Comme la conception de telles machines est l’une de ces activités intellectuelles, une machine supra-intelligente pourrait concevoir des machines encore meilleures ; il y aurait alors sans conteste une “explosion d’intelligence”, et l’intelligence humaine serait très vite dépassée. Ainsi, l’invention de la première machine supra-intelligente est la dernière invention que l’Homme ait besoin de réaliser. »

Le terme de singularité ne désigne pas une croissance devenant infinie à l'instar d'une singularité mathématique, mais représente le fait que les modèles prédictifs existants ne sont plus appropriés à sa proximité, de la même façon que les modèles physiques actuels ne sont plus adaptés au voisinage d’une singularité de l'espace-temps.

La singularité vingienne

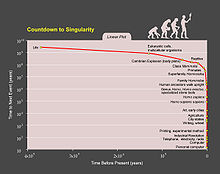

Lorsqu’on les représente sur un graphe logarithmique 15 listes différentes d’évènements de l'histoire humaine montreraient une tendance exponentielle. Listes préparées entre autres par Carl Sagan, Paul D. Boyer, Encyclopædia Britannica, American Museum of Natural History et l’Université de l’Arizona, compilées par Ray Kurzweil.

Lorsqu’on les représente sur un graphe logarithmique 15 listes différentes d’évènements de l'histoire humaine montreraient une tendance exponentielle. Listes préparées entre autres par Carl Sagan, Paul D. Boyer, Encyclopædia Britannica, American Museum of Natural History et l’Université de l’Arizona, compilées par Ray Kurzweil.

Le concept de Singularité technologique fut repopularisé en partie grâce au mathématicien et auteur Vernor Vinge[7]. Vinge a commencé à parler de la singularité dans les années 1980 et a formulé ses idées dans son premier article sur le sujet en 1993 : l’essai Technological Singularity (en). Il y postule que, d’ici trente ans, l’humanité aurait les moyens de créer une intelligence surhumaine mettant un terme à l’ère humaine. Depuis, la singularité a été le sujet de nombreuses nouvelles et essais futuristes.

Vinge écrit que des intelligences surhumaines, créées par des humains aux capacités augmentées cybernétiquement ou par d'autres intelligences artificielles moins développées, seraient capables d’améliorer leurs propres capacités plus efficacement que les esprits humains les ayant conçues. Ainsi, une spirale de progrès de plus en plus rapide amènerait à des progrès technologiques très importants en une courte période de temps.

La Singularité peut être vue comme la fin des civilisations humaines actuelles et le début d’une nouvelle organisation. Dans son œuvre, Vinge s’interroge sur les raisons de cette fin et conclut que les humains pourraient s'organiser pendant la Singularité en une forme supérieure d’intelligence. Après la création de cette intelligence "surhumaine", les humains seraient, d’après Vinge, des formes de vie ayant une moindre influence sur le développement du monde, plutôt membres participants à un système que "pilotes dans l'avion".

L'explosion de l'intelligence

Irving John Good a spéculé en 1965 sur les effets des machines plus intelligentes que les hommes:

Soit une machine ultraintelligente définie comme une machine qui peut largement dépasser toutes les activités intellectuelles d'un homme si habile soit-il. Comme la conception de machines est l'une de ces activités intellectuelles, une machine ultraintelligente pourrait concevoir des machines encore plus poussées : il y aurait alors incontestablement une « explosion de l'intelligence », et l'intelligence de l'homme serait laissée loin derrière. Ainsi, la première machine ultraintelligente sera la dernière invention que l'Homme doive jamais faire.

Jeff Hawkins a répondu à cette spéculation dans le rapport spécial IEEE Spectrum sur la singularité[8]:

Le terme "Singularité", appliqué à des machines intelligentes se réfère à l'idée que lorsque des machines intelligentes peuvent concevoir des machines intelligentes, plus intelligentes qu'elles, cela provoquera une croissance exponentielle de l'intelligence des machines conduisant à une singularité de l'intelligence à l'infini (ou du moins immense). La croyance en cette idée se fonde sur une conception naïve de ce qu'est l'intelligence. Par analogie, imaginez que nous ayons un ordinateur qui pourrait concevoir de nouveaux ordinateurs (puces, systèmes et logiciels) plus rapides que lui-même. Est ce qu'un tel ordinateur produirait infiniment des ordinateurs ou même des ordinateurs plus rapides que ce que les humains pourraient construire d'eux-mêmes ? Non, cela pourrait accélérer le rythme des améliorations pour un certain temps, mais à la fin il y a des limites de taille et de vitesse. Nous arriverions au même endroit, nous aurions tout simplement été un peu plus rapide en prenant des risques. Et il n'y aurait eu aucune singularité.

L'accélération du progrès

Eliezer Yudkowsky explique de manière abordable l'effet de l'accélération dans Scruter la Singularité[9] :

« La version courte :

- Si les vitesses de calcul doublent tous les deux ans, qu’arrive-t-il quand des IA informatisées font la recherche ?

- La vitesse de calcul double tous les deux ans.

- La vitesse de calcul double tous les deux ans de travail.

- La vitesse de calcul double tous les deux ans subjectifs de travail.

Deux ans après que les Intelligences Artificielles ont atteint l’équivalence humaine, leur vitesse double. Un an après, leur vitesse double de nouveau.

- Six mois ; trois mois ; 1,5 mois… Singularité.

Prenez les valeurs correspondant aux vitesses de calcul actuelles, à leur temps de doublement actuel, et à une estimation de la puissance de calcul brute du cerveau humain, et les valeurs coïncident en : 2021. »

Raymond Kurzweil a proposé des théories étendant la loi de Moore à des formes de calcul autres qu’informatiques, qui suggèrent que les phases de croissance exponentielle du progrès technologique feraient partie de motifs visibles à travers toute l’histoire humaine et même avant l’Apparition de la vie sur Terre, sa complexification biologique. D’après Kurzweil, ce motif aboutit au XXIe siècle à un progrès technologique inimaginable, ce qui ne veut pas dire infini.

Pour se représenter de manière abordable l'accélération de la vitesse, la vitesse étant le progrès, ce serait identique à un changement de vitesse sur une voiture ou un vélo : ce qui correspond à changer pour un rapport de couple supérieur permettant d'atteindre une vitesse supérieure, ce qui équivaut à plus de progrès pour une même valeur temporelle .

La vitesse des flux, la vitesse d'apprentissage dans une société sont des composantes pouvant définir des limites systémiques dans la société.

La question sera donc de savoir si toute l'humanité voudra changer de vitesse, ce qui pourrait par conséquent redéfinir la notion d'humanité, ou s’il y aura une humanité qui préfèrera rester à sa vitesse, ou peut être que l'avènement de la singularité se passera trop vite et personne ne pourrait réagir : en prendre conscience avec un temps de réaction et d'observation à la vitesse humaine, puis la réaction politique, et législative.

La définition de la singularité technologique serait alors un progrès technologique si rapide que cela dépasse la capacité des humains à la contrôler ou à la prédire, à la comprendre et à réagir à temps[10]. Quelles sont les conséquences à long terme de la révolution industrielle pour l'humanité ? Et n'est-ce pas déjà une forme de singularité ?

Les questions d'ordre philosophique surgissent : l'« humain » est-il dépassé, et y a-t-il un mal à accepter ses limites naturelles ? Y a-t-il un mal a vouloir s'améliorer ? Peut-on raisonnablement refuser le téléphone portable, dans notre société, et quelles en sont les conséquences ? Vous pouvez remplacer pour l'exemple l'outil téléphone portable par tout autre gadget à se greffer en permanence pour augmenter les capacités humaines. Slavoj Žižek pointe ce manque de réflexion de la société, et le manque d'attention voire de capacité et de temps pour la population, pour analyser et comprendre des grands problèmes philosophiques qui s'annoncent : OGM, manipulation génétique, cure génétique, intelligence artificielle, etc[11].

Loi de Moore

Selon la loi de Moore :

- Le nombre de transistors de la dernière gamme de processeur est doublé tous les "deux ans", ce chiffre a baissé d'où l'accélération de l'accélération exponentielle. Et selon Ray Kurzweil, cela devrait se poursuivre jusqu'en 2019 pour cette technologie, jusqu'à ce qu'un autre type de technologie prenne le relais(optique, quantique ou moléculaire)[12].

- Lawrence Krauss et Glenn D. Starkman annoncent quant à eux une limite ultime se trouvant dans 600 ans[13].

On remarque également :

- La puissance de calcul des superordinateurs est doublée tous les 10 mois.

- La taille mémoire disponible sur un disque dur est doublée tous les 18 mois[14] : Un disque 3.5 : 2011 - 4 Tera octet - 2014 - 16 Tera Octet[14] - Projection : 2023 - 1000 Tera Octet.

- La quantité d'information sur le réseau internet double tous les ~ 10 - 12 mois[15]

- Le trafic internet double tous les 15 mois [16]

- Le niveau et la vitesse des interrelations sociales, ou web temps réel, suit également la loi de Moore. (Avec par exemple 350 000 tweets, et 1 000 000 de liens bit.ly, et 9 nouvelles page wikipedia, par minute, ...)[17] ( voir aussi "Cerveau Global" )

- Les caméras, télescopes, IRMs ( appareil principalement médical ) et séquenceurs ADN ont une précision et rapidité qui double tous les 18 mois[18].

- La consommation d'énergie suit également cette évolution[19], et l'énergie solaire spatiale est envisagé par des pays et entreprises[20],[21]. Le soleil produit plus d'énergie que nous n'en produirons durablement à la surface de la terre.

Il faut remarquer qu'il y a une limite physique dans la technologie utilisée actuellement, l'électronique ne peut aller sous la taille d'un atome, le nanomètre.

Cependant plusieurs voies permettraient de dépasser cette limite :

- Le changement de l'élément lié à l'information, exemple les processeurs ou de la mémoire quantique, moléculaire. Les avancées en ordinateurs moléculaires[22], et quantique[23] démontrent les possibilités réelles de ces technologies. La technologie quantique permettrait de résoudre des problèmes complexes avec un nombre d'opération comparativement énormément diminué (simplification np complexe)[24],[25],[26]. La technologie moléculaire permettrait l'apprentissage et la résolution d'autres types de problèmes complexes[27],[28].

- Le changement d'architecture de processeur, les processeurs actuels ont une architecture parfaite pour les calculs, mais ne sont pas adaptés au problème complexe qui faciliterait la création d'une intelligence artificielle. Le DARPA a lancé un projet de construction de processeur probabiliste, le GP5, le cinquième type de processeur après les CPU, DSP, FPGA, et GPU[29]. Les probabilités sont utilisées en intelligence artificielle pour le datamining, pour l'approche probabiliste dans certains domaines de l'intelligence artificielle ( reconnaissance visuelle, linguistique computationelle, sémantique, apprentissage machine et logique floue )[30].

- Le changement de matériaux pour augmenter la fréquence (ex: gallium, gallium + sillicium[31])

- Si la limite est atteinte, pour obtenir plus de puissance il faudra plus d'espace, les processeurs peuvent évoluer sur plusieurs couches (les 3 dimensions)[32].

- Les progrès logiciels à effectuer sont nombreux : structures de bases de données, utilisation...

Les singularités

Intelligences Créatives et décisionnelles

Les singularités créatives seraient dans le domaine de la puissance de création et de recherche brut : une intelligence artificielle, si elle est créée, dépasserait rapidement l'ensemble de l'humanité dans ce domaine.

Culturelles

Les singularités culturelles visent à augmenter l'humain et ses perceptions par diverses informations pour créer une réalité augmentée, une immersion dans une réalité virtuelle ou parallèle à la nôtre.

L'ouverture (en parallèle avec le Principe responsabilité, et le Principe de précaution) est un des choix de politique de société en système ouvert important pour l'avenir :

- Selon Jamais Cascio : Une Singularité se basant sur l'"accès-libre" est une réponse aux risques à venir. Les personnes qui ont embrassé la possibilité d'un grand bouleversement pour l'humanité dans un avenir proche (appelé parfois singularité) devraient s'occuper à rendre possible l'intégration globale des intérêts particuliers dans des systèmes ouverts, au moins autant qu'ils travaillent à rendre possible la singularité[33].

Transhumanistes

Les transhumanistes comptent sur les biotechnologies, nanotechnologies, et sur d'autres technologies émergentes pour réaliser leur rêve : devenir autre chose que ce qu'ils sont : des humains.

La transplantation des identités humaines dans des superordinateurs rentrerait à la fois dans les domaines culturels, créatifs et décisionnels.

Critique des singularistes

Critique du modèle scientifique

Des auteurs, sans critiquer directement la notion de Singularité, remettent en question l'idée d'accélération technologique.

Le concept de singularité ne tient pas compte des besoins et des ressources disponibles en énergie. Soit il postule des ressources infinies, soit il estime sans le démontrer que les besoins ne changeront que peu. Accessoirement, il ne tient pas compte de la limite quantique à laquelle la miniaturisation des composants électroniques se heurtera nécessairement un jour, ni de perturbations négligeables aux échelles actuelles et qui ne le resteront pas forcément à d'autres échelles (particules alpha, etc.).

Les hypothèses relatives à la Singularité sont régulièrement critiquées pour leur manque de solidité scientifique. Theodore Modis rappelle par exemple[34] qu'une courbe exponentielle ne débouche sur aucune singularité, mais continue à croître à l'infini. Douglas Hofstadter se montre lui aussi très critique, craignant que cette idée n'exprime en fait qu'un vœu pieux[35].

Jonathan Huebner écrit en conclusion de son article que « la preuve avancée indique que le rythme de l'innovation a atteint un pic il y a environ un siècle et est maintenant en déclin. Ce déclin est le plus probablement dû à une limite économique de la technologie ou à une limite du cerveau humain que nous approchons. Nous avons déjà parcouru 85% du chemin qui nous sépare de cette limite, et le rythme du développement technologique diminuera à chaque année écoulée. » [36],[37]. De telles analyses se retrouvent également chez Bob Seidensticker[38] ou chez David Bodanis[39].

Il existe bien des limites politiques, économiques, militaires (et stratégiques), des limites en ressources, et surtout la connaissance et les découvertes technologiques ont également leurs limites. Comme le conçoit également Ray Kurzweil.

Critique humaine

La connaissance, et le développement technologique ayant leurs limites : doit on remettre volontairement ou non notre pouvoir de décision en tant que race humaine à une intelligence artificielle : Intelligence qui par définition ne pourra être contrôlée de manière fiable.

C'est une question de choix politique à la fois à la grandeur d'un état et à la fois individuel : il n'y a pas une singularité, mais des singularités[40].

Cette réflexion mérite d'être commencée dès aujourd'hui dans toutes les sphères :

- Peut-on accepter toute évolution technologique, ayant un impact sur la définition de ce qu'est l'humanité ?

- Peut-on accepter une évolution technologique, ayant un trop grand risque de perte de contrôle de la société humaine ?

La connaissance, et le développement technologique ayant leurs limites, il est tout à fait possible de se passer d'une intelligence artificielle pour faire des découvertes afin d'atteindre ses limites, peut-être moins rapidement, ce n'est pas le temps qui manque à l'humanité. Et cela doit être un choix (politique) et un choix individuel, et non un choix économique.

Critique dialectique

Plusieurs auteurs sont très critiques à l'endroit de la notion de singularité, notamment telle que développée par Ray Kurzweil. Theodore Modis écrit ainsi : « Ce que je veux dire est que Kurzweil et les singularistes sont impliqués dans une sorte de para-science, qui diffère des vraies sciences en termes de méthodologie et de rigueur. Ils ont tendance à négliger les pratiques scientifiques rigoureuses telles que se concentrer sur les lois naturelles, donner des définitions précises, vérifier les données méticuleusement, et estimer les incertitudes. [...] Kurzweil et les singularistes sont plus des croyants que des scientifiques. » [41],[34]). De son côté, Ted Gordon met également en doute les thèses de Kurzweil : « Kurzweil avance un argument frappant au sujet de l'accélération du changement. Il utilise de nombreuses courbes de croissance exponentielles, principalement concernant l'électronique, les nano-technologies et les ordinateurs, mais en incluant Internet et la biologie. Il montre une croissance similaire avec le PIB américain et le PIB par habitant. Il utilise également comme source majeure le travail de Modis sur le raccourcissement du temps entre les changements de paradigme. Il argumente en faveur de l'accélération du taux passé d'accélération et par conséquent de l'inévitabilité de la continuation de cet élan. Cependant, l'extrapolation sous toutes ses formes est dangereuse et condamnée en fin de compte à être fausse. » [42],[34].

Drew McDermott, sans être aussi sévère, s'inquiète des conséquences de ce genre de littérature pour les recherches en Intelligence Articielle : « Bien que je ne pense pas que Kurzweil ait prouvé son affirmation à propos de l'IA (et je n'ai rien à dire à propos de ses arguments concernant la génétique, les nano-technologies, la politique ou l'écologie), il pourrait voir juste. Mais juste ou faux, j'aimerais qu'il arrête d'écrire de tels livres ! Le domaine de l'IA est régulièrement empesté de lubies qui semblent surgir à la moindre perturbation » [43],[44].

Plus simplement, on peut se rappeler que les singularités prévues en histoire de la physique (effondrement de l'atome de Bohr, catastrophe de l'ultraviolet...) n'ont jamais été observées, mais ont conduit plus simplement à un changement de modèle à leur voisinage.Structure d'étude

À l'image du Santa Fe Institute créé pour regrouper les recherches sur le sujet de la complexité, mais sur une base d'activité saisonnière, une « université d'été de la Singularité » (Singularity University) a été créée en 2009 avec le concours de Google et de la NASA et offrira chaque été neuf semaines de cours sur le sujet à 120 étudiants[45] pour la somme de 25 000 dollars.

La singularité technologique dans la fiction

- La Culture, de Iain M. Banks

- Accelerando, de Charles Stross

- Rainbows End, de Vernor Vinge

- Down and Out in the Magic Kingdom, Cory Doctorow

- Three Worlds Collide, de Eliezer Yudkowsky

- The Metamorphosis of Prime Intellect, de Roger Williams

Notes et références

- Joy, Bill (April 2000), "Why the future doesn’t need us", Wired Magazine (8.04), http://www.wired.com/wired/archive/8.04/joy.html, retrieved 2007-08-07

- Ray Kurzweil, The Singularity is Near, Ed. Viking, 2005, p. 10

- Kurzweil appuie son propos en rapportant une citation apocryphe de Von Neumann, qui selon l'explication que donne Kurzweil (dans la 3e note du premier chapitre de son livre The singularity is Near) serait une paraphrase de Von Neumann par Stanislaw Ulam dans "Tribute to John Von Neumann". Bulletin of the American Mathematical Society 64.3, pt. 2 (May 1958). Von Neumann aurait ainsi dit, selon Ulam : « The ever accelerating process of technology [...] gives the appearance of approaching some essential singularity. (La rapidité toujours croissante des technologies nous donne l'impression d'approcher une singularité essentielle. » Comme le relève Theodore Modis (dans Technological Forecasting & Social Change 73 (2006) 95–127), ces propos signalent plus une illusion qu'un phénomène réel, ce qui s'éloigne de l'interprétation que donne Kurzweil de la citation de Von Neumann.

- (en) IBM breaks petaflop barrier, 2008. Mis en ligne le 10 juin 2008

- études Cray exascale informatique en Europe:

- http://www.stanford.edu/group/SHR/4-2/text/interviewvonf.html

- Voir les romans Un feu sur l'abîme, Au tréfonds du ciel et La Captive du temps perdu.

- The term 'singularity' applied to intelligent machines refers to the idea that when intelligent machines can design intelligent machines smarter than themselves, it will cause an exponential growth in machine intelligence leading to a singularity of infinite (or at least extremely large) intelligence. Belief in this idea is based on a naive understanding of what intelligence is. As an analogy, imagine we had a computer that could design new computers (chips, systems, and software) faster than itself. Would such a computer lead to infinitely fast computers or even computers that were faster than anything humans could ever build? No. It might accelerate the rate of improvements for a while, but in the end there are limits to how big and fast computers can run. We would end up in the same place; we'd just get there a bit faster. There would be no singularity.

- introduction de Scruter la Singularité, éditions hache

- The nanotech pioneers: where are they taking us? par Steven A. Edwards, (ISBN 9783527312900)

- Slajov Zizek en conférence chez Google

- Ray Kurzweil (2001-03-07). "The Law of Accelerating Returns". KurzweilAI.net. http://www.kurzweilai.net/articles/art0134.html?printable=1. Retrieved 2006-06-24.

- Ethan Mollick (2006). "Establishing Moore's Law". IEEE Annals of the History of Computing. http://www2.computer.org/portal/web/csdl/doi/10.1109/MAHC.2006.45. Retrieved 2008-10-18.

- Disque dur de 4 To chez Hitachi en 2011

- Internet growth: Is there a “Moore's Law” for data traffic?

- Le trafic Internet va quadrupler en cinq ans (cisco)

- Web2 Expo SF by Hilary Mason

- Data-intensive supercomputing Michael Norman, director of the San Diego Supercomputer Center (SDSC) at the University of California, San Diego (UCSD).

- World Energy in Exajoules by energy source from 1800 to 2008

- Solar Wind Power (SWP) Satellites could provide 100 billion times current world energy needs

- National Space Society Announces the Kalam-NSS Energy Initiative for Space Based Solar Power

- Brain-Like Computing on an Organic Molecular Layer

- Reconnaissance d’image : Google compte sur l’informatique quantique

- 10 page paper - Investigating the Performance of an Adiabatic Quantum Optimization Processor

- High performance Quantum Monte Carlo simulations on a large-scale Internet-based computing platform were used to compare the median adiabatic times with the median running times of two classical solvers

- New Developments in Quantum Algorithms

- Molecular Cellular Automata Achieves 700 bits of Parallel Processing

- Molecular computer mimics human brain, Processor can solve complex problems, even heal itself

- DARPA funds Mr Spock on a Chip, Lyric's probability processor

- Ben Goertzel at Singularity Summit 2009 -- Pathways to Beneficial Artificial General Intelligence

- Des puces hybrides Silicium-Nitrure de Gallium pour des transistors plus rapides

- "After the Transistor, a Leap Into the Microcosm", The New York Times, August 31, 2009. Retrieved August 31, 2009.

- Openness and the Metaverse Singularity by Jamais Cascio, Originally presented at Singularity Summit 2007, September 8, 2007. Reprinted with permission on KurzweilAI.net November 7, 2007. "For me, the solution is clear. Trust depends upon transparency. Transparency, in turn, requires openness. We need an Open Singularity."

- Technological Forecasting & Social Change 73 (2006) 95–127

- An Interview with Douglas R. Hofstadter, following I am a Strange Loop

- « the evidence presented indicates that the rate of innovation reached a peak over a hundred years ago and is now in decline. This decline is most likely due to an economic limit of technology or a limit of the human brain that we are approaching. We are now approximately 85% of the way to this limit, and the pace of technological development will diminish with each passing year »

- Jonathan Huebner, A possible declining trend for worldwide innovation, Technological Forecasting & Social Change 72 (2005) 980–986

- Bob Seidensticker, Future Hype: The Myths of Technology Change, Berrett-Koehler Publishers, Inc., 2006

- David Bodanis, Slow Forward, Is the speed of technological change an illusion? Discover, Vol. 27 No. 06, June 2006.

- Our world does not evolve along a single path but by multiple inter-related networked processes. Singularity Summit 2009: The Singularity Is Near, Ray Kurzweil

- « What I want to say is that Kurzweil and the singularitarians are indulging in some sort of para-science, which differs from real science in matters of methodology and rigor. They tend to overlook rigorous scientific practices such as focusing on natural laws, giving precise definitions, verifying the data meticulously, and estimating the uncertainties. [...] Kurzweil and the singularitarians are more believers than they are scientists »

- « Kurzweil makes an impressive argument about the acceleration of change. He uses many exponential growth curves, primarily drawn from electronics, nano-technology and computers, but including Internet and biology. He shows similar growth in real US GDP and GDP per capita. He also uses as one major source work by Modis on the shortening time between paradigm shifts. He argues for the acceleration of the past rate of acceleration and by implication the inevitability that this momentum will carry on. However, extrapolation in any guise is dangerous and ultimately bound to be wrong »

- « Although I don’t think Kurzweil has proved his case about AI (and I have had nothing to say about his arguments on genetics, nanotechnology, politics, or ecology), he may be right. But right or wrong, I wish he would stop writing these books! The field of AI is periodically plagued by “hype hurricanes” that seem to surge up from the slightest perturbation »

- D. McDermott, Kurzweil’s argument for the success of AI, Artificial Intelligence 170 (2006) 1227–1233

- "Unique university coming to Bay Area this year" 3 février 2009

Voir aussi

Articles connexes

- Erreur de prédiction

- Infosphère

- Noosphère

- Cerveau global

- Intelligence collective

- Intelligence artificielle (forte ou distribuée)

- Planétarisation

Auteurs :

Auteurs opposés complètement ou à une certaine forme de singularité :

Liens externes

- (en) Reducing long-term catastrophic risks from artificial intelligence, the Singularity Institute for Artificial Intelligence.

- (en) The singularity is near: when humans transcend biology(google books) par Ray Kurzweil, (ISBN 9780670033843)

- (en) Technological Singularity, Vernor Vinge, 1993.

- (en) Special report on the Singularity.

- (en) Singularity Symposium

- (en) Singularity Hub

Bibliographie

- Ray Kurzweil, « Humanité 2.0 : La bible du changement », M21 Editions, 2007, (ISBN 9782916260044) (traduction de « The Singularity is near »)

- Serge Boisse, « L'esprit, l'IA et la Singularité », (ISBN 978-2-9530512-1-6)

Wikimedia Foundation. 2010.