- Ordinateur

-

Un ordinateur est une machine électronique qui fonctionne par la lecture séquentielle d'un ensemble d'instructions qui lui font exécuter des opérations logiques et arithmétiques sur des chiffres binaires.

Dès sa mise sous tension, un ordinateur exécute, l'une après l'autre, des instructions qui lui font lire, manipuler, puis réécrire un ensemble de données auquel il a accès. Des tests et des sauts conditionnels permettent de changer d'instruction suivante, et donc d'agir différemment en fonction des données ou des nécessités du moment.

Les données à manipuler sont obtenues, soit par la lecture de mémoires, soit par la lecture de composants d'interface (périphériques) qui représentent des données physiques extérieures en valeurs binaires (déplacement d'une souris, touche appuyée sur un clavier, température, vitesse, compression...). Une fois utilisées, ou manipulées, les données sont réécrites, soit dans des mémoires, soit dans des composants qui peuvent transformer une valeur binaire en une action physique (écriture sur une imprimante ou sur un moniteur, accélération ou freinage d'un véhicule, changement de température d'un four ...).

L'ordinateur peut aussi répondre à des interruptions qui lui permettent d’exécuter des programmes de réponses spécifiques à chacune, puis de reprendre l’exécution séquentielle du programme interrompu.

La technique actuelle des ordinateurs date du milieu du xxe siècle. Ils peuvent être classés selon plusieurs critères[1] (domaine d'application, taille ou architecture).

Sommaire

Étymologie

Ordinateur apparait dans les dictionnaires du XIXe siècle comme synonyme peu usuel de ordonnateur: celui qui met en ordre[2]. Puis la locution ordinateur électronique désigne en 1960 une machine qui lit et classe sans intervention humaine[3].

Historique

Article détaillé : Histoire des ordinateurs.Les machines à calculer jouèrent un rôle primordial dans le développement des ordinateurs pour deux raisons tout à fait indépendantes. D'une part, pour leurs origines, c'est pendant le développement d'une machine à calculer différentielle que Charles Babbage imagina l’ancêtre des ordinateurs: une machine à calculer programmée par la lecture de cartes perforées (identiques à celles du métier à tisser Jacquard) avec mémoires et imprimantes, qui inspirera le développement des premiers ordinateurs cent ans plus tard (Z3, ABC, ENIAC, SSEM...) et qui nous amènera aux mainframes des années 1960. D'autre part, pour leur propagation, grâce à la sérendipité de l'invention du premier microprocesseur, qui fut inventé par Intel pendant le développement d'une machine à calculer électronique en 1971, qui est à l'origine de l'explosion de la micro-informatique à partir de 1975[4] et qui réside au cœur de tous les ordinateurs actuels quels que soit leurs tailles ou fonctions.

Outre les avancées observées dans l'industrie du textile et celles de l'électronique, les avancées de la mécanographie à la fin du XIXe siècle, pour achever les recensements aux Etats-Unis d'Amérique, la mécanisation de la cryptographie au début du XXe siècle, pour crypter puis décrypter automatiquement des messages, le développement des réseaux téléphoniques (à base de relais électromécaniques), sont aussi à prendre en compte pour comprendre l'avènement de ce nouveau genre de machine qui ne calculent pas (comme font/faisaient les calculatrices), mais lisent et interprètent des programmes qui -eux- calculent.

Pour le monde des idées, avant l'invention de ces nouvelles machines, l'élément fondateur de la science informatique est en 1936, la publication de l'article (en) [PDF] On Computable Numbers with an Application to the Entscheidungsproblem par Alan Turing qui allait déplacer le centre de préoccupation de certains scientifiques (mathématiciens et logiciens) de l'époque, du sujet de la calculabilité (ou décidabilité) ouvert par Hilbert, malmené par Godël, éclairci par Church, vers le sujet de la mécanisation du calcul (ou calculabilité effective). Dans ce texte de 35 pages, Turing expose une machine théorique capable d'effectuer tout calcul ; il démontre que cette machine est aussi puissante, au niveau du calcul, que tout être humain. Autrement dit, un problème mathématique possède une solution, si et seulement si, il existe une machine de Turing capable de résoudre ce problème. Par la suite, il expose une machine de Turing universelle apte à reproduire toute machine de Turing, il s'agit des concepts d'ordinateur, de programmation et de programme. Il termine en démontrant qu'il existe au moins un problème mathématique formellement insoluble, le problème de l'arrêt.

Peu avant la Seconde Guerre mondiale, apparurent les premières calculatrices électromécaniques, construites selon les idées d'Alan Turing. Les machines furent vite supplantées par les premiers calculateurs électroniques, nettement plus performants.

Le premier ordinateur fonctionnant en langage binaire fut le Colossus, conçu lors de la Seconde Guerre Mondiale, il n'était pas Turing-complet bien qu'Alan Turing ait travaillé au projet. À la fin de la guerre, il fut démonté et caché à cause de son importance stratégique. L'ENIAC, mis en service en 1946, est le premier ordinateur entièrement électronique construit pour être Turing-complet. Pendant ce projet (en juin 1945 un an avant la démonstration de l'ENIAC) est publié un article fondateur : (en) [PDF] First Draft of a Report on the EDVAC par John von Neumann donnant les bases de l'architecture utilisée dans la quasi totalité des ordinateurs depuis lors. Dans cet article Von Neumann veut concevoir un programme enregistré et programmé dans la machine. La première machine correspondant à cette architecture, dite depuis architecture de von Neumann, ne fut pas l'EDVAC qui ne sera livré qu'en Aout 1949, mais une machine expérimentale la Small-Scale Experimental Machine (SSEM ou "baby") construite à Manchester en juillet 1948.

Le mot ordinateur fut introduit par IBM France en 1955. François Girard, alors responsable du service publicité de l'entreprise, eut l'idée de consulter son ancien professeur de lettres à Paris, Jacques Perret, afin de lui demander de proposer un mot caractérisant le mieux possible ce que l'on appelait vulgairement un calculateur (traduction littérale du mot anglais « computer »). Ce dernier proposa « ordinateur », un mot tombé en désuétude désignant anciennement un ordonnateur, voire la notion d'ordre ecclésiastique dans l'église catholique (ordinant)[5],[6]. Le professeur suggéra plus précisément « ordinatrice électronique », le féminin ayant pu permettre, selon lui, de mieux distinguer l'usage religieux de l'usage comptable du mot[7],[8]. Le premier ordinateur multitâches est le Bull Gamma 60 en 1958.

Le premier ordinateur dit familial est l'Apple II, lancé en janvier 1977. Il a été suivi de nombreux autres, notamment l'Atari 400 en 1979, le TI99/4A, l'Hector et le Sinclair ZX81 en 1981, les MSX, le Commodore 64 en 1982, l'Oric-1 en 1983, l'Apple IIe, l'Amstrad CPC 464 en 1984 (suivi des 664 puis 6128)[9].

Généralités

Les ordinateurs furent d'abord utilisés pour le calcul (en nombres entiers d'abord, puis flottants). On ne peut cependant les assimiler à de simples calculateurs : en effet, le résultat du traitement d'un ordinateur peut être non seulement une série de nombres, mais aussi un nouveau programme (utilisable par cet ordinateur ou par un autre).

- Dans l'architecture de von Neumann, les données sont banalisées et peuvent être interprétées indifféremment comme des nombres, des instructions, des valeurs logiques ou tout symbole défini arbitrairement (lettre de l’alphabet, par exemple).

- Le calcul représente une des applications possibles. Dans ce cas, les données sont traitées comme des nombres.

- L’ordinateur est utilisé aussi pour ses possibilités d'organisation de l’information, entre autres sur des périphériques de stockage magnétique. On a calculé à la fin des années 1980 que sans les ordinateurs il faudrait toute la population française juste pour faire dans ce pays le seul travail des banques.

- Cette capacité d’organiser les informations a généralisé l’usage du traitement de texte dans le grand public ;

- la gestion des bases de données relationnelles permet également de retrouver et de consolider des informations réparties vues par l'utilisateur comme plusieurs tables indépendantes.

Cette création d'un néologisme fut à l'origine de traductions multiples des expressions supercomputer, superordinateur ou supercalculateur, et Quantum computer, calculateur quantique ou ordinateur quantique. Dans ce dernier cas, l'utilisation du mot « ordinateur » est justement surfaite car les possibilités envisageables pour le calcul quantique sont loin de la polyvalence d'un « ordinateur ».

L’expérience a appris à distinguer dans un ordinateur deux aspects, dont le second avait été au départ sous-estimé :

- l’architecture physique, matérielle (alias hardware ou hard) ;

- l’architecture logicielle (alias software ou soft) ; un ordinateur très avancé techniquement pour son époque comme le Gamma 60 de la compagnie Bull n’eut pas le succès attendu, pour la simple raison qu’il existait peu de moyens de mettre en œuvre commodément ses possibilités techniques. Le logiciel - et son complément les services (formation, maintenance, ...) - forme depuis le milieu des années 1980 l’essentiel des coûts d’équipement informatique, le matériel n’y ayant qu’une part minoritaire.

Les ordinateurs peuvent être sensibles aux bombes IEM.

Fonctionnement d’un ordinateur

Parmi toutes les machines inventées par l'Homme, l'ordinateur est celle qui se rapproche le plus du concept anthropologique suivant :

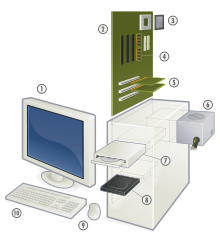

Organe d'entrée. Organe de traitement de l'information. Organe de sortie

Chez l'Homme, les organes d'entrée sont les cinq sens, l'organe de traitement est le cerveau dont les logiciels sont l'apprentissage avec des mises à jour constantes en cours de vie, puis les organes de sortie sont les muscles. Pour les ordinateurs modernes, les organes d'entrée sont le clavier et la souris et les organes de sortie, l'écran, l'imprimante, le graveur de DVD, etc.

Les techniques utilisées pour fabriquer ces machines ont énormément changé depuis les années 1940 et sont devenues une technologie (c’est-à-dire un ensemble industriel organisé autour de techniques) à part entière depuis les années 1970. Beaucoup utilisent encore les concepts définis par John von Neumann, bien que cette architecture soit en régression : les programmes ne se modifient plus guère eux-mêmes (ce qui serait considéré comme une mauvaise pratique de programmation), et le matériel prend en compte cette nouvelle donne en séparant aujourd'hui nettement le stockage des instructions et des données, y compris dans les caches.

L’architecture de von Neumann décomposait l’ordinateur en quatre parties distinctes :

- l’unité arithmétique et logique (UAL) ou unité de traitement : son rôle est d’effectuer les opérations de base, un peu comme le ferait une calculatrice ;

- l’unité de contrôle. C’est l’équivalent des doigts qui actionneraient la calculatrice ;

- la mémoire qui contient à la fois les données et le programme qui dira à l’unité de contrôle quels calculs faire sur ces données. La mémoire se divise entre mémoire vive (programmes et données en cours de fonctionnement) et mémoire permanente (programmes et données de base de la machine) ;

- les entrées-sorties : dispositifs qui permettent de communiquer avec le monde extérieur.

UAL et UC

L’unité arithmétique et logique ou UAL est l’élément qui réalise les opérations élémentaires (additions, soustractions...), les opérateurs logiques (ET, OU, NI, etc.) et les opérations de comparaison (par exemple la comparaison d’égalité entre deux zones de mémoire). C’est l’UAL qui effectue les calculs de l’ordinateur.

L’unité de contrôle prend ses instructions dans la mémoire. Celles-ci lui indiquent ce qu’elle doit ordonner à l’UAL et, comment elle devra éventuellement agir selon les résultats que celle-ci lui fournira. Une fois l’opération terminée, l’unité de contrôle passe soit à l’instruction suivante, soit à une autre instruction à laquelle le programme lui ordonne de se brancher.

L'unité de contrôle facilite la communication entre l'unité arithmétique et logique, la mémoire ainsi que les périphériques. Elle gère la plupart des exécutions des instructions dans l'ordinateur.

Mémoire

Au sein du système, la mémoire peut être décrite comme une suite de cellules numérotées contenant chacune une petite quantité d’informations. Cette information peut servir à indiquer à l’ordinateur ce qu’il doit faire (instructions) ou contenir des données à traiter. Dans la plupart des architectures, c'est la même mémoire qui est utilisée pour les deux fonctions. Dans les calculateurs massivement parallèles, on admet même que des instructions de programmes soient substituées à d’autres en cours d’opération lorsque cela se traduit par une plus grande efficacité. Cette pratique était jadis courante, mais les impératifs de lisibilité du génie logiciel l'ont fait régresser, hormis dans ce cas particulier, depuis plusieurs décennies.

Cette mémoire peut être réécrite autant de fois que nécessaire. La taille de chacun des blocs de mémoire ainsi que la technologie utilisée ont varié selon les coûts et les besoins : 8 bits pour les télécommunications, 12 bits pour l’instrumentation (DEC) et 60 bits pour de gros calculateurs scientifiques (Control Data). Un consensus a fini par être trouvé autour de l’octet comme unité adressable et d’instructions sur format de 4 ou 8 octets.

Dans tous les cas de figure, l'octet reste adressable, ce qui simplifie l'écriture des programmes.

Les techniques utilisées pour la réalisation des mémoires ont compris des relais électromécaniques, des tubes au mercure au sein desquels étaient générées des ondes acoustiques, des transistors individuels, des tores de ferrite et enfin des circuits intégrés incluant des millions de transistors.

Entrées-Sorties

Les dispositifs d’entrée/sortie permettent à l’ordinateur de communiquer avec l’extérieur. Ces dispositifs sont très importants, du clavier à l’écran. La carte réseau permet par exemple de relier les ordinateurs en réseau informatique, dont le plus grand est Internet.

Le point commun entre tous les périphériques d’entrée est qu’ils convertissent l’information qu’ils récupèrent de l’extérieur en données compréhensibles par l’ordinateur. À l’inverse, les périphériques de sortie décodent l’information fournie par l’ordinateur afin de la rendre compréhensible par l’utilisateur.

Bus

Ces différentes parties sont reliées par trois bus, le bus d'adresse, le bus de données et le bus de commande. Un bus est un groupement d'un certain nombre de fils électriques réalisant une liaison pour transporter des informations binaires codées sur plusieurs bits.

Le bus d'adresse transporte les adresses générées par l'UCT (Unité Centrale de Traitement) pour sélectionner une case mémoire ou un registre interne de l'un des blocs. Le nombre de bits véhiculés par ce bus dépend de la quantité de mémoire qui doit être adressée.

Le bus de données transporte les données échangées entre les différents éléments du système.

Le bus de contrôle transporte les différents signaux de synchronisation nécessaires au fonctionnement du système : signal de lecture (RD), signal d'écriture (WR), signal de sélection (CS : Chip Select).

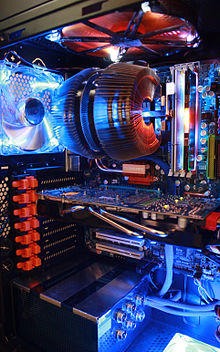

Architecture

La miniaturisation permet d’intégrer l’UAL et l’unité de contrôle au sein d’un même circuit intégré connu sous le nom de microprocesseur.

Typiquement, la mémoire est située sur des circuits intégrés proches du processeur, une partie de cette mémoire, la mémoire cache, pouvant être située sur le même circuit intégré que l’UAL.

L’ensemble est, sur la plupart des architectures, complété d’une horloge qui cadence le processeur. Bien sûr, on souhaite qu'elle soit le plus rapide possible, mais on ne peut pas augmenter sans limites sa vitesse pour deux raisons :

- plus l’horloge est rapide et plus le processeur dégage de la chaleur (selon le carré de la fréquence). Une trop grande température peut détériorer le processeur ;

- il existe une cadence où le processeur devient instable ; il génère des erreurs qui mènent le plus souvent à un plantage.

La tendance a été à partir de 2004 de regrouper plusieurs UAL dans le même processeur, voire plusieurs processeurs dans la même puce. En effet, la miniaturisation progressive (voir Loi de Moore) le permet sans grand changement de coût. Une autre tendance, depuis 2006 chez ARM, est aux microprocesseurs sans horloge : la moitié de la dissipation thermique est en effet due aux signaux d'horloge quand le microprocesseur fonctionne ; de plus, un microprocesseur sans horloge a une consommation presque nulle quand il ne fonctionne pas : le seul signal d'horloge nécessaire est alors celui destiné au rafraîchissement des mémoires. Cet atout est important pour les modèles portables.

Le principal écart fonctionnel aujourd’hui par rapport au modèle de Von Neumann est la présence sur certaines architectures de deux antémémoires différentes : une pour les instructions et une pour les données (alors que le modèle de Von Neumann spécifiait une mémoire commune pour les deux). La raison de cet écart est que la modification par un programme de ses propres instructions est aujourd’hui considérée (sauf sur les machines hautement parallèles) comme une pratique à proscrire. Dès lors, si le contenu du cache de données doit être récrit en mémoire principale quand il est modifié, on sait que celui du cache d’instructions n’aura jamais à l’être, d’où simplification des circuits et gain de performance.

Instructions

Les instructions que l’ordinateur peut comprendre ne sont pas celles du langage humain. Le matériel sait juste exécuter un nombre limité d’instructions bien définies. Des instructions typiques comprises par un ordinateur sont « copier le contenu de la cellule 123 et le placer dans la cellule 456 », « ajouter le contenu de la cellule 321 à celui de la cellule 654 et placer le résultat dans la cellule 777 » et « si le contenu de la cellule 999 vaut 0, exécuter l’instruction à la cellule 345 ». Mais la plupart des instructions se composent de deux zones : l’une indiquant quoi faire, qu’on nomme le code opération, et l’autre indiquant où le faire, qu’on nomme opérande.

Au sein de l’ordinateur, les instructions correspondent à des codes - le code pour une copie étant par exemple 001. L’ensemble d’instructions qu’un ordinateur supporte se nomme son langage machine, langage qui est une succession de chiffres binaires, car les instructions et données qui sont comprises par le processeur (CPU) sont constituées uniquement de 0 (zéro) et de 1 (un). 0 = Le courant électrique ne passe pas. 1 = Le courant électrique passe.

En général, les programmeurs n’utilisent plus ce type de langage, mais passent par ce que l’on appelle un langage de haut niveau qui est ensuite transformé en langage binaire par un programme spécial (interpréteur ou compilateur selon les besoins). Les programmes ainsi obtenus sont des programmes compilés compréhensibles par l'ordinateur dans son langage natif.

Certains langages de programmation, comme l’assembleur sont dits langages de bas niveau car les instructions qu’ils utilisent sont très proches de celles de l’ordinateur. Les programmes écrits dans ces langages sont ainsi très dépendants de la plate-forme pour laquelle ils ont été développés. Le langage C, beaucoup plus facile à relire que l’assembleur, permet donc aux programmeurs d’être plus productifs. Pour cette raison, on l’a vu de plus en plus utilisé à mesure que les coûts du matériel diminuaient et que les salaires horaires des programmeurs augmentaient.

Logiciels

Article détaillé : Logiciel.Les logiciels informatiques sont de longues listes d’instructions exécutables par un ordinateur. De nombreux programmes contiennent des millions d’instructions, effectuées pour certaines de manière répétitive. De nos jours, un ordinateur personnel exécute plusieurs milliards d’instructions par seconde.

Depuis le milieu des années 1960, des ordinateurs exécutent plusieurs programmes simultanément. Cette possibilité est appelée multitâche. C’est le cas de tous les ordinateurs aujourd’hui.

En réalité, chaque cœur de processeur n’exécute qu’un programme à la fois, passant d’un programme à l’autre chaque fois que nécessaire. Si la rapidité du processeur est suffisamment grande par rapport au nombre de tâches à exécuter, l’utilisateur aura l’impression d’une exécution simultanée des programmes. Les priorités associées aux différents programmes sont, en général, gérées par le système d'exploitation.

Système d’exploitation

Article détaillé : Système d'exploitation.Le système d’exploitation est le programme central qui contient les programmes de base nécessaires au bon fonctionnement des applications de l’ordinateur.

Le système d’exploitation alloue les ressources physiques de l’ordinateur (temps processeur, mémoire...) aux différents programmes en cours d’exécution. Il fournit aussi des outils aux logiciels (comme les pilotes) afin de leur faciliter l’utilisation des différents périphériques sans avoir à en connaître les détails physiques.

Types d’ordinateurs

-

IBM PC 5150 en 1983

-

superordinateur Columbia de la NASA en 2004

Par domaine d'application

- Les ordinateurs de taille moyenne (midrange) (exemples : IBM AS/400-ISeries, RS/6000...)

- Ordinateur personnel

- Serveur

- Système embarqué

- Ordinateur de bord

Par taille

- Ordinateur de poche : Assistant personnel, smartphone

- Ordinateur portable : Ultraportable, Tablette PC, Ordinateur portable

- Ordinateur de bureau : Mini PC, ordinateur de bureau, Station de travail

- Ordinateur intermédiaire : mini-ordinateur

- Ordinateur géant : Mainframe, Superordinateur

Par architecture

- Amiga

- Atari ST

- Compatible PC

- Macintosh

- stations SPARC

- ...

Notes et références

- Jargon fr - ordinateur sur http://jargonf.org/wiki/Accueil. Consulté le 1er avril 2008

- Napoléon Landais,Dictionnaire général et grammatical des dictionnaires français,Didier - 1849

- Pierre Guiraud,Problèmes et méthodes de la statistique linguistique,Springer - 1959,(ISBN 9789027700254)

- l'Altair 8800 qui eut Bill Gates et Paul Allen comme premiers programmeurs

- XMLittré - Ordinateur, trice sur http://francois.gannaz.free.fr/Littre/accueil.php. Consulté le 1er avril 2008

- Étymologie du mot ORDINATEUR : ordinateur (ancien français) sur http://www.presse-francophone.org/apfa/. Consulté le 22 février 2008

- Ordinateur : la (première page) de lettre manuscrite de J. Perret sur http://www.les-infostrateges.com/. Mis en ligne le 16 mai 2005, consulté le 22 février 2008

- Histoire de la création du mot Ordinateur : la lettre in extenso de J. Perret et son contexte expliqué par Gilles Zemor ENST sur news://loria.general. Mis en ligne le 23 août 1996, consulté le 12 mars 2008

- Gordon Laing, Digital Retro, The Evolution and Design of the Personal Computer. Sybex, 2004.

Voir aussi

Articles connexes

Wikimedia Foundation. 2010.