- Analyse en composantes principales

-

Pour les articles homonymes, voir ACP.

Pour les articles homonymes, voir ACP.L'Analyse en Composantes Principales (ACP) est une méthode de la famille de l'analyse des données et plus généralement de la statistique multivariée, qui consiste à transformer des variables liées entre elles (dites "corrélées" en statistique) en nouvelles variables décorrélées les unes des autres. Ces nouvelles variables sont nommées "composantes principales", ou axes. Elle permet au praticien de réduire l'information en un nombre de composantes plus limité que le nombre initial de variables.

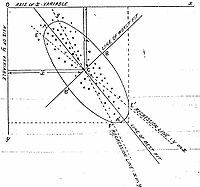

Il s'agit d'une approche à la fois géométrique (représentation des variables dans un nouvel espace géométrique selon des directions d'inertie maximale) et statistique (recherche d'axes indépendants expliquant au mieux la variabilité - la variance - des données). Lorsqu'on veut alors compresser un ensemble de N variables aléatoires, les n premiers axes de l'ACP sont un meilleur choix, du point de vue de l'inertie ou la variance expliquée (cf plus loin).

Sommaire

Histoire

L'ACP prend sa source dans un article de Karl Pearson publié en 1901[1]. Le père du Test du χ² y prolonge ses travaux dans le domaine de la régression et des corrélations entre plusieurs variables. Pearson utilise ces corrélations non plus pour expliquer une variable à partir des autres (comme en régression), mais pour décrire et résumer l'information contenue dans ces variables.

Encore connue sous le nom de transformée de Karhunen-Loève ou de transformée de Hotelling, l'ACP a été de nouveau développée et formalisée dans les années 1930 par Harold Hotelling[2] . La puissance mathématique de l'économiste et statisticien américain le conduira aussi à développer l'analyse canonique, généralisation des analyses factorielles dont fait partie l'ACP.

Les champs d'application sont aujourd'hui multiples, allant de la biologie à la recherche économique et sociale, et plus récemment le traitement d'images. L'ACP est majoritairement utilisée pour:

- décrire et visualiser des données ;

- les décorréler ; la nouvelle base est constituée d'axes qui ne sont pas corrélés entre eux ;

- les débruiter, en considérant que les axes que l'on décide d'oublier sont des axes bruités.

Exemples introductifs

Premier exemple

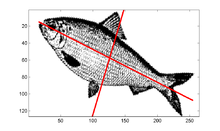

Dans le cas d'une image, comme dans la figure ci-contre, les pixels sont représentés dans un plan et considérés comme une variable aléatoire à deux dimensions. L'ACP va déterminer les deux axes qui expliquent le mieux la dispersion de l'objet, interprété comme un nuage de points. Elle va aussi les ordonner par inertie expliquée, le second axe étant perpendiculaire au premier.

Second exemple

Dans une école imaginaire, on n'enseigne que deux matières sur lesquelles les élèves sont notés: le français et les mathématiques. En appliquant l'ACP au tableau de notes, on dégagera probablement en premier axe des valeurs par élève très proches de leur moyenne générale dans les deux matières. C'est cet axe qui résumera au mieux la variabilité des résultats selon les élèves. Mais un professeur voulant pousser l'analyse des résultats, s'intéressa aussi au second axe, qui ordonne les élèves selon l'ampleur de leurs écarts entre les deux notes, et indépendamment du premier axe.

On comprend l'intérêt de la méthode d'ACP quand on étend l'analyse à 10 matières enseignées: la méthode va calculer pour chaque élève 10 nouvelles valeurs, selon 10 axes, chacun étant indépendant des autres. Les derniers axes apporteront très peu d'information au plan statistique: ils mettront probablement en évidence quelques élèves au profil singulier. Selon son point de vue d'analyse, le professeur veillera à ces élèves dans sa pratique quotidienne, corrigera peut-être une erreur qui s'est glissée dans son tableau, mais ne prendra pas en compte les derniers axes s'il s'agit d'une réflexion pédagogique plus globale.

La puissance de l'ACP est qu'elle sait aussi prendre en compte des données de nature hétérogène: par exemple un tableau des différents pays du monde avec le PNB par habitant, le taux d'alphabétisation, le taux d'équipement en téléphones portables, le prix moyen du hamburger, etc... Elle permet d'avoir une intuition rapide des effets conjoints entre ces variables.

Échantillon

On applique usuellement une ACP sur un ensemble de N variables aléatoires X1, …, XN connues à partir d'un échantillon de K réalisations conjointes de ces variables.

Cet échantillon de ces N variables aléatoires peut être structuré dans une matrice M à K lignes et N colonnes.

Chaque variable aléatoire Xn = (X1, n, …, XK, n)' a une moyenne

et un écart type σXn.

et un écart type σXn.Poids

Si les réalisations (les éléments de la matrice M) sont à probabilités égales alors chaque réalisation (un élément Xi,j de la matrice) a la même importance 1 / n dans le calcul des caractéristiques de l'échantillon. On peut aussi appliquer un poids pi différent à chaque réalisation conjointes des variables (cas des échantillons redressés, des données regroupées, ...). Ces poids, qui sont des nombres positifs de somme 1 sont représentés par une matrice diagonale D de taille K:

Dans le cas le plus usuel de poids égaux,

où I est la matrice identité.

où I est la matrice identité.Transformations de l'échantillon

Le vecteur

est le centre de gravité du nuage de points ; on le note souvent g. On a g = MTD1 où 1 désigne le vecteur de

est le centre de gravité du nuage de points ; on le note souvent g. On a g = MTD1 où 1 désigne le vecteur de  dont toutes les composantes sont égales à 1.

dont toutes les composantes sont égales à 1.La matrice M est généralement centrée sur le centre de gravité :

.

.

Elle peut être aussi réduite :

.

.

Le choix de réduire ou non le nuage de points (i.e. les K réalisations de la variable aléatoire (X1, …, XN)) est un choix de modèle :

- si on ne réduit pas le nuage : une variable à forte variance va « tirer » tout l'effet de l'ACP à elle ;

- si on réduit le nuage : une variable qui n'est qu'un bruit va se retrouver avec une variance apparente égale à une variable informative.

Calcul de covariances et de corrélations

Une fois la matrice M transformée en

ou

ou  , il suffit de la multiplier par sa transposée pour obtenir:

, il suffit de la multiplier par sa transposée pour obtenir:- la matrice de variance-covariance des X1, …, XN si M n'est pas réduite :

;

; - la matrice de corrélation des X1, …, XN si M est réduite :

.

.

Ces deux matrices sont carrées (de taille N), symétriques, et réelles. Elles sont donc diagonalisables dans une base orthonormée.

De façon plus générale, la matrice de variance-covariance s'écrit

. Si l'on note D1 / s la matrice diagonale des inverses des écarts-types:

. Si l'on note D1 / s la matrice diagonale des inverses des écarts-types:et

la matrice diagonale des inverses des variances, alors on a:

la matrice diagonale des inverses des variances, alors on a: .

.

La matrice des coefficients de corrélation linéaire entre les N variables prises deux à deux, notée R, s'écrit:

.

.

Critère d'inertie

Dans la suite de cet article, nous considèrerons que le nuage est transformé (centré et réduit si besoin est). Chaque Xn est donc remplacé par

ou

ou  . Nous utiliserons donc la matrice M pour noter

. Nous utiliserons donc la matrice M pour noter  ou

ou  suivant le cas.

suivant le cas.Le principe de l'ACP est de trouver un axe u, issu d'une combinaison linéaire des Xn, tel que la variance du nuage autour de cet axe soit maximale.

Pour bien comprendre, imaginons que la variance de u soit égale à la variance du nuage; on aurait alors trouvé une combinaison des Xn qui contient toute la diversité du nuage original (en tout cas toute la part de sa diversité captée par la variance).

Un critère couramment utilisé est la variance de l'échantillon (on veut maximiser la variance expliquée par le vecteur u). Pour les physiciens, cela a plutôt le sens de maximiser l'inertie expliquée par u (c'est-à-dire minimiser l'inertie du nuage autour de u).

Projection

Finalement, nous cherchons le vecteur u tel que la projection du nuage sur u ait une variance maximale. La projection de l'échantillon des X sur u s'écrit :

la variance empirique de πu(M) vaut donc :

où C est la matrice de covariance.

Comme nous avons vu plus haut que C est diagonalisable dans une base orthonormée, notons P le changement de base associé et Δ la matrice diagonale formée de son spectre :

Après cette réécriture, nous cherchons le vecteur unitaire v qui maximise vTΔv, où

est diagonale (rangeons les valeurs de la diagonale de Δ en ordre décroissant). On peut rapidement vérifier qu'il suffit de prendre le premier vecteur unitaire ; on a alors :

est diagonale (rangeons les valeurs de la diagonale de Δ en ordre décroissant). On peut rapidement vérifier qu'il suffit de prendre le premier vecteur unitaire ; on a alors :Plus formellement, on démontre ce résultat en maximisant la variance empirique des données projetées sur u sous la contrainte que u soit de norme 1 (par un Multiplicateur de Lagrange α) :

On obtient ainsi les deux résultats suivants:

- u est vecteur propre de C associé à la valeur propre λ1

- u est de norme 1

La valeur propre λ1 est la variance empirique sur le premier axe de l'ACP.

On continue la recherche du deuxième axe de projection w sur le même principe en imposant qu'il soit orthogonal à u.

Diagonalisation

La diagonalisation de la matrice de corrélation (ou de covariance si on se place dans un modèle non réduit), nous a permis d'écrire que le vecteur qui explique le plus d'inertie du nuage est le premier vecteur propre. De même le deuxième vecteur qui explique la plus grande part de l'inertie restante est le deuxième vecteur propre, etc.

Nous avons vu en outre que la variance expliquée par le k-ième vecteur propre vaut λk.

Finalement, la question de l'ACP se ramène à un problème de diagonalisation de la matrice de corrélation.

Optimisation numérique

Numériquement, la matrice M étant rectangulaire, il peut être plus économique de la décomposer en valeurs singulières, puis de recombiner la décomposition obtenue, plutôt que de diagonaliser M' M.

Résultats théoriques

Si les sections précédentes ont travaillé sur un échantillon issu de la loi conjointe suivie par X1, …, XN, que dire de la validité de nos conclusions sur n'importe quel autre échantillon issu de la même loi ?

Plusieurs résultats théoriques permettent de répondre au moins partiellement à cette question, essentiellement en se positionnant par rapport à une distribution gaussienne comme référence.

Applications

Compression

L'Analyse en Composantes Principales est usuellement utilisée comme outil de compression linéaire. Le principe est alors de ne retenir que les n premiers vecteurs propres issus de le diagonalisation de la matrice de corrélation (ou covariance), lorsque l'inertie du nuage projeté sur ces n vecteurs représente qn pourcents de l'inertie du nuage original, on dit qu'on a un taux de compression de 1 - qn pourcents, ou que l'on a compressé à qn pourcents. Un taux de compression usuel est de 20 %.

Les autres méthodes de compressions statistiques habituelles sont:

- l'analyse en composantes indépendantes ;

- les cartes auto-adaptatives (SOM, self organizing maps en anglais) ; appelées aussi cartes de Kohonen ;

- l'Analyse en composantes curvilignes ;

- la compression par ondelettes.

Il est possible d'utiliser le résultat d'une ACP pour construire une classification statistique des variables aléatoires X1, …, XN, en utilisant la distance suivante (Cn, n' est la corrélation entre Xn et Xn' ):

Analyse de séries dynamiques d'images

L'ACP, désignée en général dans le milieu du traitement du signal et de l'analyse d'images plutôt sous son nom de Transformée de Karhunen-Loève (TKL) est utilisée pour analyser les séries dynamiques d'images[3], c'est-à-dire une succession d'images représentant la cartographie d'une grandeur physique, comme les scintigraphies dynamiques en médecine nucléaire, qui permettent d'observer par gamma-caméra le fonctionnement d'organes comme le coeur ou les reins.

Dans une série de P images, chaque pixel est considéré comme un point d'un espace affine de dimension P dont les coordonnées sont la valeur du pixel pour chacune des P images au cours du temps. Le nuage ainsi formé par tous les points de l'image peut être analysé par l'ACP, (il forme un hyper-ellipsoïde à P dimensions) ce qui permet de déterminer ses axes principaux.

En exprimant tous les points dans le repère orthogonal à P dimensions des axes de l'ACP, on passe ainsi de la série temporelle d'origine (les pixels représentent la valeur en fonction du temps) à une nouvelle série (également de P images) dans l'espace de Karhunen-Loève : c'est la Transformée de Karhunen-Loève, qui est une opération réversible : on parle de "TKL" et de "TKL inverse" ou "TLK-1".

La compression est possible car l'information est contenue presque entièrement sur les premiers axes de l'ACP. Mais la notion de "compression" sous-entend que les autres images correspondant aux autres axes sont volontairement ignorées. La TKL étant réversible, la suppression arbitraire des axes les moins énergétiques constitue alors un filtrage permettant de réduire le bruit temporel de la série d'images.

Concrètement, l'application de TKL + suppression des axes les moins significatifs + TKL-1 permet de supprimer le fourmillement apparent (bruit temporel) d'une série animée d'images.

En imagerie médicale fonctionnelle, on améliore ainsi la qualité visuelle de la visualisation scintigraphique du cycle cardiaque moyen.

Par ailleurs, l'analyse de l'importance respective des valeurs propres de l'ACP permet d'approcher le nombre de fonctionnements physiologiques différents. On a ainsi pu montrer que le coeur sain peut être entièrement représenté avec 2 images (2 axes de l'ACP contiennent toute l'information utile), alors que pour certaines pathologies l'information utile s'étale sur 3 images[4].

Analyse d'images multi-spectrales

Comme pour l'application précédente, la longueur d'onde remplaçant juste le temps, la TKL a été proposée à plusieurs reprises pour extraire l'information utile d'une série d'images monochromes représentant les intensités pour des longueurs d'ondes différentes. De telles images peuvent être issues de microscopie optique classique, confocale ou SNOM (Microscope optique en champ proche)[5].

Evolution de la topographie

De la même manière, la TKL permet de mettre en évidence des cinétiques différentes lors de l'analyse topographique dynamique, c'est-à-dire l'analyse de l'évolution du relief au cours du temps. Elle permet alors de déceler des phénomènes invisibles par simple observation visuelle, mais se distinguant par une cinétique légèrement différente (par exemple pollution d'une surface rugueuse par un dépôt)[6].

Notes

- (en) Pearson, K., « On Lines and Planes of Closest Fit to Systems of Points in Space », dans Philosophical Magazine, vol. 2, no 6, 1901, p. 559–572 [texte intégral [PDF]]

- Analysis of a Complex of Statistical Variables with Principal Components",1933, Journal of Educational Psychology

- Évaluation de la perfusion et de la fonction contractile du myocarde à l’aide de l’analyse de Karhunen-Loève en tomographie d’émission monophotonique myocardique synchronisée à l’ECG par P. Berthout, R. Sabbah, L. Comas, J. Verdenet, O. Blagosklonov, J.C. Cardot et M. Baud dans Médecine Nucléaire Volume 31, Volume 12, Décembre 2007, Pages 638-646

- Baud, Cardot, Verdenet et al, Service de médecine nucléaire, Hôpital Jean-Minjoz, boulevard Fleming, 25030 Besançon cedex, France (nombreuses publications sur plus de 30 ans)

- Analysis of optical near-field images by Karhunen—Loève transformation Daniel Charraut, Daniel Courjon, Claudine Bainier, and Laurent Moulinier, Applied Optics, Vol. 35, Issue 20, pp. 3853-3861 (1996)

- (en) Jean-Yves Catherin, Measure in 2D, visualise in 3D and understand in 4D dans Micronora Informations Juin 2008, page 3

Voir aussi

- Valeurs propres

- Compression statistique

- Équilibre biais / variance

- Analyse de la variance

- Partitionnement de données

- Exploration de données

- Iconographie des corrélations

- Michel Loève

- Kari Karhunen

- Théorème de Karhunen-Loève (en)

Références

- Jean-Paul Benzécri ; Analyse des données. T2 (leçons sur l'analyse factorielle et la reconnaissance des formes et travaux du Laboratoire de statistique de l'Université de Paris 6. T. 2 : l'analyse des correspondances), Dunod Paris Bruxelles Montréal, 1973

- Jean-Paul Benzécri et Al. Pratique de l'analyse des données. T1 (analyse des correspondances. Exposé élémentaire), Dunod Paris, 1984,

- Jean-Paul Benzécri et Al. Pratique de l'analyse des données. T2 (abrégé théorique. Études de cas modèle), Dunod Paris, 1984

- Escofier Brigitte, Pagès Jérôme ; Analyse factorielles simples et multiples. Objectifs, méthodes et interprétation, Dunod Paris, 1988

- Husson François, Lê Sébastien, Pagès Jérôme ; Analyse de données avec R, Presses universitaires de Rennes, 2009

- Lebart Ludovic, Morineau Alain, Piron Marie; Statistique exploratoire multidimensionnelle, Dunod Paris, 1995

- Michel Volle, Analyse des données, Economica, 4e édition, 1997, ISBN 2-7178-3212-2

- Portail des probabilités et des statistiques

Wikimedia Foundation. 2010.