- Densité jointe

-

Loi de probabilité à plusieurs variables

Dans certains problèmes interviennent simultanément plusieurs variables aléatoires. Mis à part les cas particuliers de variables indépendantes (notion définie ci-dessous) et de variables liées fonctionnellement, cela introduit la notion de loi de probabilité à plusieurs variables autrement appelée loi jointe. La description des notions correspondantes, certaines d'entre elles généralisant les notions relatives à une seule variable, est simplifiée de deux manières:

- Seules les variables continues sont considérées. Il est possible de passer aux variables discrètes en utilisant la fonction de Heaviside et la fonction de Dirac.

- Pour éviter la lourdeur des formules, l'exposé est limité à deux variables.

Sommaire

Formules de base

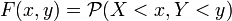

La probabilité pour que la variable aléatoire

prenne une valeur numérique inférieure à

prenne une valeur numérique inférieure à  alors que

alors que  prend une valeur inférieure à

prend une valeur inférieure à  définit la fonction de répartition :

définit la fonction de répartition :

Celle-ci est non décroissante en

et en

et en  entre la valeur 0 lorsque les deux variables tendent vers

entre la valeur 0 lorsque les deux variables tendent vers  et la valeur 1 lorsqu'elles tendent toutes deux vers

et la valeur 1 lorsqu'elles tendent toutes deux vers  .

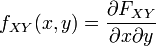

.La densité de probabilité jointe ou loi jointe s'obtient par une double dérivation :

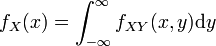

Une intégration par rapport à

(resp.

(resp.  ) donne la densité de probabilité marginale ou loi marginale de

) donne la densité de probabilité marginale ou loi marginale de  (resp.

(resp.  ) :

) :

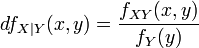

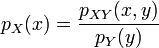

Le rapport de la densité de probabilité jointe (relative à une valeur

) à la densité marginale de

) à la densité marginale de  (concernant toutes les valeurs

(concernant toutes les valeurs  ) représente la densité de probabilité conditionnelle de

) représente la densité de probabilité conditionnelle de  sous la condition

sous la condition  :

:

Espérances mathématiques

L'espérance mathématique d'une fonction

de deux variables généralise la formule donnée pour une seule variable :

de deux variables généralise la formule donnée pour une seule variable :![\mathbb{E}[f(X,Y)] = \int_{-\infty}^\infty \int_{-\infty}^\infty\ f(x,y) p_{XY}(x,y) \mathrm dx \mathrm dy](/pictures/frwiki/53/582eeedf1486eec12d3ff9215d45ab59.png)

L'opérateur espérance est linéaire ; en particulier, l'espérance (la moyenne) d'une somme de deux variables aléatoires est la somme des moyennes :

![\mathbb{E}[X + Y] = \mathbb{E}[X] + \mathbb{E}[Y]\,](/pictures/frwiki/101/e768de1d186e115b8e33e8c4e7980d17.png)

Parmi ces espérances, une double transformation de Fourier conduit à la fonction caractéristique:

![\varphi_{XY} (\theta,\psi) = \mathbb{E}[e^{i(\theta X + \psi Y)}]](/pictures/frwiki/50/2435062f40fef8a190ebd6659d33c3a2.png)

Comme pour le cas d'une seule variable aléatoire un développement en série permet de faire apparaître les moments que l'on peut centrer par soustraction des moyennes.

Indépendance

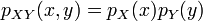

Si la densité de probabilité conditionnelle de

par rapport à

par rapport à  est identique à la densité marginale :

est identique à la densité marginale :

on dit que les deux variables sont indépendantes. L'égalité se réécrit :

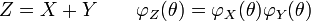

La fonction caractéristique de la somme des variables est alors égale au produit des fonctions caractéristiques individuelles :

C'est l'une des principales propriétés de la fonction caractéristique. Cette remarque est, entre autres, utilisée dans la démonstration du théorème de la limite centrale.

Corrélation

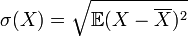

On appelle corrélation de deux variables aléatoires la grandeur:

![\rho=\frac{\mathbb{E}[(X-\overline X) (Y -\overline Y)]}{\sigma(X)\sigma(Y)}](/pictures/frwiki/57/95ad6c9b23a0f14fd107f3dc33c2f800.png)

où

est la variance. La corrélation de deux variables est comprises entre -1 et 1. Pour une corrélation proche de 1 la variable X aura tendance à être grande quand Y le sera et vice versa. Pour une corrélation proche de -1 la variable X aura tendance à être petite quand Y le sera grande. Si la covariance est nulle on dit que les deux variables sont décorrélées. La formule se développe alors en:

est la variance. La corrélation de deux variables est comprises entre -1 et 1. Pour une corrélation proche de 1 la variable X aura tendance à être grande quand Y le sera et vice versa. Pour une corrélation proche de -1 la variable X aura tendance à être petite quand Y le sera grande. Si la covariance est nulle on dit que les deux variables sont décorrélées. La formule se développe alors en:![E[XY] = E[X] E[Y]\,](/pictures/frwiki/98/bd8ce6a147111fa246c5cce0f77a9697.png)

Si les deux variables sont indépendantes, elles sont décorrélées, l'inverse n'étant pas vrai, car l'indépendance implique tous les moments au lieu d'un seul. La notion de variables décorrélées est plus faible que celle d'indépendance et est loin d'avoir la même utilité.

- Portail des probabilités et des statistiques

Catégorie : Probabilités

Wikimedia Foundation. 2010.