- Loi Normale Multidimensionnelle

-

Loi normale multidimensionnelle

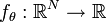

Distribution normale multidimensionnelle Densité de probabilité / Fonction de masse Fonction de répartition Paramètres ![\mu = [\mu_1, \dots, \mu_N]^\top](/pictures/frwiki/99/c4117161cbd483a9f60c55f017c34205.png) moyenne (vecteur réel)

moyenne (vecteur réel)

Σ matrice de variance-covariance (matrice définie positive réelle )

)Support

Densité de probabilité (fonction de masse)

Fonction de répartition Espérance μ Médiane (centre) μ Mode μ Variance Σ Asymétrie (statistique) 0 Kurtosis (non-normalisé) Entropie

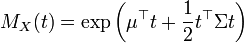

Fonction génératrice des moments

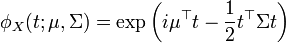

Fonction caractéristique

On appelle loi normale multidimensionnelle, ou loi multinormale ou loi de Gauss à plusieurs variables, une loi de probabilité qui est la généralisation multidimensionnelle de la loi normale.

Alors que la loi normale classique est paramétrée par un scalaire μ correspondant à sa moyenne et un second scalaire σ2 correspondant à sa variance, la loi multinormale est paramétrée par un vecteur

de

de  représentant son centre et une matrice semi-définie positive

représentant son centre et une matrice semi-définie positive  de

de  qui est sa matrice de variance-covariance.

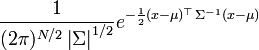

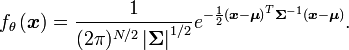

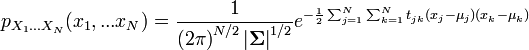

qui est sa matrice de variance-covariance.Dans le cas non dégénéré où Σ est définie positive, donc inversible, la loi normale multidimensionnelle admet une densité de probabilité

définie de la manière suivante :

définie de la manière suivante :pour un vecteur

de

de  , en notant

, en notant  et

et  le déterminant de

le déterminant de  :

:

Cette loi est habituellement notée

par analogie avec la loi normale unidimensionnelle.

par analogie avec la loi normale unidimensionnelle.Sommaire

Loi non dégénérée

Cette section s'intéresse à la construction de la loi normale multidimensionnelle dans le cas non dégénéré où la matrice de variance-covariance Σ est définie positive.

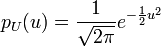

Rappel sur la loi normale unidimensionnelle

Le théorème de la limite centrale fait apparaître une variable

de Gauss centrée réduite (moyenne nulle, variance unité) :

de Gauss centrée réduite (moyenne nulle, variance unité) :![E[U] = 0 \qquad E[U^2] = 1](/pictures/frwiki/48/0ce2d3bc7cd55f58182415105479f9fa.png)

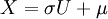

On passe à la variable de Gauss générale par le changement de variable

qui conduit à

![E[X] = \mu \qquad E[(X-\mu)^2] = \sigma^2](/pictures/frwiki/56/81a423246fda5e1ad0bafc217b5ed044.png)

Cette loi est caractérisée par une exponentielle comportant un exposant du second degré.

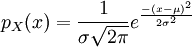

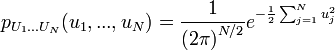

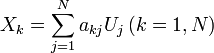

Loi unitaire à plusieurs variables

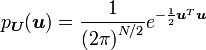

Étant données N variables aléatoires indépendantes de même loi de Gauss centrée réduite, leur densité de probabilité jointe s'écrit :

C'est la loi qui est à la base de la loi du χ².

Elle peut être synthétisée dans des formules matricielles. On définit d'abord le vecteur aléatoire

qui a pour composantes les N variables et le vecteur d'état

qui a pour composantes les N variables et le vecteur d'état  qui a pour composantes leurs valeurs numériques.

qui a pour composantes leurs valeurs numériques.On peut associer au vecteur d'état le vecteur moyenne qui a pour composantes les moyennes des composantes, c'est-à-dire, dans ce cas, le vecteur nul :

![E[\boldsymbol{U}] = \boldsymbol{0}\,](/pictures/frwiki/53/54ec09e55712226098dbb741ef27a418.png)

La matrice de covariance possède des éléments diagonaux (les variances) qui sont égaux à 1 tandis que les éléments non diagonaux (les covariances au sens strict) sont nuls : c'est la matrice unité. Elle peut s'écrire en utilisant la transposition :

![E[\boldsymbol{U} \boldsymbol{U}^T] = \boldsymbol{I}\,](/pictures/frwiki/57/9fa073e1d1a6700e6e064b8beaef5537.png)

Enfin, la densité de probabilité s'écrit :

Loi générale à plusieurs variables

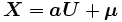

Elle s'obtient à partir d'un changement de variable linéaire

Le problème sera limité au cas d'une matrice

carrée (même nombre de variables en sortie) et régulière. L'opérateur espérance vectoriel étant linéaire, on obtient le vecteur moyen

carrée (même nombre de variables en sortie) et régulière. L'opérateur espérance vectoriel étant linéaire, on obtient le vecteur moyen![E[\boldsymbol{X}] = \boldsymbol{a} E[\boldsymbol{U}] + \boldsymbol{\mu} = \boldsymbol{\mu}\,](/pictures/frwiki/56/8e1d805fae327ac1bd5245b1f612a699.png)

et la matrice de covariance

![E[\boldsymbol{(X-\mu)} \boldsymbol{(X-\mu)}^T] = E[\boldsymbol{a} \boldsymbol{U} \boldsymbol{U}^T \boldsymbol{a}^T] = \boldsymbol{a}\boldsymbol{a}^T= \boldsymbol{\Sigma}\,](/pictures/frwiki/99/c7280b8b1d72036530ded212d1def124.png)

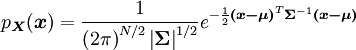

La densité de probabilité s'écrit

Remarques diverses

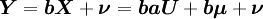

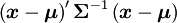

- Un nouveau changement de variables linéaire appliqué à

aboutit à une densité de probabilité qui a la même forme mathématique :

aboutit à une densité de probabilité qui a la même forme mathématique :

- Les formules essentielles, obtenues commodément à partir du calcul matriciel, se traduisent en termes scalaires :

les

étant les coefficients de l'inverse de la matrice de covariance.

étant les coefficients de l'inverse de la matrice de covariance.- L'exposant dans la formule qui précède est du second degré par rapport à toutes les variables. On vérifie qu'une intégration par rapport à l'une d'entre elles donne un résultat analogue. (N-1) intégrations successives aboutissent à une loi de probabilité marginale munie d'un exposant quadratique : chaque variable est gaussienne, ce qui n'était pas évident a priori.

- En combinant les remarques précédentes, on aboutit au résultat selon lequel toute combinaison linéaire des composantes d'un vecteur gaussien est une variable gaussienne.

- Dans cette loi de probabilité jointe, à tout couple de variables décorrélées correspond une matrice de covariance diagonale, ce qui assure leur indépendance. En effet, le couple est lui-même gaussien, et sa densité jointe est le produit des densités de ses deux composantes.

- Le terme présent dans l'exponentielle

est le carré de la distance de Mahalanobis.

est le carré de la distance de Mahalanobis.

Distributions conditionnelles

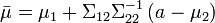

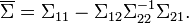

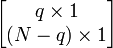

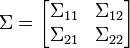

Si μ et Σ sont partitionnées comme décrit ci-dessous

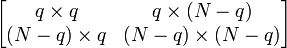

avec les dimensions

avec les dimensions

avec les dimensions

avec les dimensions

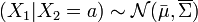

alors la distribution de x1 conditionnellement à x2 = a est une loi normale multidimensionnelle

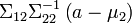

où

oùet la matrice de variance-covariance s'écrit

Cette matrice est le complément de Schur de

dans

dans  .

.On remarquera que savoir que x2 vaut a change la variance mais que, de manière plus surprenante, la moyenne est aussi modifiée et ce par un décalage de

. Cela est à comparer avec la situation dans laquelle on ne connait pas a, au quel cas x1 a pour distribution

. Cela est à comparer avec la situation dans laquelle on ne connait pas a, au quel cas x1 a pour distribution  .

.La matrice

est appelée matrice des coefficients de régression.

est appelée matrice des coefficients de régression.Propriétés

- Les iso-contours d'une loi normale multidimensionnelle non singulière sont des ellipsoïdes centrés sur la moyenne μ. Les directions des axes principaux de ces ellipsoïdes sont les vecteurs propres de Σ. Les carrés des longueurs relatives de ces axes sont donnés par les valeurs propres associées à ces vecteurs propres.

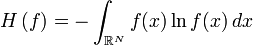

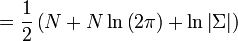

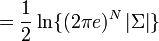

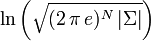

- L'entropie différentielle de la loi normale multidimensionnelle est donnée par [1]

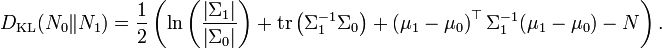

- La divergence de Kullback-Leibler prend une forme particulière dans le cas de deux lois normales multidimensionnelles

et

et

Applications

La loi normale multidimensionnelle est notamment utilisée dans le traitement d'images médicales. Ainsi elle est par exemple fréquemment utilisée dans l'imagerie du tenseur de diffusion. Cette imagerie modélise en effet la distribution des principales directions de diffusion de l'eau par une loi normale multidimensionnelle de moyenne nulle. Ainsi le tenseur en chaque point de l'image n'est autre que la matrice de covariance de la loi normale multidimensionnelle.

Une seconde application de la loi normale multidimensionnelle est la détermination, à partir des intensités dans des IRM du cerveau d'un patient, des différentes classes de tissus ( matière grise, matière blanche, liquide céphalo-rachidien) qui le composent. Cette technique est basée sur l'utilisation d'un algorithme espérance-maximisation dans lequel chacune des classes est modélisée par une loi normale multidimensionnelle dont la dimension est égale aux nombre de modalités utilisées pour la classification.

Notes et références

- ↑ « Entropy Expressions and Their Estimators for Multivariate Distributions », dans IEEE Transactions on Information Theory, vol. 35, no 3, May 1989, p. 688–692

Voir aussi

- Loi normale

- Loi de probabilité à plusieurs variables

- Algorithme espérance-maximisation: contenant le détail de l'application à la classification tissulaire

- Portail des probabilités et des statistiques

Catégories : Loi de probabilité | Probabilités - Un nouveau changement de variables linéaire appliqué à

Wikimedia Foundation. 2010.