- Théorème de gauss-markov

-

Théorème de Gauss-Markov

En statistiques, le théorème de Gauss–Markov, nommé ainsi d'après Carl Friedrich Gauss et Andrei Markov, énonce que dans un modèle linéaire dans lequel les erreurs ont une espérance nulle, sont non corrélées et dont les variances sont égales, le meilleur estimateur linéaire non biaisé des coefficients est l'estimateur des moindres carrés.

Plus généralement, le meilleur estimateur linéaire non biaisé d'une combinaison linéaire de variables aléatoires est son estimateur par les moindres carrés. On ne suppose pas que les erreurs possèdent une loi normale, ni qu'elles sont indépendantes (seulement non corrélées), ni qu'elles possèdent la même loi de probabilité.

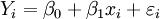

Plus explicitement, supposons que l'on ait :

Pour i = 1, . . ., n, où β0 et β1 sont des paramètres qui ne sont pas aléatoires mais non-observables, xi sont des observations, εi sont aléatoires, et donc Yi sont des variables aléatoires. Posons x en minuscule, s'agissant d'une observation ; et Y en majuscule car il s'agit d'une variable aléatoire. Les variables aléatoires εi sont appelées "erreurs".

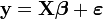

En pratique, il peut y avoir plus de deux variables explicatives (les x plus haut) et on a généralement recours à une écriture matricielle plus concise :

avec

et

et  de dimension n × 1,

de dimension n × 1,  de dimension k × 1, et enfin

de dimension k × 1, et enfin  de dimension n × k.

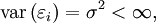

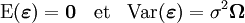

de dimension n × k.Le théorème de Gauss–Markov se base sur des hypothèses sur l'espérance et la matrice de variance-covariance des aléas :

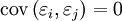

(c'est-à-dire que toutes les erreurs ont la même variance : on parle d'homoscédasticité) et

pour

; ce qui traduit la non-corrélation. Matriciellement, les hypothèses se traduisent ainsi :

; ce qui traduit la non-corrélation. Matriciellement, les hypothèses se traduisent ainsi :où la matrice

est la matrice identité n × n.

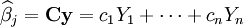

est la matrice identité n × n.Un estimateur linéaire de βj est une combinaison linéaire des données observées :

dans laquelle les coefficients ci ne dépendent pas des précédents coefficients βi, car ceux-ci ne sont pas observables, mais peuvent dépendre de xi, car il s'agit des observations.

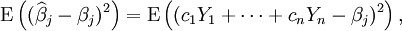

L'erreur moyenne quadratique d'un tel estimateur est :

c'est-à-dire, l'espérance du carré de la différence entre l'estimateur et les paramètres à estimer. L'erreur moyenne quadratique d'un estimateur coïncide avec sa variance si l'estimateur n'est pas biaisé ; dans le cas contraire, l'erreur moyenne quadratique est la somme de la variance et du carré du biais.

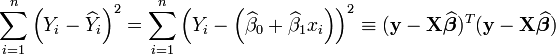

Le meilleur estimateur non-biaisé est l'estimateur de plus faible erreur moyenne quadratique (donc ici de plus faible variance). Les estimateurs par les moindres carrés de β0 et β1 sont les fonctions

et

et  de Ys et xs qui minimisent la somme des carrés des erreurs de mesure :

de Ys et xs qui minimisent la somme des carrés des erreurs de mesure :Ne pas confondre erreur sur des quantités non-observables et erreurs de mesure sur des grandeurs observables.

Le théorème de Gauss-Markov énonce que, parmi tous les estimateurs linéaires non-biaisés, l'estimateur par moindre carré est le seul à présenter une variance minimale. On peut résumer tout cela en disant que l'estimateur par moindre carré est BLUE[1] (en anglais : Best Linear Unbiaised Estimator).

En termes de formulation matricielle, la démonstration du théorème de Gauss–Markov est faite en démontrant que la différence entre la matrice de covariance de n'importe quel estimateur linéaire non biaisé et celle de l'estimateur des moindres carrés est une matrice semi-définie positive.

Notes et références

- ↑ A. C. Aitken, On Least Squares and Linear Combinations of Observations, Proceedings of the Royal Society of Edinburgh, 1935, vol. 55, pp. 42-48.

Voir aussi

- Portail des probabilités et des statistiques

Catégories : Estimation (statistique) | Carl Friedrich Gauss | Théorème de mathématiques

Wikimedia Foundation. 2010.