- Renormalisation

-

En théorie quantique des champs (ou QFT), en mécanique statistique des champs, dans la théorie des structures géométriques autosimilaires, une renormalisation se rapporte à un ensemble de techniques utilisées pour prendre la limite du continu.

Quand on décrit l'espace et le temps comme un continuum, certaines constructions statistiques et quantiques deviennent indéfinies. Pour les définir, il faut prendre des précautions pour passer à la limite.

La renormalisation détermine la façon de relier les paramètres de la théorie quand ces paramètres à grande échelle diffèrent de leur valeur à petite échelle. La renormalisation a été initialement développée en électrodynamique quantique (QED), en vue d'interpréter des intégrales divergentes de la théorie des perturbations. Au début, elle est considérée comme une procédure suspecte et provisoire par certains de ses auteurs. Finalement la renormalisation a été incorporée comme un outil important et logiquement cohérent dans plusieurs domaines de physique et de mathématiques.

L'idée majeure de la renormalisation est de corriger le lagrangien original d'une théorie quantique des champs par une série infinie de contre-termes, correspondant aux graphes de Feynman qui codent le développement perturbatif de la théorie. Dans la procédure de renormalisation perturbative, on introduit un contre-terme dans le lagrangien initial pour chaque divergence de graphe de Feynman. Dans certains cas, tous les contre-termes nécessaires peuvent être obtenus par modification des seuls paramètres du lagrangien initial. Il est alors possible de modifier ces paramètres, en les remplaçant par des séries de contre-termes divergents. Les paramètres initiaux ne sont pas observables, par opposition aux quantités physiques, qui sont finies, et observables. Un des problèmes de la procédure de renormalisation est le traitement systématique dans les graphes à plusieurs boucles des divergences liées à des boucles croisées ou incluses les unes dans les autres.

Auto-interactions en physique classique

Le problème des divergences est apparu tout d'abord en électrodynamique classique des particules ponctuelles aux XIXe et début du XXe siècles.

La masse d'une particule chargée doit inclure la masse-énergie de son champ électrostatique. Supposons que la particule soit une sphère chargée de rayon re. L'énergie de ce champ est, en posant c=1 et ε0=1 :

et elle devient infinie quand re → 0 , ce qui est évidemment absurde (puisque cela impliquerait que la particule ponctuelle ne pourrait pas être accélérée, en raison de sa masse infinie.

En passant, la valeur de re qui rend mem égal à la masse de l'électron est appelée le rayon classique de l'électron, et se trouve α fois la longueur d'onde de Compton de l'électron. En remettant tous les multiples de c et de ε0, on peut écrire :

La masse totale effective d'une particule chargée sphérique inclut – outre la masse calculée supra pour le champ électromagnétique – la masse nue de la particule chargée. Si on permet à cette dernière d'être négative, on peut envisager d'un passage cohérent à la limite ponctuelle. Ceci a été appelé renormalisation. Hendrik Lorentz et Max Abraham ont essayé de cette manière de mettre au point une théorie classique de l'électron. Ces travaux précoces ont inspiré des essais ultérieurs de régularisation en physique et la renormalisation en QFT.

Quand on calcule les interactions électromagnétiques de particules chargées, il est tentant d'ignorer la rétroaction du champ d'une particule sur elle-même. Mais cette rétroaction est nécessaire pour expliquer le ralentissement de particules chargées qui rayonnent. Si l'on suppose l'électron ponctuel, la valeur de la rétroaction diverge, pour la même raison que la masse diverge, parce que le champ se comporte comme le carré inverse de la distance.

La théorie d'Abraham et Lorentz impliquait une « préaccélération » non causale. Dans certaines configurations, un électron commençait à se déplacer avant que la force ne soit appliquée. Ceci signalait que la limite ponctuelle n'était pas cohérente. Un corps étendu ne commencera à bouger que quand une force est appliquée sur un point au plus à sa surface.

Le problème s'est trouvé pire en théorie classique des champs qu'en QFT, parce que dans cette dernière, à courte distance, une particule se trouve dans une position fluctuante, et on ne peut donc la localiser mieux que dans une région de l'ordre de la longueur d'onde de Compton[1]. En QED, à faible couplage, la masse électromagnétique ne diverge que comme le logarithme du rayon de la particule.

Certains physiciens pensent que quand la constante de structure fine est bien plus grande que l'unité, si bien que le rayon classique de l'électron est supérieur à la longueur d'onde de Compton, certains problèmes qui rendent la théorie classique incohérente reviennent en théorie quantique. En effet les problèmes de la théorie classique apparaissent à des distances de l'ordre du rayon classique, mais ils sont dilués par le principe d'incertitude sur une échelle plus grande, celle de la longueur d'onde de Compton. Si la constante de structure fine est plus grande que l'unité, alors c'est la situation inverse qui prévaut : les problèmes de la théorie classique peuvent se manifester avant d'être dilués par les fluctuations quantiques.

Divergences en électrodynamique quantique

Quand ils mettent au point l'électrodynamique quantique (QED), Max Born, Werner Heisenberg, Pascual Jordan, et Paul Dirac découvrent que beaucoup d'intégrales du calcul perturbatif divergent.

Une façon de décrire les divergences est découverte à ce moment-là par Ernst Stueckelberg, perfectionnée dans les années 1940 par Julian Schwinger, Richard Feynman, et Sin-Itiro Tomonaga, et finalement systématisée par Freeman Dyson. Les divergences apparaissent dans les calculs impliquant des diagrammes de Feynman comprenant des boucles fermées de particules virtuelles.

Bien que les particules virtuelles doivent obéir aux lois de conservation de l'énergie et de la quantité de mouvement, elles peuvent avoir n'importe quel quadri-moment (ou 4-moment), même si elles n'observent pas la relation entre énergie et quantité de mouvement de la relativité pour la masse de la particule donnée. Ceci veut dire que E² - p² peut être différent de m² – par exemple pour un photon cela peut être non-nul. Dans ce cas, la particule est dite « hors de sa couche de masse », ou tout simplement « hors couche ». Quand il y a une boucle, les 4-moments des particules participant à la boucle ne sont pas uniquement définis par ceux des particules incidentes et émergentes. On peut ajouter un 4-vecteur constant à tous les 4-moments des particules formant la boucle sans violer les conditions de conservation du 4-moment à chaque vertex de la boucle. Pour calculer le diagramme de Feynman, il faut intégrer sur toutes les possibilités de choix des 4-moments de la boucle.

Ces intégrales sont parfois divergentes, car la fonction à intégrer ne décroît pas assez vite pour des 4-moments très grands. On appelle ceci une divergence ultraviolette (UV). Ces divergences UV peuvent être interprétées indifféremment comme provenant

- de la région où tous les 4-moments des particules intermédiaires de la boucle sont très grands ;

- des très courtes longueurs d'onde et hautes fréquences des fluctuations des champs soumis à l'intégrale de chemin ;

- des intervalles d'espace-temps très courts entre les diverses émissions et absorption des particules participant à la boucle, si l'on considère la boucle comme une somme sur les chemins des particules.

On peut donc considérer ces divergences comme des phénomènes à très courtes distances dans l'espace-temps, ce qui nous renvoie à la divergence de l'électrodynamique classique.

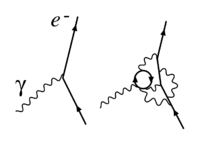

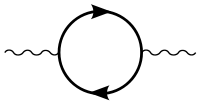

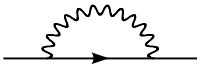

En QED, il y a exactement trois catégories de diagrammes divergents, illustrés sur les figures à l'ordre à une boucle :

- un électron émet des photons, puis un avec lequel il interagit avec un autre électron, et enfin réabsorbe les premiers photons émis. C'est la renormalisation de vertex (Fig. 2) ou (Fig. 1)

- un photon crée un ensemble de particules virtuelles : électron-positron et photons, qui se réannihilent en un photon. C'est la polarisation du vide (Fig. 3).

- un électron émet des particules virtuelles et les réabsorbe. C'est la self-interaction de l'électron (Fig. 4).

Ces trois divergences correspondent à trois paramètres de la théorie :

- la charge de l'électron

- la normalisation du champ du photon

- la masse de l'électron

Une autre classe de divergences, appelées divergences infrarouges, est due à la présence de particules de masse nulle, comme le photon en QED. Tout processus impliquant l'accélération de particules chargées se traduira par l'émission d'une onde de champ classique, qui comprend une infinité de photons cohérents de grande longueur d'onde. La probabilité d'en émettre un nombre fini est nulle.

En QED, ce processus est bien compris. Par exemple, à l'ordre à une boucle, la fonction de vertex (Fig. 2) a des divergences UV et IR. Contrairement à ce qui se passe pour la divergence UV, la divergence IR ne nécessite pas la renormalisation d'un paramètre de la théorie. On ne l'élimine pas directement de l'amplitude de diffusion, mais de la section efficace. On ajoute les contributions à cette section efficace du carré de l'amplitude, avec sa divergence IR, et celle du processus comparable, où le photon virtuel de la boucle est émis de façon réelle (il n'y a donc plus de boucle, mais une intégration sur les moments des photons réels). Ce calcul tient compte du processus de bremsstrahlung. Il n'y a pas de moyen physique de distinguer un photon d'énergie nulle circulant dans une boucle comme sur le diagramme de vertex, et un photon d'énergie nulle émis par bremsstrahlung. Donc seule la somme des deux sections efficaces revêt une signification physique, ce qui se traduit par l'élimination des divergences IR.

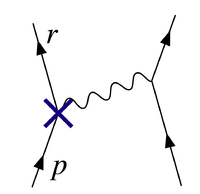

Une divergence de boucle

Le diagramme de la Fig. 2 présente une des contributions à une boucle à la diffusion électron-électron en QED. L'électron représenté à gauche de la figure par une ligne polygonale arrive avec un 4-moment pµ, et ressort avec un 4-moment rµ. Il commence par émettre un premier photon virtuel, de 4-moment qµ, puis un second de 4-moment pµ-rµ pour transférer du 4-moment à l'autre électron. Finalement, il réabsorbe le premier photon émis. À chaque interaction, le 4-moment total est conservé, mais cela ne définit pas la valeur de qµ, qui peut prendre n'importe quelle valeur. On en déduit la valeur du 4-moment de chaque particule virtuelle dans la boucle. Il faut donc envisager toutes les possibilités, et intégrer sur tout le 4-espace de qµ. Les règles de QED définissent la valeur de la fonction à intégrer : couplage de l'électron au photon, terme à insérer pour chacune des lignes de particules virtuelles (ou propagateur). Ce terme devient infini quand la particule virtuelle se trouve sur sa couche de masse, mais des prescriptions sont données pour interpréter l'intégrale en ces points.

L'amplitude relative à ce diagramme finit donc par s'écrire :

Les diverses matrices γµ qui apparaissent dans cette expression sont les mêmes que celles de l'équation de Dirac sous sa forme covariante ; elles sont reliées au spin de l'électron, et au fait que l'équation de Dirac décrit l'électron aussi bien que le positron, d'où leur dimension 4 × 4. Les trois facteurs -e sont les constantes de couplage électrique des trois sommets de la boucle. Les symboles iε donnent une interprétation symbolique de la manière dont l'intégration doit se faire pour les particules sur leur couche de masse. La partie la plus intéressante pour notre propos est la dépendance en q de l'intégrand pour les grandes valeurs de q.

Le numérateur a une puissance 2 des composantes de q, tandis que le dénominateur en a une de 6 (Pokorski 1987, p. 122). Le terme dominant est donc :

Comme on intègre sur un espace à 4 dimensions, l'intégrale diverge logarithmiquement, c'est-à-dire que si on limite les valeurs des composantes de q à une valeur Λ, l'intégrale se comporte comme log(Λ), ce qui tend vers l'infini quand Λ → ∞. Des divergences semblables se produisent dans d'autres théories des champs.

Grandeurs nues et grandeurs renormalisées

La solution a donc été de réaliser que les constantes initialement placées dans les formules de la théorie (comme par exemple l'expression du lagrangien), représentant formellement la charge électrique et la masse, ainsi que les normalisations des champs eux-mêmes, ne correspondent pas en réalité aux grandeurs physiques mesurées en laboratoire. Telles quelles, elles sont des grandeurs nues, qui ne prennent pas en compte la contribution des boucles de particules virtuelles aux grandeurs physiques mesurées. En particulier, ces effets incluent la contrepartie quantique des rétroactions électromagnétiques, qui avaient posé tant de problèmes au théoriciens de l'électromagnétisme classique. En général, ces effets sont juste aussi divergents que les amplitudes calculées. Il faut donc alors prendre des constantes nues divergentes pour obtenir des quantités mesurables finies.

Pour rendre compte de la réalité, alors, les formules doivent être réécrites en termes des quantités mesurables, renormalisées. La charge de l'électron, par exemple, doit être définie en termes d'une quantité mesurée dans des conditions cinématiques précises, le point de renormalisation, ou point de soustraction. Cette cinématique est en général caractérisée par une certaine énergie, appelée échelle de renormalisation. Les parties du lagrangien laissées de côté, qui impliquent des parties des quantités nues, peuvent alors être réinterprétées comme des contre-termes, qui, dans les diagrammes divergents, compensent exactement les divergences non-souhaitées de toutes les grandeurs calculées.

Renormalisation en QED

Par exemple, dans le lagrangien de l'électrodynamique quantique (QED),

![\mathcal{L}=\bar\psi_N\left[i\gamma_\mu (\partial^\mu + ie_NA_N^\mu)-m_N\right]\psi_N -\frac{1}{4}F_{N\,\mu\nu}F_N^{\mu\nu}](f/0efc3370807e6b5a3205e0bba4b9158e.png)

les champs ψN, AN, FN et la constante de couplage eN sont des grandeurs nues, d'où l'indice N. Par convention, les quantités nues sont écrites de façon à ce que les termes correspondants du lagrangien soient des multiples des termes renormalisés :

-

-

.

.

-

Fig. 5 – Le vertex correspondant au contre-terme en Z1 qui compense la divergence du diagramme de la Fig. 2

Fig. 5 – Le vertex correspondant au contre-terme en Z1 qui compense la divergence du diagramme de la Fig. 2

Il se trouve que l'invariance de jauge, par l'intermédiaire de l'identité de Ward-Takahashi, implique que l'on peut renormaliser ensemble par la même constante les deux termes de la dérivée covariante (au sens de la théorie de jauge)

, ce qui fait que l'on n'a besoin que de 3 constantes de renormalisation Zi alors que l'on a à renormaliser 4 grandeurs : Aµ, ψ, m et e. Fµν étant une combinaison de dérivées de Aµ se renormalise de la même façon que ce dernier.

, ce qui fait que l'on n'a besoin que de 3 constantes de renormalisation Zi alors que l'on a à renormaliser 4 grandeurs : Aµ, ψ, m et e. Fµν étant une combinaison de dérivées de Aµ se renormalise de la même façon que ce dernier.Un terme de ce lagrangien, par exemple, l'interaction électron-photon de la Fig. 2 peut alors s'écrire :

La constante physique -e, la charge de l'électron, peut alors être définie en termes de quelque expérience donnée ; nous posons l'échelle de renormalisation à l'énergie caractéristique de cette expérience, et le premier terme représente l'interaction que nous constatons au laboratoire (à quelques petites corrections finies, provenant de diagrammes de boucles fournissant des termes exotiques comme les corrections d'ordre plus haut au moment magnétique. Le reste est le contre-terme. Avec un peu de chance, les parties divergentes des diagrammes contenant des boucles peuvent tous être décomposés en parties avec deux ou trois lignes sortantes, sous une forme algébrique qui peut être compensée par des contre-termes provenant de Z0, Z3 ou Z1. En QED, la chance se concrétise : la théorie est renormalisable (voir infra).

Le diagramme avec le contre-terme de vertex en Z1, placé comme sur la Fig. 5 compense la divergence de la boucle de la Fig. 2.

La séparation des « termes nus » entre termes originaux et contre-termes a vu le jour avant l'invention du groupe de renormalisation due à Kenneth Wilson. Dans cette dernière optique, cette séparation n'a aucun caractère objectif, et est non-physique.

Variation des constantes

Pour minimiser la contribution des diagrammes de boucles à un calcul donné – et ainsi faciliter le calcul des grandeurs physiques – on choisit un point de renormalisation voisin des énergies et moments en jeu dans l'interaction que l'on veut calculer. Cependant, le point de renormalisation n'est pas lui-même une grandeur physique : les prédictions physiques de la théorie, si elles peuvent être calculées à tous les ordres, devraient en principe être indépendantes du choix de ce point, tant qu'il reste dans le domaine d'application de la théorie. Les changements d'échelle de renormalisation ne feront qu'affecter les contributions respectives des divers diagrammes de Feynman convenablement rendus finis par renormalisation. On peut exploiter ce phénomène pour calculer la variation des constantes physiques en fonction de l'échelle. Cette variation est dénotée par des fonctions β. La théorie générale de ce type de dépendance d'échelle est connue sous le nom de groupe de renormalisation.

En langage informel, les physiciens des particules parlent souvent de certaines constantes physiques qui dépendent de l'énergie de l'interaction, bien que la quantité indépendante soit en fait l'échelle de renormalisation. Cette variation décrit cependant une manière commode de décrire les changements du comportement de la théorie des champs selon les énergies impliquées dans les interactions. Par exemple, puisque la constante de couplage en QCD devient petite aux grandes énergies, la théorie se comporte de plus en plus comme une théorie de particules libres, au fur et à mesure que les énergies échangées dans les interactions deviennent grandes. Ce phénomène est appelé liberté asymptotique. En choisissant une échelle d'énergie croissante, et en utilisant le groupe de renormalisaton, on peut le constater sur des diagrammes de Feynman simples. Si on ne le faisait pas, la prédiction, identique, serait bien plus difficile à faire, car elle proviendrait de compensations compliquées entre diagrammes notamment d'ordre élevé.

Pour prendre un exemple simplifié à l'extrême : l'expression

est indéfinie. Pour éliminer les divergences, on peut soustraire le même contre-terme

est indéfinie. Pour éliminer les divergences, on peut soustraire le même contre-terme  de chacun des termes. On obtient alors l'expression finie

de chacun des termes. On obtient alors l'expression finie .

.On remarque qu'il aurait été bien plus commode de prendre tout de suite ε=b, ce qui aurait directement donné le résultat, le second terme s'annulant. Ce mécanisme est analogue au choix d'une échelle de renormalisation, où on n'a pas besoin de faire apparaître les compensations entre divers termes. Encore faut-il savoir que c'est la même valeur de ε qu'il faut prendre pour les deux termes. Ceci simule le rôle du groupe de renormalisation.

Régularisation

Puisque la quantité ∞ - ∞ est indéfinie, pour rendre précise la notion de compensations des divergences, il faut d'abord les maîtriser mathématiquement, en utilisant la théorie des limites, selon un procédé dénommé régularisation.

Une modification pour l'essentiel arbitraire des intégrands de boucle, que l'on appelle régulateur, peut les conduire à tendre vers zéro pour des grandes valeurs de l'intégrand, plus vite que dans leur état naturel. Un régulateur peut dépendre d'une échelle de 4-moment caractéristique, que l'on appelle la coupure, ou sous son nom anglais cut-off. Tous les diagrammes ont le même régulateur, et les contre-termes dépendent aussi du régulateur. Quand on fait disparaître le régulateur, par exemple, en faisant tendre la coupure vers l'infini, on retrouve les intégrales originales, mais on a regroupé les termes et les contre-termes de telle sorte que l'on trouve des résultats finis. Si le nombre de contre-termes de la théorie est fini, on obtient un résultat indépendant de la méthode de régularisation. La théorie est dite renormalisable.

On utilise un grand nombre de types de régulateurs pour les calculs de théorie quantique des champs, qui ont tous des avantages et des inconvénients. Un des plus populaires dans les usages modernes est la régularisation dimensionnelle, inventée par Gerardus 't Hooft et Martinus Veltman. Elle maîtrise la divergence des intégrales en intégrant dans un espace-temps à un nombre de dimensions fictif fractionnel, inférieur à 4, nombre dont on prend en fin de calcul la limite de 4. Une autre est la régularisation de Pauli-Villars, qui ajoute à la théorie des particules fictives de très grande masse, en sorte que les intégrales de boucles impliquant les particules massives compensent les intégrales de boucles normales, à des valeurs des 4-moment bien plus grandes que la très grande masse des particules fictives, qui joue donc le rôle de cut-off.

Un autre schéma de régularisation est la régularisation sur réseau, introduite par Kenneth Wilson. Elle consiste à prétendre que notre espace-temps est constitué d'un réseau cubique à 4 dimensions, dont le pas est constant. L'inverse de ce pas est un cut-off naturel pour les composantes du 4-moment d'une particule se déplaçant sur le réseau. Après un calcul sur divers pas de réseau, le résultat physique est extrapolé à un pas de réseau nul, ce qui redonne notre espace-temps continu, sous certaines conditions de régularité du passage à la limite.

Il existe une méthode mathématiquement rigoureuse de pratiquer la renormalisation, la théorie causale des perturbations (en) où l'on évite les divergences UV dans les calculs dès le début, en ne faisant que des opérations mathématiquement bien définies dans le cadre de la théorie des distributions. L'inconvénient de cette méthode réside dans son aspect très technique, qui demande un haut degré de connaissances mathématiques.

Régularisation par la fonction zêta

Julian Schwinger a découvert une relation entre la régularisation de la fonction ζ et la renormalisation, en utilisant la relation asymptotique :

quand le régulateur Λ → ∞. Sur cette base, il a envisagé d'utiliser les valeurs de ζ(-n) pour obtenir des résultats finis. Bien qu'il eût obtenu des résultats incohérents, une formule améliorée par Hartle, J. Garcia, E. Elizalde utilise :

,

,où les B sont les nombres de Bernoulli et

.

.Donc tout I(m,Λ) peut être écrit comme une combinaison linéaire de ζ(-1), ζ(-3), ζ(-5), ... , ζ(-m).

Ou encore, en utilisant la formule d'Abel-Plana, on a pour toutes les intégrales divergentes :

valable pour m > 0. Ici la fonction ζ est la fonction zêta de Hurwitz et β est un nombre réel positif.

Une analogie géométrique serait, si on utilise la méthode des rectangles pour évaluer l'intégrale de cette manière :

En utilisant la régularisation ζ de Hurwitz en conjonction avec la méthode des rectangles avec un pas h.

Attitudes et interprétation

Les premiers bâtisseurs de la QED et d'autres théories quantiques des champs étaient en général mécontents de la situation. Il paraissait illégitime de faire quelque chose qui ressemblait à soustraire des infinités d'autres infinités en vue d'obtenir des résultats finis.

La critique de Dirac a été la plus durable. Encore en 1975, il écrivait (Kragh, p. 184) :

« La plupart des physiciens se satisfont parfaitement de cette situation. Ils disent «la QED est une bonne théorie, et nous n'avons pas à nous en soucier plus que cela. » Je dois dire que je suis très mécontent de cette situation, parce ce qu'ils appellent une « bonne théorie » implique de négliger des infinités qui apparaissent dans ses équations, ce qui introduit une part d'arbitraire. Cela ne ressemble pas du tout à des mathématiques sensées. Les mathématiques sensées impliquent de négliger des quantités quand elles sont petites – pas de les négliger parce qu'elles sont infinies et que vous n'en voulez pas ! »

Un autre critique important était Feynman. Malgré son rôle crucial dans la mise au point de la QED, il écrit ceci, encore en 1985, (Feynman 1990, p. 128) :

« L'escroquerie que nous pratiquons ... est appelée techniquement renormalisation. Mais quelque subtil que soit le mot, c'est toujours ce que j'appellerais un processus dingue ! Le fait d'avoir à recourir à ce genre de prestidigitation nous a empêché de démontrer que la QED était logiquement cohérente mathématiquement. C'est surprenant que l'on n'ait pas encore réussi à montrer d'une manière ou d'une autre que la théorie est logiquement cohérente ; je soupçonne que la renormalisation n'est pas légitime mathématiquement. »

Alors que les critiques de Dirac s'adressent à la procédure de renormalisation elle-même, celles de Feynman sont très différentes. Il est attaché à ce que toutes les théories des champs connues dans les années 1960 aient la propriété que les interactions deviennent infinies à des échelles de distance suffisamment petites. Cette propriété, connue sous le nom de pôle de Landau, suggère que toutes les théories quantiques des champs sont incohérentes. En 1974, Gross, Politzer et Wilczek montrent qu'une autre théorie quantique des champs, la chromodynamique quantique (QCD), ne présente pas de pôle de Landau. Feynman, avec la plupart des autres, reconnurent que la QCD pouvait être une théorie complètement cohérente.

Le malaise général se faisait sentir de façon pratiquement universelle dans les textes jusqu'aux années 1970 et 1980. Cependant, inspirés par le travail sur le groupe de renormalisation et la théorie effective des champs, et malgré le fait que Dirac et divers autres – tous de la vieille génération – ne retiraient pas leurs critiques, les attitudes ont commencé à changer, en particulier chez les jeunes théoriciens.

Kenneth Wilson et autres démontrèrent que le groupe de renormalisation est utile en théorie des champs statistique appliquée à la physique de la matière condensée, où il donne une compréhension importante des transitions de phase. En physique de la matière condensée, il existe un régulateur à courte distance réel : la matière cesse d'être continue à l'échelle des atomes. Les divergences à courte distance ne présentent pas de problème philosophique pour la physique de la matière condensée, puisque la théorie des champs n'est de toute manière qu'une représentation effective, lissée, du comportement de la matière. Il n'y a pas d'infinités parce que le cut-off est en réalité toujours fini, et c'est tout à fait logique que les grandeurs nues dépendent du cut-off.

Si la théorie quantique des champs est vraie tout au long, jusqu'au delà de la longueur de Planck (où il faut peut-être la raccorder à la théorie des cordes, à la théorie des ensembles causals (en) ou à quelque chose de ce genre), alors il n'y a peut-être aucun problème réel avec les divergences à courte distance de la physique des particules : toutes les théories des champs sont peut-être des théories des champs effectives. Dans un certain sens, cette position répond à l'ancienne attitude de ce que les divergences des théories quantiques des champs reflètent l'ignorance des hommes sur le fonctionnement intime de la nature, mais reconnaît en même temps que cette ignorance peut être maîtrisée, et que les théories effectives qui en résultent restent utiles.

En théorie quantique des champs, la valeur d'une constante physique dépend en général de l'échelle choisie pour effectuer la renormalisation, et il devient très intéressant d'examiner le comportement de ces constantes par le groupe de renormalisation, sous l'effet d'un changement d'échelle de renormalisation. Les constantes de couplage du modèle standard de la physique des particules varient de façon différente en fonction de l'échelle : les couplages de la chromodynamique quantique et du couplage d'isospin faible de la force électrofaible tendent à diminuer, tandis que le couplage de l'hypercharge faible de la théorie électrofaible tend à diminuer quand l'échelle de renormalisation augmente. À l'échelle colossale de 1015 GeV (bien au-delà des possibilités envisageables pour des accélérateurs de particules), elles deviennent toutes du même ordre de grandeur. Ceci est une motivation majeure pour les spéculations sur la théorie de grande unification. Au lieu d'être un problème insatisfaisant, la renormalisation est devenue un outil important pour étudier le comportement des théories des champs sous différents régimes.

Si une théorie comprenant une renormalisation (par ex. la QED) ne peut être raisonnablement interprétée que comme une théorie des champs effective, c'est-à-dire que comme une approximation reflétant notre ignorance sur le fonctionnement intime de la nature, alors il reste à trouver une théorie plus précise qui ne présente pas ces problèmes. Comme l'exprime Lewis Ryder, « En théorie quantique, ces divergences (classiques) ne disparaissent pas ; au contraire elles apparaissent pires. Et malgré le succès relatif de la théorie de la renormalisation, il reste un sentiment qu'il devrait y avoir une manière plus satisfaisante de gérer le problème » (Ryder 1996, p. 390).

Renormalisabilité

De toute cette réévaluation philosophique, un nouveau concept émerge naturellement : la notion de renormalisabilité. Toutes les théories ne se prêtent pas à la renormalisation selon le schéma esquissé précédemment, avec un nombre fini de contre-termes, et toutes les quantités devenant indépendantes du cut-off à la fin du calcul. Si le lagrangien contient des combinaisons d'opérateurs de champ de dimensions trop élevées en unités d'énergie, alors les contre-termes prolifèrent jusqu'à l'infini, et à première vue, la théorie semble dépendre d'un nombre infini de paramètres libres, et par suite perdre tout pouvoir prédictif, devenant inutilisable. Ce genre de théories sont appelées non-renormalisables.

Le modèle standard de la physique des particules ne contient que des opérateurs renormalisables, mais les interactions de la relativité générale deviennent non-renormalisables, si l'on essaie de construire une théorie de la gravitation quantique de la façon la plus évidente. Ceci suggère que la théorie des perturbations ne peut pas être appliquée à la gravitation quantique.

Cependant, dans une théorie effective des champs, la renormalisabilité est un terme impropre. Dans une théorie effective des champs non renormalisable, les termes du lagrangien se multiplient jusqu'à l'infini, mais voient leurs coefficients divisés par des puissances croissantes du cut-off en énergie. Si ce cut-off est une quantité physique réelle – c'est-à-dire si la théorie n'est une description effective de la physique que jusqu'à une énergie maximale, ou une distance minimale – alors ces termes peuvent représenter des interactions physiques réelles. En supposant que les constantes sans dimension de la théorie ne deviennent pas trop grandes, on peut regrouper les calculs par puissances inverses du cut-off et extraire des prédictions approchées à un ordre fini dans le cut-off, qui dépendent encore d'un nombre fini de paramètres libres. Il peut même être utile de renormaliser ces interactions non-renormalisables.

Les interactions non-renormalisables des théories des champs effectives deviennent rapidement plus faibles quand l'échelle d'énergie dépasse le cut-off. L'exemple classique est la théorie de Fermi de l'interaction faible, une théorie effective non-renormalisable, dont le cut-off est de l'ordre de la masse du boson W. Ce fait peut aussi donner une explication possible pourquoi presque toutes les interactions peuvent être décrites par des théories renormalisables. Il peut se faire que celles qui existent à d'autres échelles (GUT ou Planck) deviennent tout simplement trop faibles pour être détectées dans le domaine que nous observons, avec une exception : la gravitation, dont l'interaction excessivement faible est compensée par la présence des énormes masses des étoiles et planètes.

Schémas de renormalisation

Dans les calculs réels, les contre-termes introduits pour compenser les divergences des diagrammes de Feynman comportant des boucles doivent être définis en utilisant un ensemble de conditions de renormalisation. Les schémas de renormalisation, qui fixent ces conditions, les plus utilisés comprennent :

- Le schéma de soustraction minimal (MS), et les schémas apparentés de soustraction minimale modifiés (MS-bar)

- Le schéma sur couche

Applications à la physique statistique

Systèmes purs, renormalisation à la Wilson

Principe

En physique statistique des systèmes purs (ex., couplages bien déterminés entre les spins d'un réseau hypercubique), la renormalisation se rencontre dans l'étude des phénomènes critiques. À l'approche du point critique, la longueur de corrélation diverge. Comme on s'intéresse aux propriétés macroscopiques du corps, il est naturel de se concentrer sur les propriétés du système à des échelles l telles que la maille du réseau a ≪ l ≪ (longueur de corrélation).

Puisqu'on ne s'intéresse pas à ce qui se passe à des échelles plus petites que l, il est naturel de tenter de se ramener à un système présentant les mêmes propriétés à grandes distances, où l'on néglige les fluctuations plus petites que l, et de le comparer au précédent.

On ne passe pas directement de la petite échelle a à la grande échelle l, mais on décompose la démarche en plusieurs étapes appelées « itérations ». À chacune on moyenne (intègre) les fluctuations à courte échelle, obtenant ainsi un système plus simple (puisqu'on a moyenné les fluctuations à courte échelle, on n'en a plus le détail), mais aussi plus grand. On ramène alors le nouveau système à la taille du système initial à l'aide d'un changement d'échelle en s'arrangeant pour qu'il laisse invariante la forme du hamiltonien (qui peut être vu comme les quantités Pi lors d'un changement d'échelle en hydrodynamique), mais avec de nouvelles valeur des couplages (comme en hydrodynamique les nombres Pi sont inchangés, mais la vitesse par exemple doit être plus grande). Au cours de la renormalisation certains paramètres augmentent, d'autres diminuent.

Dans l'espace réel

Dans l'espace réel, on commence par opérer une décimation. Cette opération consiste à regrouper les éléments du système en petits groupes (par exemple dans une chaîne comportant un nombre pair de spins, on regroupe le premier avec le second, le troisième avec le quatrième etc.). Plusieurs décimations sont possibles. L'ordre de grandeur des blocs est de l'ordre de la maille du réseau a. Ensuite, il s'agit d'intégrer les fluctuations sur chaque bloc. Concrètement on moyenne sur chaque bloc soit en faisant une moyenne arithmétique soit en se donnant une règle raisonnable. À chaque bloc on affecte un spin ayant cette moyenne comme valeur (certains auteurs l'appellent superspin, pour montrer que c'est un spin fictif qu'on associe à un bloc). Le réseau des blocs est néanmoins plus espacé que le réseau d'origine. On effectue ensuite un changement d'échelle en veillant à ce que les propriétés à grande distance de la maquette ainsi obtenue soient les mêmes que celle du réseau d'origine. Ceci est obtenu en multipliant les couplages par un facteur d'échelle de façon à ce que la mesure (de Boltzmann) de chaque configuration soit la même que celle associée au système de départ. Si on peut faire cela c'est que la théorie est renormalisable. Pourquoi avoir fait tout cela ? La maquette obtenue possède les mêmes propriétés à grande distance que le système d'origine, mais au contraire de celui-ci, ignore le détail des fluctuations aux petites distances (puisqu'on a moyenné à l'échelle des blocs). On obtient ainsi un système présentant la même physique à grande distance, mais plus simple, et ses couplages s'expriment en fonction des couplages d'origine et de facteurs d'échelle. Le résultat peut être vu comme un modèle plus simple qui capture toute la physique intéressante. Ceci est donc utile au voisinage des points critiques où la longueur de corrélation diverge, et où on s'intéresse par conséquent aux propriétés à grande distance. En itérant cette transformation, on se ramène à des systèmes de plus en plus essentiels. L'évolution des paramètres au cours de la renormalisation fait apparaître les paramètres essentiels.

Pour des dimensions spatiales fractionnaires juste inférieures à 4, les méthodes évoquées ci-dessus peuvent même être renforcées (c'est-à-dire que l'on a une super-renormalisabilité au lieu d'une simple renormalisabilité). Ceci permet une extrapolation à la vraie dimension spatiale de 3 pour les transitions de phase. Voir (Zinn-Justin 2002) pour les détails.

Le Prix Nobel de physique 1982 a été attribué à Kenneth Wilson pour la découverte de ces applications inattendues, et l'élaboration de leurs détails.

Diverses stratégies de renormalisation ont aussi été appliquées récemment pour calculer de façon explicite les théories de systèmes classiques à N corps ou de polymères, comme par exemple, la méthode de représentation gaussienne équivalente (Baeurle et Nogovitsin 2007), (Baeurle, Charlot et Nogovitsin 2007), (Baeurle 2002).

Notes et références

- (en) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en anglais intitulé « Renormalization » (voir la liste des auteurs)

Voir aussi

Introductions générales

- (en)John Baez, « Renormalization Made Easy – une introduction qualitative au sujet », 2005. Consulté le 23 novembre 2009

- (en)Andrew E. Blechman, « Renormalization: Our Greatly Misunderstood Friend – résumé de leçon ; plus d'informations sur des schémas spécifiques de régularisation et de soustraction des divergences », 2002

- (en) Tian Yu Cao et Silvian S. Schweber, « The Conceptual Foundations and the Philosophical Aspects of Renormalization Theory », dans Synthese, Springer, vol. 97, no 1, 1993, p. 33-108 [résumé, lien DOI (pages consultées le 23 novembre 2009)]

- (en) Bertrand Delamotte, « A hint of renormalization », dans American Journal of Physics, vol. 72, 2004, p. 170-184 [texte intégral, lien DOI (pages consultées le 23 novembre 2009)]

- (en) Dmitry Shirkov, « Fifty Years of the Renormalization Group », dans C.E.R.N. Courrier, vol. 41, no 7, 2001 [texte intégral (page consultée le 23 novembre 2009)]

Principalement théorie quantique des champs

- (en) Nikolay N. Bogoliubov et Dmitry V. Shirkov, La théorie des champs quantifiés [« The Theory of Quantized Fields »], New York, Interscience, 1959

Le premier manuel sur la théorie du groupe de renormalisation

- (en) Richard P. Feynman, QED, l'étrange théorie de la lumière et de la matière [« QED, The Strange Theory of Light and Matter »], Penguin, 1990

- (en)Gerard 't Hooft, « The Glorious Days of Physics - Renormalization of Gauge theories : leçon faite à Erice (août/septembre 1998) par le [http://nobelprize.org/physics/laureates/1999/thooft-autobio.html prix Nobel de physique 1999] », 1998. Consulté le 23 novembre 2009

- (en)Daniel Iagolnitzer, J. Magnen, « Renormalization group analysis », 1996. Consulté le 23 novembre 2009

- (en) Helge Kragh, Dirac : biographie scientifique [« Dirac: A scientific biography »], Cambridge, Cambridge University Press, 1990

- (en) Stefan Pokorski, Gauge Field Theories, Cambridge, Cambridge University Press, 1987 (ISBN 0-521-47816-2)

- (en) Vincent Rivasseau, From perturbative to constructive renormalization, Princeton, Princeton University Press, 1991 (ISBN 0-691-08530-7)

- (en)Vincent Rivasseau, « An introduction to renormalization », octobre 2002. Consulté le 23 novembre 2009

- (en) Lewis H. Ryder, Théorie quantique des champs [« Quantum Field Theory »], Cambridge, Cambridge University Press, 1985 (ISBN 0-521-33859-X) [lire en ligne (page consultée le 23 novembre 2009)]

- (en) Günter Scharf, Finite quantum electrodynamics: The causal approach, Berlin, Springer Verlag, 1995 (ISBN 3-540-60142-2)

- (en) Steven Weinberg, The Quantum Theory of Fields, Cambridge, Cambridge University Press, 1995

Un traité monumental en 3 volumes, écrit par un expert renommé lauréat du Prix Nobel 1979.

- (en) Anthony Zee, Quantum Field Theory in a Nutshell : Un autre manuel de théorie quantique des champs excellent., Princeton, Princeton University Press, 2003 (ISBN 0-691-01019-6)

Principalement physique statistique

- (en) S.A. Baeurle, « Method of Gaussian equivalent representation: a new technique for reducing the sign problem of functional integral methods », dans Phys. Rev. Lett., vol. 89, 2002, p. 080602

- (en) S.A. Baeurle, M. Charlot et E.A. Nogovitsin, « Grand canonical investigations of prototypical polyelectrolyte models beyond the mean field level of approximation », dans Phys. Rev. E, vol. 75, 2007, p. 011804

- (en) S.A. Baeurle et E.A. Nogovitsin, « Challenging scaling laws of flexible polyelelctrolyte solutions with effective renormalization concepts », dans Polymer, vol. 48, 2007, p. 4883-4889

- (en) Laurie M. Brown, Renormalization: From Lorentz to Landau (and Beyond), Berlin, Springer-Verlag, 1993 (ISBN 0-387-97933-6)

- (en) John Cardy, Scaling and Renormalization in Statistical Physics, Cambridge, Cambridge University Press, 1996 (ISBN 0-521-49959-3)

- (en) Cyril Domb, The Critical Point: A Historical Introduction to the Modern Theory of Critical Phenomena, CRC Press, mars 1996 (ISBN 0-7484-0435-X)

- (en) Nigel Goldenfeld, Quantum Field Theory and Critical Phenomena, vol. 85, Westview Press, coll. « Frontiers in Physics », juin 1992 (ISBN 0-201-55409-7).

Couvrant les aspects élémentaires de la physique des transitions de phase et du groupe de renormalisation, ce livre de popularisation met l'accent sur la compréhension et la clarté plutôt que sur les manipulations techniques

- (en) Jean Zinn-Justin, Quantum Field Theory and Critical Phenomena, Oxford, Oxford University Press, 2002, 4e éd. (ISBN 0-19-850923-5).

Un chef-d'œuvre sur les applications des méthodes de renormalisation au calcul des exposants critiques en mécanique statistique, selon les idées de Wilson, lauréat du prix Nobel de physique 1982

- (en) Jean Zinn-Justin, Progress in Mathematical Physics, vol. 30 (ISBN 3-7643-0579-7) [lire en ligne (page consultée le 23 novembre 2009)], « Phase Transitions & Renormalization Group: from Theory to Numbers (séminaire Poincaré – Paris, 12 octobre 2002) »

Divers

- Alain Connes, Progress in Mathematical Physics, vol. 30 (ISBN 3-7643-0579-7) [lire en ligne (page consultée le 23 novembre 2009)], « Symétries Galoisiennes & Renormalisation (séminaire Poincaré – Paris, 12 octobre 2002) ».

Le mathématicien français Alain Connes (médaille Fields 1982) décrit la structure mathématique sous-jacente à la renormalisation (algèbre de Hopf), et ses liens avec le problème de Riemann-Hilbert.

- (en)Dmitry Shirkov, « The Bogoliubov Renormalization Group – JINR Communication E2-96-15 », 1996. Consulté le 23 novembre 2009

- (en)Zeta regularization applied to divergent integrals General Science Journal e-print service

- (en) Jean Zinn Justin, Proceedings of the NATO ASI on Quantum Field Theory: Perspective and Prospective : June 15-26 1998, Les Houches, France, vol. 530, Kluwer Academic Publishers, 1999 [lire en ligne (page consultée le 23 novembre 2009)], « Renormalization and renormalization group: From the discovery of UV divergences to the concept of effective field theories », p. 375-388

Wikimedia Foundation. 2010.