- Simulation de profil

-

Ajustement de courbe

L'ajustement de courbe est une technique d'analyse d'une courbe expérimentale, consistant à construire une courbe à partir de fonctions mathématiques et d'ajuster les paramètres de ces fonctions pour se rapprocher de la courbe mesurée — on parle donc aussi d'ajustement de paramètres. On utilise souvent le terme anglais curve fitting ou simplement fitting, pour désigner cette méthode ; on utilise souvent le franglais « fitter une courbe » pour dire « ajuster une courbe ».

Dans les cas simples, on peut utiliser une méthode de régression : régression multilinéaire si la loi est linéaire pour tous les paramètres, interpolation polynomiale lorsque l'on utilise un polynôme pour simuler le phénomène (les paramètres physiques pouvant être déduits des coefficients du polynôme).

Les méthodes de régression permettent de déterminer les paramètres à partir de calculs sur les données, mais sont inapplicables si la fonction est trop complexe. Il faut alors travailler par essai-erreur pour se rapprocher d'une solution. La solution n'est pas nécessairement unique. C'est une méthode des moindres carrés.

Sommaire

Fonction utilisée

Dans certains cas, on a un modèle théorique permettant de prévoir la forme de la courbe ; la méthode d'ajustement permet de déterminer les paramètres de l'échantillon. Dans d'autres cas, on utilise une fonction empirique ; on s'intéresse alors en général à la surface, la largeur ou à la position du maximum de la fonction.

De manière générale, on a une fonction ƒ ayant n paramètres p1, p2, …, pn qui relie l'abscisse x à l'ordonnée y :

- y = ƒ(p1, p2, …, pn, x)

et l'on compare cette fonction avec les m points expérimentaux

- [(x1, y1exp), (x2, y2exp), …, (xm, ymexp)]

La fonction ƒ peut être parfois décomposée en plusieurs fonctions ƒ1, ƒ2… soit qu'elle en est la somme, le produit, le produit de convolution…

- ƒ = ƒ1 + ƒ2 +…

- ou

- ƒ = ƒ1׃2×…

- ou

- ƒ = ƒ1*ƒ2*…

Démarche

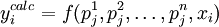

On calcule les points yical de la courbe simulée :

- yical = ƒ(xi )

Habituellement, on utilise un algorithme visant à minimiser l'écart quadratique entre la courbe simulée et la courbe expérimentale ; on parle d'algorithme de minimisation de l'erreur.

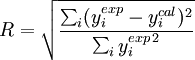

On définit donc un facteur de fiabilité (reliability factor) R :

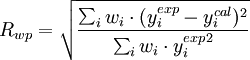

où yiexp est le i-ème point mesuré et yicalc est le i-ème point calculé. R est similaire dans son expression au coefficient de corrélation multiple (R ² étant alors le coefficient de détermination). On utilise plus couramment le facteur de fiabilité pondérée (weighted reliability factor) Rwp :

où wi est le poids attribué au point i ; ce poids représente l'incertitude associée au point i.

C'est donc un algorithme itératif : à chaque étape, on modifie un ou plusieurs facteurs et on regarde si cela provoque une diminution ou une augmentation de la fonction de fiabilité. Le jeu de paramètre retenu pour l'étape suivante est celui qui donne la plus faible valeur du facteur de fiabilité. Le calcul s'arrête lorsque l'on n'arrive plus à diminuer le facteur de fiabilité, on parle de convergence.

Si l'on note (pk) l'ensemble des paramètres, l'intensité calculée en chaque point i à l'étape j s'exprime par

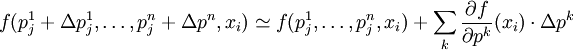

Pour simplifier les calculs, on peut faire un développement limité du premier ordre de cette fonction ƒ, alors en appliquant des petites perturbations Δpk aux paramètres, on peut écrire

en imposant yicalc = yiexp, on obtient ainsi un ensemble d'équations linéaires qui peut se résoudre par une inversion de matrice, ce qui permet de calculer les Δpk et donc les valeurs des paramètres à l'étape suivante j + 1. On peut aussi utiliser un algorithme plus complexe utilisant les dérivées secondes.

Il peut arriver que le programme converge vers un minimum local de R qui n'est pas le minimum absolu. Pour éviter cette situation, on utilise l'algorithme de Metropolis : lorsque l'on a convergé, on fait varier les paramètres d'une certaine valeur et on recommence le processus pour voir si l'on arrive à converger vers un autre jeu de paramètres ayant un facteur de fiabilité plus faible.

Si la simulation était parfaite, le facteur de fiabilité aurait une valeur dépendant du rapport signal sur bruit. Si l'on sait calculer ce rapport signal sur bruit, c'est-à-dire si l'on connaît la loi de probabilité régissant les fluctuations du signal, on peut alors déterminer un facteur de fiabilité incompressible R0. Si la simulation est parfaite, on a alors

- R = R0

de fait, la qualité de la simulation est souvent exprimée par le rapport R/R0, qui doit tendre vers 1 au fur et à mesure des étapes itératives.

Applications

- Déconvolution

- Méthode de Rietveld

Voir aussi

Articles connexes

Liens externes

- Développement d'un programme d'ajustement de courbes, Département de Physique-EEA de l'Université de Caen Basse-Normandie

Catégories : Analyse du signal | Calcul numérique

Wikimedia Foundation. 2010.