- Entropie Métrique

-

Entropie métrique

L'entropie métrique, ou entropie de Kolmogorov (se dit aussi en anglais measure-theoretic entropy) est un outil développé par Kolmogorov vers le milieu des années 1950 issu du concept probabiliste d'entropie de la théorie de l'information de Shannon. Kolmogorov montra comment l'entropie métrique peut être utilisée pour montrer si deux systèmes dynamiques ne sont pas conjugués. C'est un invariant fondamental des systèmes dynamiques mesurés. En outre, l'entropie métrique permet une définition qualitative du chaos : une transformation chaotique peut être vue comme une transformation d'entropie non nulle.

Présentons tout d'abord le cadre mathématique dans lequel on se place.

est un espace de probabilité, et

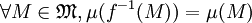

est un espace de probabilité, et  est une application mesurable, qui représente la loi d'évolution d'un système dynamique à temps discrets sur l'espace des phases X. On impose à f de préserver la mesure, c'est-à-dire que

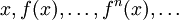

est une application mesurable, qui représente la loi d'évolution d'un système dynamique à temps discrets sur l'espace des phases X. On impose à f de préserver la mesure, c'est-à-dire que  . Partant d'un état initial x, on peut définir la suite des ses itérés par f :

. Partant d'un état initial x, on peut définir la suite des ses itérés par f :  L'ensemble

L'ensemble  des états par lesquels passe le système s'appelle l'orbite de x.

des états par lesquels passe le système s'appelle l'orbite de x.Sommaire

Construction de l'entropie métrique

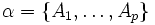

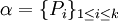

Si l'on se donne une partition finie α de X constituée d'ensembles mesurables

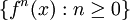

et un état initial x, les états fn(x) (

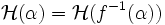

et un état initial x, les états fn(x) ( ) par lesquels le système passe tombent chacun dans une des parties de la partition α. La suite de ces parties fournit de l'information sur l'état initial x. L'entropie correspond à la quantité moyenne d'information apportée par une itération. La construction de l'entropie métrique est un processus qui se déroule en trois étapes, que nous allons expliciter ci-dessous. Dans un premier temps, on définit l'entropie

) par lesquels le système passe tombent chacun dans une des parties de la partition α. La suite de ces parties fournit de l'information sur l'état initial x. L'entropie correspond à la quantité moyenne d'information apportée par une itération. La construction de l'entropie métrique est un processus qui se déroule en trois étapes, que nous allons expliciter ci-dessous. Dans un premier temps, on définit l'entropie  d'une partition α (information moyenne issue de la connaissance de la partie de α dans laquelle se situe un point de x). Puis, on définit l'entropie h(f,α) de la transformation f relativement à la partition α (information moyenne apportée par une itération). Enfin, l'entropie métrique h(f) est la borne supérieure des entropies de f relativement aux partitions de X.

d'une partition α (information moyenne issue de la connaissance de la partie de α dans laquelle se situe un point de x). Puis, on définit l'entropie h(f,α) de la transformation f relativement à la partition α (information moyenne apportée par une itération). Enfin, l'entropie métrique h(f) est la borne supérieure des entropies de f relativement aux partitions de X.Entropie d'une partition

Soit α une partition finie de X en ensembles mesurables. Un point

est d'autant mieux localisé qu'il se situe dans une partie

est d'autant mieux localisé qu'il se situe dans une partie  de faible mesure μ(A). Ceci justifie l'introduction de la fonction information

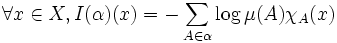

de faible mesure μ(A). Ceci justifie l'introduction de la fonction information ![I(\alpha) : X \to [0 ; +

\infty ]](/pictures/frwiki/100/dc4e8fa0d3a00b42a75e0e6e0f6dafd7.png) définie par :

définie par :c'est-à-dire I(α)(x) = − logμ(A) si

.

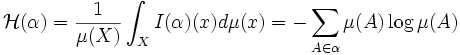

.L'entropie de la partition α est la moyenne de I(α) :

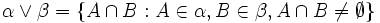

On prend 0log0 égal à 0. Si α et β sont deux partitions mesurables de X, on définit le joint de α et β,

la plus petite partition plus fine que α et β :

la plus petite partition plus fine que α et β :  . On dit que β est plus fine que α, et on note

. On dit que β est plus fine que α, et on note  si tout élément de A de α s'écrit comme union d'éléments de β.

si tout élément de A de α s'écrit comme union d'éléments de β.L'entropie d'une partition vérifie les propriétés intuitives suivantes :

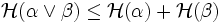

- Si α et β sont deux partitions mesurables, alors

.

. - Notons

. On a :

. On a :  .

.

La première propriété signifie que l'information apportée par la connaissance simultanée des positions des états du système relativement à deux partitions est inférieure à la somme des informations apportées relativement à chacune des partitions. La deuxième propriété provient du fait que f préserve la mesure.

Entropie d'une transformation relativement à une partition

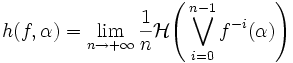

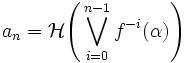

α est une partition mesurable. On définit l'entropie h(f,α) de la transformation f relativement à α par :

On peut voir la transformation f comme le passage d'un jour au suivant lors d'une expérience. Au temps zéro, on ne parvient pas à distinguer tous les états, on regroupe les états non distinguables par paquets, on forme de cette manière une partition α.

représente ainsi tous les résultats possibles au bout de n jours. h(f,α) est donc l'information moyenne quotidienne que l'on obtient en réalisant l'expérience.

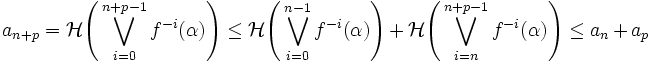

représente ainsi tous les résultats possibles au bout de n jours. h(f,α) est donc l'information moyenne quotidienne que l'on obtient en réalisant l'expérience.La limite définie existe bien. Si on note

, alors la suite

, alors la suite  est sous-additive car :

est sous-additive car :On a utilisé respectivement les deux propriétés de la section précédente.

admet donc une limite.

admet donc une limite.Dernière étape : entropie métrique d'une transformation

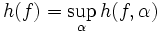

L'entropie métrique de f, notée h(f) est la borne supérieure des entropies de f relativement aux partitions finies mesurables de X

h(f) est éventuellement infinie.

Exemples de systèmes dynamiques et calcul d'entropie

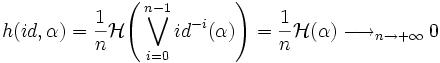

Le calcul de l'entropie métrique est facilité lorsque la borne supérieure est atteinte, i.e lorsqu'il existe une partition α telle que l'entropie métrique et l'entropie relativement à α soient confondues. À titre d'exemple, traitons le cas de l'application identité de X. Alors,

L'identité a une entropie nulle, ce qui est prévisible en raison de son caractère peu chaotique.

Dans beaucoup de cas moins triviaux, le théorème suivant, de Kolmogorov-Sinai, est l'un des outils les plus pratiques pour calculer une entropie, car il évite de prendre la borne supérieure sur toutes les partitions mesurables de X.

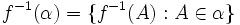

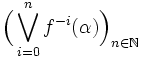

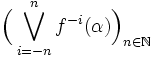

Si α est une partition mesurable de X telle que la suite

engendre la tribu

engendre la tribu  , ou bien si f est inversible (f-1 est mesurable et préserve la mesure) et la suite

, ou bien si f est inversible (f-1 est mesurable et préserve la mesure) et la suite  engendre la tribu

engendre la tribu  alors on dit que α est génératrice.

alors on dit que α est génératrice.Le théorème de Kolmogorov-Sinai affirme que si α est génératrice, alors h(f) = h(f,α).

Rotations du cercle

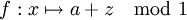

est le cercle unité, muni de la mesure d'angle dθ. Analysons l'effet d'une rotation

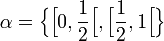

est le cercle unité, muni de la mesure d'angle dθ. Analysons l'effet d'une rotationlorsque a = p / q est rationnel. Soit α une partition :

Dans le cas où a est irrationnel, on montre également que l'entropie métrique de f est nulle.

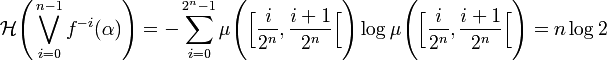

Doublement des angles

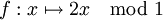

Toujours sur le cercle unité, on prend cette fois l'application

qui double les angles. On considère la même partition

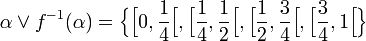

On observe que :

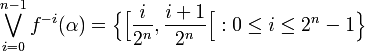

Puis par récurrence, on déduit plus généralement que :

Comme les ensembles du type

engendrent la tribu

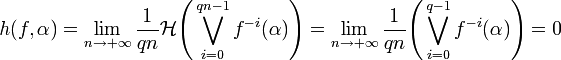

engendrent la tribu  , le théorème de Kolmogorov-Sinai montre que h(f) = h(f,α) et :

, le théorème de Kolmogorov-Sinai montre que h(f) = h(f,α) et :L'entropie métrique de f est donc log 2.

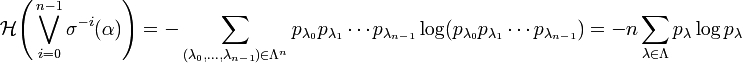

Décalage de Bernoulli

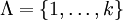

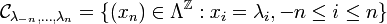

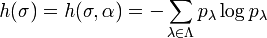

On dispose d'un alphabet fini

. Soit

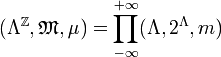

. Soit  des nombres strictement positifs de somme 1. On assigne à chaque lettre i la probabilité m({i}) = pi d'apparition. (Λ,2Λ,m) est un espace de probabilité. On introduit l'espace des mots infinis

des nombres strictement positifs de somme 1. On assigne à chaque lettre i la probabilité m({i}) = pi d'apparition. (Λ,2Λ,m) est un espace de probabilité. On introduit l'espace des mots infinis  . On définit l'application décalage σ par σ(x)n = xn + 1 pour

. On définit l'application décalage σ par σ(x)n = xn + 1 pour  .

.  est un système dynamique inversible. On partitionne

est un système dynamique inversible. On partitionne  en

en  où Pi est l'ensemble des mots

où Pi est l'ensemble des mots  tels que x0 = i.

tels que x0 = i.  est la partition par les cylindres

est la partition par les cylindres  . L'ensemble de ces cylindres engendrent la tribu de

. L'ensemble de ces cylindres engendrent la tribu de  et le théorème de Kolmogorov-Sinai s'applique. On calcule alors facilement :

et le théorème de Kolmogorov-Sinai s'applique. On calcule alors facilement :Donc

.

.Voir aussi

- Portail des mathématiques

Catégorie : Probabilités -

Wikimedia Foundation. 2010.