- Améliorée de Rao-Blackwell

-

Théorème de Rao-Blackwell

Le théorème de Rao-Blackwell permet à partir d'un estimateur (statistique) de construire un estimateur plus précis grâce à l'usage d'une statistique exhaustive. L'avantage de ce théorème est que l'estimateur initial n'a pas nécessairement besoin d'être très bon pour que l'estimateur que ce théorème construit fournisse de bons résultats. Il suffit en effet que l'estimateur de départ soit sans biais pour pouvoir construire un nouvel estimateur. L'estimateur de départ n'a entre autres pas besoin d'être convergent ou efficace.

Sommaire

Théorème

Si δ est un estimateur sans biais et S une statistique exhaustive alors l'estimateur augmenté

à une variance plus faible que la variance de l'estimateur initial. L'estimateur augmenté est donc toujours plus précis que l'estimateur initial si on l'augmente d'une statistique exhaustive.

à une variance plus faible que la variance de l'estimateur initial. L'estimateur augmenté est donc toujours plus précis que l'estimateur initial si on l'augmente d'une statistique exhaustive.Dans le cas multiparamétrique où l'estimateur et le paramètre sont en dimensions plus grands que 1 on remplace la variance par la matrice de variance-covariance. Le théorème de Rao-Blackwell donne alors:

Quel que soit A défini positif l'erreur quadratique en utilisant le produit scalaire défini par A est toujours plus faible pour l'estimateur augmenté que pour l'estimateur initial.

Le fait de pouvoir prendre n'importe quel produit scalaire et non seulement le produit scalaire usuel peut être très utile pour que les différentes composantes ne soit pas normés de la même façon. Ceci peut par exemple être le cas quand si une erreur sur l'une ou l'autre des composantes "coute plus cher" on pourra choisir une matrice de produit scalaire en fonction. L'estimateur augmenté sera toujours préférable même avec ce produit scalaire non usuel.

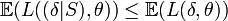

En fait le théorème de Rao Blackwell donne légèrement plus vu qu'il dit que quelle que soit la fonction de perte convexe L

. L'estimateur augmenté est donc toujours plus précis et ce quelle que soit la définition (raisonnable) que l'on donne à "précis".

. L'estimateur augmenté est donc toujours plus précis et ce quelle que soit la définition (raisonnable) que l'on donne à "précis".Exemple

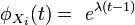

On considère donc n variables aléatoires Xi iid distribués selon des lois de Poisson de paramètre λ et l'on cherche à estimer e − λ. On peut montrer assez facilement en considérant le critère de factorisation que

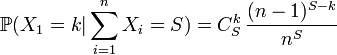

est une statistique exhaustive. Pour montrer l'intérêt de ce théorème on prend un estimateur grossier de e − λ: δ0 = δ(X1,0) qui vaut 1 si X1 = 0 et 0 sinon. Cet estimateur ne prend en compte qu'une seule valeur de X alors qu'on en dispose de n et il ne donne pour résultat que 0 ou 1 alors que la valeur de e − λ appartient à l'intervalle ]0,1] et ne vaut sans doute pas 1. (si c'était le cas Xi vaudrait 0 de façon déterministe et on s'en serai aperçu en regardant les données). Pourtant bien que cet estimateur soit très grossier l'estimateur augmenté obtenu est très bon et on peut même montrer qu'il est optimal. L'estimateur augmenté vaut:

est une statistique exhaustive. Pour montrer l'intérêt de ce théorème on prend un estimateur grossier de e − λ: δ0 = δ(X1,0) qui vaut 1 si X1 = 0 et 0 sinon. Cet estimateur ne prend en compte qu'une seule valeur de X alors qu'on en dispose de n et il ne donne pour résultat que 0 ou 1 alors que la valeur de e − λ appartient à l'intervalle ]0,1] et ne vaut sans doute pas 1. (si c'était le cas Xi vaudrait 0 de façon déterministe et on s'en serai aperçu en regardant les données). Pourtant bien que cet estimateur soit très grossier l'estimateur augmenté obtenu est très bon et on peut même montrer qu'il est optimal. L'estimateur augmenté vaut:On peut montrer que:

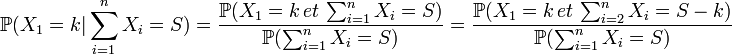

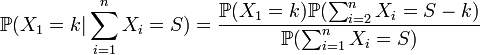

Détails du calcul

Et avec l'indépendance de Xi:

Si Xi suit une loi de Poisson de paramètre λ alors la fonction génératrice vaut

. Avec les propriétés de la fonction génératrice on en déduit que la somme de n variables iid suivant des lois de Poisson de paramètre λ est une loi de Poisson de paramètre nλ. On en déduit les probabilités et

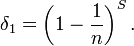

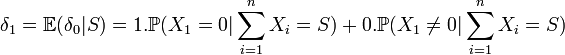

. Avec les propriétés de la fonction génératrice on en déduit que la somme de n variables iid suivant des lois de Poisson de paramètre λ est une loi de Poisson de paramètre nλ. On en déduit les probabilités et  X1 suis une loi binomiale B(S,1/n). La valeur en k=0 nous donne l'estimateur δ1. En effet,

X1 suis une loi binomiale B(S,1/n). La valeur en k=0 nous donne l'estimateur δ1. En effet,

δ1 est tout comme δ0 un estimateur de e − λ mais a l'avantage d'être beaucoup plus précis grâce à l'application du théorème de Rao–Blackwell.

On peut montrer que

est un estimateur optimal de λ (Voir Théorème de Lehman Scheffé) mais que l'estimateur optimal pour e − λ est différent de

est un estimateur optimal de λ (Voir Théorème de Lehman Scheffé) mais que l'estimateur optimal pour e − λ est différent de  .

.En fait bien que

soit un estimateur convergent de e − λ c'est un estimateur de relativement mauvaise qualité car il est biaisé et qu'en l'estimant de la sorte on fait une erreur systématique sur l'estimation. De façon général il peut être intéressant pour estimer f(λ) de construire un estimateur spécifique plutôt que de calculer la valeur prise par f par l'estimateur de λ.

soit un estimateur convergent de e − λ c'est un estimateur de relativement mauvaise qualité car il est biaisé et qu'en l'estimant de la sorte on fait une erreur systématique sur l'estimation. De façon général il peut être intéressant pour estimer f(λ) de construire un estimateur spécifique plutôt que de calculer la valeur prise par f par l'estimateur de λ.voir aussi

Références

- A. Montfort Cours de statistique mathématique, 1982, Economica. Paris.

Liens externes

- P. Druilhet [1] Cours de statistique interférentielle.

- Portail des probabilités et des statistiques

Catégorie : Estimation (statistique)

Wikimedia Foundation. 2010.