- Entropie Conditionnelle

-

Entropie conditionnelle

L'entropie conditionnelle est une mesure d'entropie utilisée en théorie de l'information. L'entropie conditionnelle mesure l'entropie restante provenant de la variable aléatoire Y, si l'on connait parfaitement la seconde variable aléatoire X. C'est l'entropie de Y conditionnée par X. Cette entropie est notée H(Y | X). Comme les autres entropies, l'entropie conditionnelle se mesure généralement en bits.

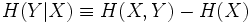

Étant données deux variables aléatoires X et Y avec pour entropies respectives H(X) et H(Y), et pour entropie conjointe H(X,Y), l'entropie conditionnelle de Y étant donné X est définie par :

Intuitivement, si le système combiné contient H(X,Y) bits d'information, et si nous connaissons parfaitement la variable aléatoire X, pour coder le système on peut économiser H(X) bits, et on n'a plus besoin que de H(Y | X) bits.

H(Y | X) = 0 si et seulement si la variable aléatoire Y est complètement déterminée par la variable aléatoire X. Inversement H(Y | X) = H(Y) si et seulement si Y et X sont des variables aléatoires indépendantes.

Voir aussi

Catégorie : Théorie de l'information

Wikimedia Foundation. 2010.