- Generation automatique de textes

-

Génération automatique de textes

La génération automatique de texte (GAT) [1] est un domaine du traitement automatique des langues dont l'objectif est de générer une forme linguistique à partir de données brutes, non linguistiques [2], à partir d'une représentation formelle d'un contenu.

Les premiers systèmes « réels » de GAT datent du début des années 1970.

Sommaire

Description

La GAT s'oppose à la compréhension du langage naturel, puisque cette dernière part du texte pour en saisir le sens alors que le but de la GAT est de transformer du sens en texte. Ceci se traduit par une plus grande variété d'inputs différents, en fonction du domaine d'application (alors que du texte restera toujours du texte). De plus, contrairement à la compréhension, la génération n'a pas à se soucier (ou dans une moindre mesure) de l'ambiguïté, de la sous-spécification ou d'un input mal formé, qui sont les principales préoccupations en compréhension[3].

Le problème majeur de la GAT est le choix . Cet embarras du choix se pose à plusieurs niveaux[4] :

- Contenu : Quoi dire ?

- Choix lexicaux et syntaxiques : Comment le dire ?

- Choix rhétoriques : Quand dire quoi ?

- Présentation textuelle (ou orale) : Le dire !

Ces choix sont loin d'aller de soi. Prenons les deux phrases suivantes[5] :

-

You can only stay until 4. -

You have to leave by 4.

Qu'on peut traduire approximativement par Vous ne pouvez rester que jusque 16 heures et Vous devez être parti pour 16 heures. Ces deux phrases partagent une synonymie sémantique évidente, mais elles diffèrent par une nuance communicative. La phrase (1) met l'emphase sur stay, (2) sur leave . Le choix lexical se fera en fonction du contexte : dans ce cas-ci, par exemple, si l'on souhaite porter l'attention sur l'activité en cours ou plutôt sur l'activité à venir.

Par conséquent, la GAT implique un grand nombre[6] de connaissances préalables[7] :

- Connaissance du domaine couvert

- Connaissance du langage spécifique de ce domaine

- Connaissance rhétorique stratégique

- Connaissance de l'ingénierie

- Connaissance des habitudes et contraintes de l'utilisateur final

La formulation optimale devra tenir compte d'une série de facteurs, tels que la grammaticalité, l'absence d'ambiguïté, la cohérence, l'effet rhétorique souhaité. Mais également des contraintes sociales, discursives et pragmatiques. Les théories fonctionnelles du langage sont très utilisées en génération, car elles tentent d'intégrer ce type de facteurs[2].

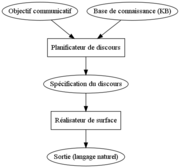

La figure ci-contre présente un exemple d'architecture pour la GAT. Les deux composants principaux de cette architecture sont le Planificateur de discours (Discourse Planner) et le Réalisateur de surface (Surface Realizer) . Le Planificateur sélectionne le contenu dans la base de connaissance et le structure en fonction de l'objectif communicatif. Ensuite, le Réalisateur de surface génère les phrases, selon les contraintes lexicales et syntaxiques qui lui sont implémentées, en suivant le plan spécifié par le Planificateur[8].

Formalismes théoriques

Les formalismes théoriques qui ont, à ce jour, eu la plus grande influence en GAT sont les suivants[9][10] :

- SFG (systemic-functional grammars) , grammaires systémiques-fonctionnelles. Utilisées pour l'accent qu'elles mettent sur l'aspect fonctionnel , notamment via l'utilisation de traits fonctionnels . Exemples de systèmes :

FUF[11] qui utilise le principe d'unification des traits ;KPML[12], système multilingue héritier dePENMAN. - TAG (tree-adjoining grammars) , grammaires d'arbres adjoints. Utilisées pour effectuer de la génération incrémentale .

- MTM (meaning-text model) , modèle sens-texte de Mel'čuk.

Notes

- ↑ En anglais natural language generation (NLG) .

- ↑ a et b Bateman & Zock (2003).

- ↑ Vander Linden (2000)

- ↑ Adapté de Bateman & Zock (2003) et de Vander Linden (2000).

- ↑ Exemple emprunté à McDonald (1991).

- ↑ Nombre qui varie bien sûr en fonction du domaine traité et de la précision recherchée.

- ↑ Adapté de Bateman & Zock (2003).

- ↑ Vander Linden (2000)

- ↑ D'après Bateman & Zock (2003).

- ↑ Pour un large aperçu de l'état de l'art, voir Bateman (2002).

- ↑ Elhadad (1992).

- ↑ Bateman (1997).

Références

- Bateman, J. (1997). Enabling technology for multilingual natural language generation: the KPML development environment. Journal of Natural Language Engineering, 3(1), 15-55.

- Bateman, J. (2002). Natural Language Generation: an introduction and open-ended review of the state of the art.

- Bateman, J. et M. Zock (2003). Natural Language Generation. The Oxford Handbook of Computational Linguistics. R. Mitkov (éd.), Oxford University Press, New York, 284-304.

- Elhadad, M. (1992). Using Argumentation to Control Lexical Choice: A Functional Unification-Based Approach. Ph.D. thesis, Department of Computer Science, Columbia University.

- McDonald, D. (1991). On the place of words in the generation process. Natural Language Generation in Artificial Intelligence and Computational Linguistics. C. Paris, W. Swartout et W. Mann (éds.), Kluwer, Dordrecht, 229-247.

- Vander Linden, K. (2000). Natural Language Generation. Speech and Language Processing: An Introduction to Natural Language Processing, Computational Linguistics, and Speech Recognition. D. Jurafsky et J.H. Martin, Prentice Hall, Upper Saddle River, New Jersey, 763-798.

Article connexe

Liens externes

Catégorie : Traitement automatique du langage naturel

Wikimedia Foundation. 2010.