- Test du Kappa

-

Kappa de Cohen

En statistiques, le test du Kappa mesure l’accord entre observateurs lors d'un codage qualitatif en catégories.

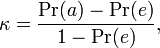

Le calcul du Kappa se fait de la manière suivante :

Où Pr(a) est l'accord relatif entre codeurs et Pr(e) la probabilité d'un accord aléatoire. Si les codeurs sont totalement en accord κ = 1. S'ils sont totalement en désaccord (ou en accord dû uniquement au hasard) κ ≤ 0.

L'article introduisant le kappa a pour auteur Jacob Cohen – d'où sa désignation de Kappa de Cohen – est paru dans je journal Educational and Psychological Measurement en 1960.

Le kappa est une mesure d'accord entre deux codeurs seulement. Pour une mesure de l'accord entre plus de deux codeurs, on utilise le kappa de Fleiss (1981).

Ordres de grandeur

Landis et Koch[1] ont proposé la table suivante pour interpréter le Kappa de Cohen. Il s'agit d'ordres de grandeurs qui ne font pas consensus dans la communauté scientifique[2], notamment parce que le nombre de catégories influe sur l'estimation obtenue – moins il y a de catégories, plus le kappa est est élevé[3].

κ Interpretation < 0 Désaccord 0.0 — 0.20 Accord très faible 0.21 — 0.40 Accord faible 0.41 — 0.60 Accord modéré 0.61 — 0.80 Accord fort 0.81 — 1.00 Accord presque parfait Notes et références

Liens externes

- Site sur le Coefficient Kappa

- Portail des probabilités et des statistiques

Catégories : Test statistique | Méthode d'analyse

Wikimedia Foundation. 2010.